Publicado por Comunicación AMC

Por Gerardo Barroso AMC, 9 de enero de 2020

Fotos cortesía Fernando Medellín

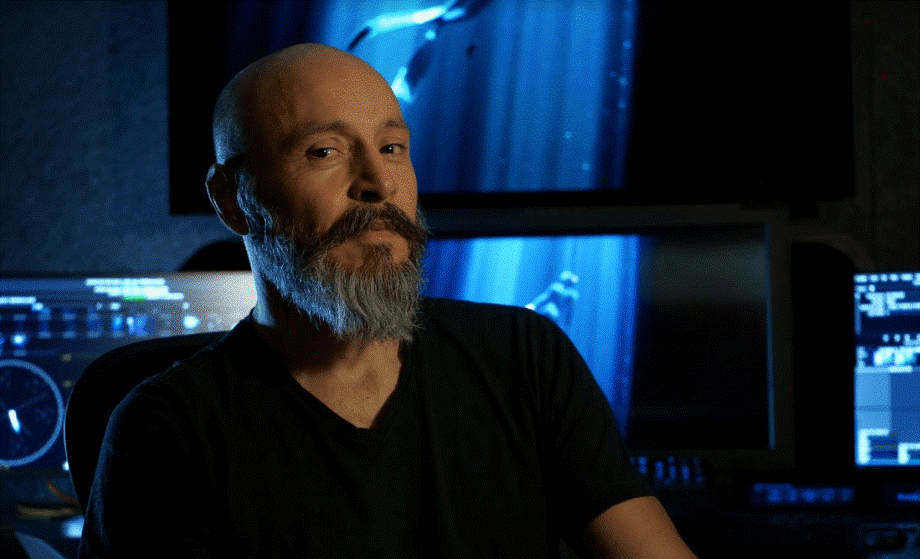

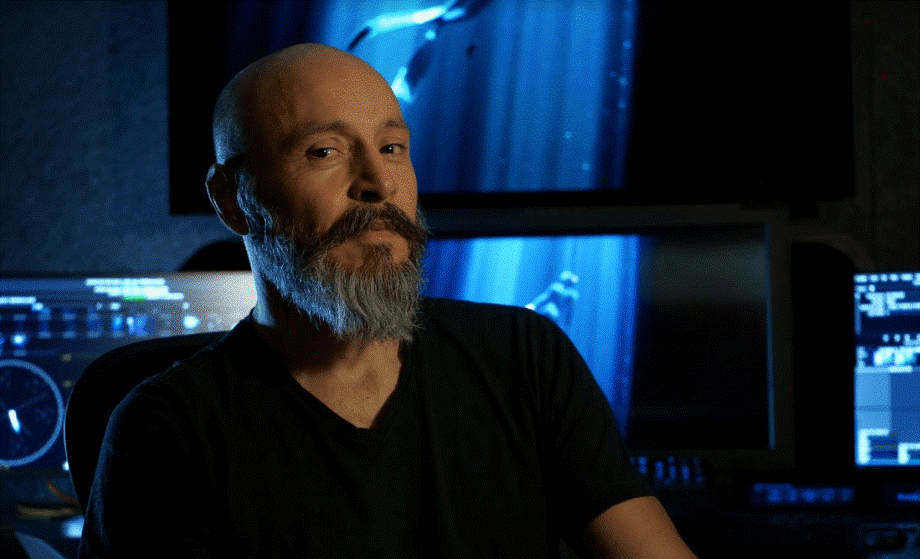

Estudié foto fija en la Escuela Activa de Fotografía. Hice foto comercial un tiempo, foto de autor otro rato y, por cosas del destino, terminé trabajando para Ollin Estudio, Casa de Postproducción. Al principio les hacía fotos de referencia para lo que modelaban en 3D. Un día Charly Iturriaga, que era el director de Animación, me invitó a trabajar con él haciendo iluminación digitalmente en 3D. Yo no conocía el software con el que trabajaba pero él me dijo: “Necesito a alguien que sepa cómo trabajar la luz, el software lo aprendes”. Fue así que empecé a practicar esto y comencé a hacer la iluminación en 3D. El estudio comenzó a crecer y, además de animación, comenzaron con On Line con Smoke, Flame e Inferno.

Aproximadamente un año después, el estudio instaló la primera sala de Telecine. En ese momento yo me la pasaba de sala en sala para atender más y más. Entonces fue cuando Charly me propuso quedarme en esa área y acepté. Comencé asistiendo al primer colorista que trabajó en Ollin, un español que hizo carrera en Londres. Con él aprendí todo sobre las máquinas. Después asistí a otros coloristas como Victor Bautista y José Luis Regalado “el Joe”, con quienes aprendí el oficio.

Gerardo Barroso: ¿Qué es lo que más disfrutas de tu oficio como colorista?

Fernando Medellín: Buscar el look junto al fotógrafo; llegar a un acuerdo sobre qué quiere ver y plasmarlo con el material con el que se cuenta. Ese reto es el más satisfactorio, obtener el mejor resultado lo más apegado a su visión.

GB: ¿En qué sistema te gusta trabajar más?

FM: Tengo mucho tiempo sentado en un Base Light; me tocó estrenar el primero que hubo en México. Siempre he estado de una u otra manera, ligado al software y hardware de la marca. Puedo corregir en varios sistemas, sin embargo, el Base Light es mi favorito. Siempre he pensado que la mejor herramienta es a la que más acostumbrado estás. El Resolve es muy buen software; hay muchas máquinas buenas para corregir, el Nu coda es muy poderoso, sin embargo, tengo tanto tiempo en el Base Light que es mi preferido.

GB: ¿Qué le recomiendas a un cinefotógrafo que está iniciando un proyecto?

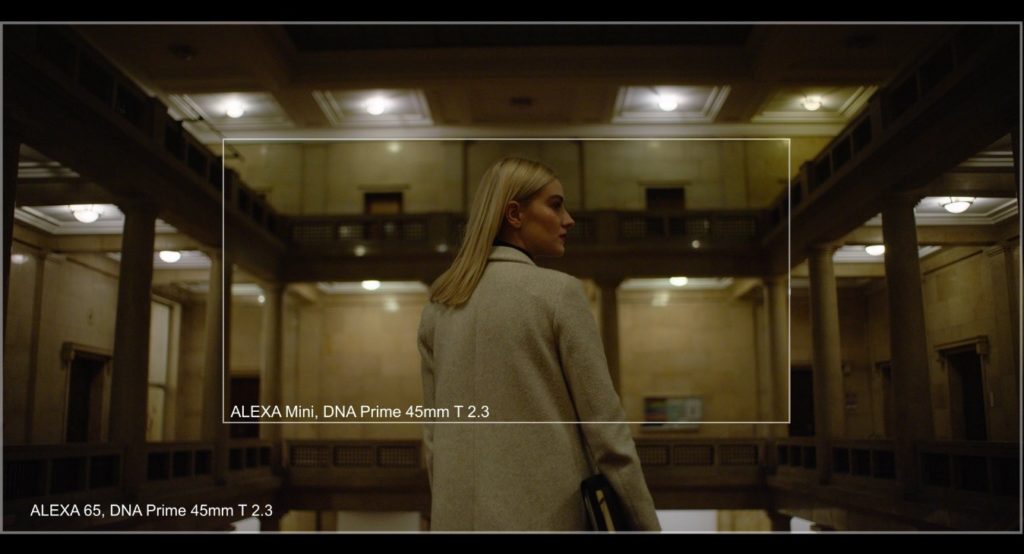

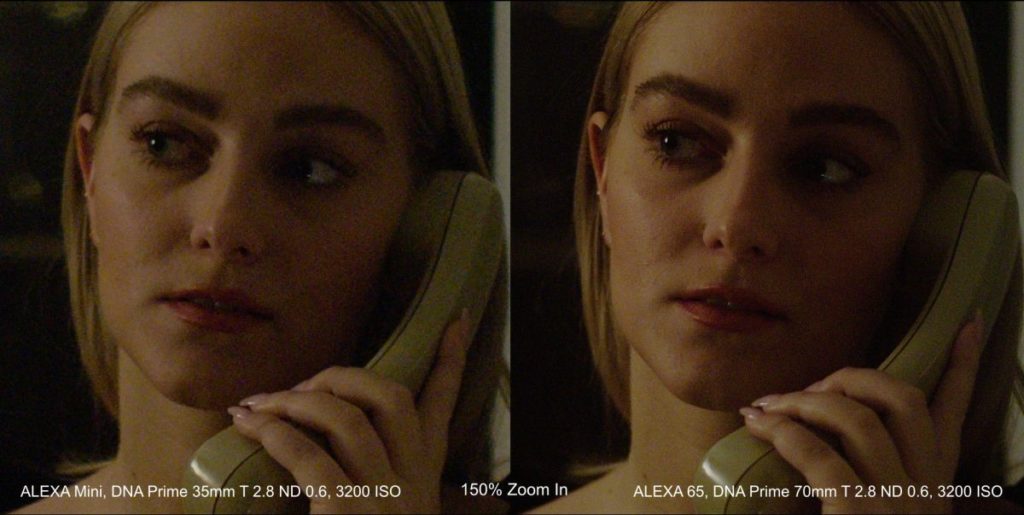

FM: Que prueben todo, cámaras y lentes. Que busquen su look y las texturas que les gustan o buscan para el proyecto. Trabajo mucho con Guillermo Granillo AMC, AEC y siempre trae pruebas de look y las corregimos. Entonces ya tiene una plancha para el set, ya tiene una idea de lo que va a ocurrir después con ciertos colores y ciertos contrastes. Cuando llega aquí, ya no hay sorpresas. Recomiendo que prueben, prueben todo lo que puedan, todo.

GB: Descríbenos el procedimiento ideal para lograr el look de una película.

FM: En mi experiencia las pruebas de look son muy importantes. Hacerlas con las diferentes iluminaciones que se proponen, porque muchas veces en esas pruebas se toman decisiones de óptica, de qué tan dura o suave será la luz, qué tanto color, y probar texturas, maquillajes, cómo le funciona la luz a los actores. Creo que es el mejor comienzo para que la imagen llegue a buen fin. Cuando ya está conversado, la búsqueda es más corta cuando comienza la corrección de la película. Corrijo esas pruebas de cámara, desde ahí genero archivos que se llaman BLG’s. Puedes cargar estos archivos en cualquier software de Filmlight y estos contienen la corrección de color que realizaste. Estando en locación se cargan en el Daylight en nuestras unidades móviles de Data y Dailies y se van ajustando en las diferentes condiciones de luz. Después esos BLG’s regresan a mi para la corrección de color. Digamos que funcionan en un 25 o 30 por ciento, pero ese porcentaje me sirve para ir dirigiendo la corrección de color de la película a cierto lugar. En lugar de invertir tiempo buscando un look, se invierte en mejorar lo que ya tenemos. Los BLG’s son como el DRX que es el archivo de color que importas para llevar la corrección de un Resolve a otro. Este archivo que se hace cuando grabas el still guarda la información de la corrección.

GB: ¿Cómo es la colaboración ideal con un cinefotógrafo?

FM: Definitivamente es involucrándome con él desde la propuesta, una vez que haya decidido hacia dónde quiere ir, hacer pruebas y ver de qué manera llegamos a lo que se busca. Al final mi trabajo es complementario y colaborativo, me gusta proponer para enriquecer la idea del cinefotógrafo.

GB: Danos un ejemplo de cuál sería el flujo perfecto para ti.

FM: Voy a poner un ejemplo que tal vez no es representativo dentro del mercado en México, pero es la manera más precisa con la que he trabajado, ‘Roma’. Con ‘Roma’ se generaban Dailies para editorial, tenía un DIT, un Data y un Video Assist. El Data se encargaba de guardar todas las imágenes, que nada se perdiera, y generaba los archivos para Dailies. De esos archivos nos separaba los clip’s que el director quería ver en su revisión nocturna. Esos clip’s se cargaban en el BaseLight y por las noches venían a revisarlos. De todo lo demás se hacía un back up en LTO’s y se mandaba al estudio para que empezaran la corrección de los Dailies editoriales que tenían un colorista que los emparejaba para que editorial lo viera uniforme y no hubiera saltos. Eso es el ideal. Mientras tanto lo que hacíamos con Alfonso Cuarón era tocar el material; veía cosas que le gustaban y otras que no e iba calificando y guardando referencias. Cuando los looks o LUT’s van y vienen del set al centro de postproducción y viceversa, es muy importante que todos trabajemos en el mismo espacio de color; si movemos cualquier cosa ya no funciona. Parece muy básico, pero es un error muy común.

GB: ¿Algún dato técnico que quisieras compartir con el cinefotógrafo?

FM: Podríamos hablar un poco de que es lo que pasa con el HDR. Hay gente que aun piensa que es como el de la foto fija. En foto fija se hacían dos o tres exposiciones, a veces cinco. Después, de todo hacías un Mix en el HDR SHOP o algún software. Entonces mezclarlas las imágenes y obteniendo los negros y blancos que deseabas. Había una técnica de ampliación en blanco y negro a la que llamaban ampliación por zonas y entonces usabas un papel multigrado; utilizabas un filtro para los negros, un filtro para los highlights y un filtro para los tonos medios. Esa era la manera análoga de hacer HDR en blanco y negro. La técnica es muy interesante. Sacabas exposiciones con cada uno de los filtros, después con la regla de tres sacabas los porcentajes por filtro para después sacar esos porcentajes en tiempo. Quedaban cosas espectaculares.

Seguimos pensando que de esa manera se hace el HDR en video. Algún tiempo la RED lo hizo así, capturaba dos cuadros de lo mismo, uno para las bajas y otro para las altas y después lo mezclaba. Corregí así una película chilena, ‘Hermanitos’, y dio muy buen resultado. Cuando se movían mucho las cosas tenían una especie de Motion Blur que no era realmente eso, sino un blending de las dos exposiciones, pero era muy aceptable y lo podíamos modular con un control en el corrector de color.

Lo que ocurre ahora con el HDR es que cambió el estándar de monitoreo. Cualquier imagen que esté capturada en 10 BIT o más es HDR. Cambió el monitoreo. Los monitores en estándar están calibrados a 100 NITS que es la unidad con la que se mide la luminancia de los monitores. El monitor X300 de Sony, ve hasta 1000 NITS y hay monitores más grandes que ven 3000 NITS y existe un Pulsar de Dolby que ve 5000 NITS. El cambio fue que ahora tenemos 10 veces más luz para ver la imagen y eso nos da imágenes más brillantes, con mayor profundidad de color y por supuesto con negros más profundos. Cuando se habla de las cámaras profesionales digitales de cine, siempre se habla de 14 pasos de rango dinámico; cuando lo veías en el momento te preguntabas ¿Dónde están?, tal vez veías 8. Con el HDR no vemos los 14 pasos, pero si vemos 12 o 13. Eso asusta a muchos porque no desean tener toda esa información. Lo interesante es que tenemos todo ese rango para discriminar y utilizar el que queramos. Puedes tener negros muy ricos con medios tonos increíbles y la imagen no tiene que ser muy contrastada. Lo que cambió fue la forma de ver.

GB: ¿Debes tener ciertas consideraciones para fotografiar el HDR?

FM: Sí. Estas imágenes hermosas que hacíamos a contraluz, en las que el fondo se volaba y eras capaz de lograr buen detalle al frente y no te importaba el fondo, resulta que, si ahora haces lo mismo, el fondo te deslumbra y tienes todo el detalle: se ven los cables, los pajaritos, los arbolitos. No es como lo que veíamos antes, esto sigue teniendo información y los highlights deslumbran. Hay que buscar la manera de suavizar la escena, hacer un key más bajito para lograr una imagen más apegada a lo que queremos ver porque al final esas imágenes pueden quedar muy crispis y te remiten al ‘video’. Debemos entender el HDR para lograr un look cinematográfico. Se puede obtener una imagen cinematográfica muy bonita en HDR. En resumen, hay que suavizar el contraste.

Respecto a los NITS de los monitores ADR, a partir de 300 NITS se considera HDR. Hay de 300, 400, 600, 1000, 2000, 3000 y de 5,000 NITS que es un pulsar de Dolby que trabaja con tanta potencia que no lo mueven de lugar; si quieres trabajar con él debes ir a Los Ángeles. Fue un prototipo y se decidió no fabricarlo, es muy complicado. Creo que el estándar, más allá de lo que estamos viendo ahora, va a quedar en no más de 600 NITS. Hay un problema de consumo de energía. Los monitores HDR tienen el doble o triple de consumo de energía porque aumentó muchas veces la luz que emiten. Las teles HDR comerciales ven 580, 550 NITS y las HDR 100 NITS.

GB: Describe la diferencia entre trabajar en un largometraje y una serie. ¿Cómo cambia la relación con el cinefotógrafo?

FM: Una de las diferencias, además de la duración, es el tiempo que te dan para corregir. Corregí una película en 50 horas para 75 minutos de duración, fue la película en la que menos tiempo he tenido minutos y hacen un capítulo a la semana. Por supuesto una película se detalla mucho más. La manera en la que me gusta trabajar es la siguiente: trabajo los primero 4 o 5 días con el fotógrafo en jornadas de no más de 6 horas haciendo ‘setup’ que es: pongo abierto, más plano y contraplano y las otras las ‘matcho’ en mi tiempo y así vamos secuencia por secuencia para ir marcando toda la película. Una vez que tengo eso me siento a hacer el ‘match’ fino. Después reviso con el fotógrafo nuevamente, ajustamos cosas, detallamos y una vez terminado esto, presentamos. Este proceso toma tres o cuatro semanas dependiendo de lo complejo de la película y las horas con las que se cuenta.

Cuando hago la corrección de una serie tengo que plantear muy bien el look con el fotógrafo desde el principio. Muchas veces revisamos el primer capítulo y después puedo trabajar prácticamente solo. A veces hay revisiones eventuales con el director o alguien más. En la última serie que corregí –‘Monarca’-, el director Fernando Rovzar, quien además era el show runner, venía a revisar todas las correcciones de color. Era un capítulo por semana por lo que había que corregir, revisar, ajustar y pasar a SDR porque esta serie se corrigió en HDR. Eso nos dejaba tres días de color porque además debíamos presentarla. Las series son menos detalladas, pero debes ser más eficiente y ver la manera de lograrlo, de no meterte el pie. Tengo muchos años en esto y ya no me conflictúa el tiempo, lo puedo lograr. Hay que ir midiendo ‘qué tanto es tantito’ y hasta dónde trabajas o sobre trabajas la imagen. En las películas te puedes dar lujos que, en las series no.

GB: ¿Cómo manejas la calibración?

FM: Decidimos no hacerlo internamente, son muchas salas, son varios monitores y no nos daba el tiempo de calibrar. Decidimos contratar un servicio externo que está a cargo del Ingeniero Carlos González quien calibra nuestras salas. Por ejemplo, uno de los procedimientos que seguimos, cuando la lámpara del proyector es nueva la voy calibrando cada mes; al tercero o cuarto la lámpara ya se estabilizó. Eso me da más rango y puedo calibrar cada dos meses, la lámpara es muy estable a partir de ahí. Los monitores son mucho más estables, entonces aprovecho los días de calibración del proyector para revisarlos.

La calibración se hace con un ‘chupón’ a D65 (6,500 grados Kelvin), con las diferentes especificaciones que necesitamos. Para el proyector se hace la calibración para P3 (Espacio de color) y para REC709 porque me gusta tener una referencia de REC709. El monitor X300 lo hacemos en REC709, en SDR y en PQ para HDR. En ÓXIDO tenemos otra sala con un plasma que es únicamente REC709, entonces hacemos REC709 1886 y con eso tenemos. De la mano va la calibración de los monitores que salen al set en las camionetas de DATA. Estos se calibran de la misma manera, con el mismo Ingeniero y sobre los mismos parámetros para tener el estándar de la casa; de igual manera se hace con los On Line.

GB: Si voy a subexponer, ¿Cómo debería dejar mis niveles?

FM: Creo que en esta época del Intermedia Digital nos conviene estar un poco más arriba de luz cuidando que los High Lights no se vuelen. Estas noches sobreiluminadas a las que tememos tanto, con el Intermedia es muy fácil bajarlas y ponerlas donde quiera en lugar de sacrificar el detalle en el set porque la noche tiene que ser más oscura. Aquí entra la explicación de la visión auditiva que tenemos los seres humanos, es decir, no es que veamos todo el rango, sino que nuestra memoria es increíble y registra lo que hay en las sombras y lo que hay en las luces y tu cerebro lo compone. Eso no ocurre con los sensores por lo que debemos ‘truquear’. Entonces, claro, si sobreiluminas una noche o la mandas un poquito más arriba, nos va a permitir tener mejores rangos y observar mejor, aunque no sea una noche real sino una noche cinematográfica. No tienen que ser las noches como las de la película ‘La máscara’ que parecen medio día pintadas de azul. Hay cosas más elegantes. Es un poco como cuando exponías el negativo; exponías a las sombras, revelabas a las luces. ¿Por qué exponías las sombras?, porque lo que no habías capturado en el negativo no había manera de rescatarlo. Voy a poner un ejemplo: En ‘Desierto adentro’, el maestro Serguei Saldívar Tanaka AMC, iluminaba el desierto de noche con una super luna y toda la idea partió porque sabía que se haría con Intermedia Digital y le podríamos bajar. Habíamos hecho unas pruebas en el Telecine y el problema que teníamos para hacer ‘Day for Night’ – que también se había planteado -, era que las piedras en el desierto brillaban mucho y había blancos que no lográbamos bajar y habría que entrar a VFX. Entonces el maestro Serguei decidió iluminar más sus noches y en la corrección de color las llevamos al punto en el que funcionaban perfectamente. Algo increíble de esa película es que, además de que las noches se ven muy bien al igual que el resto, es que fue filmada en Super 16mm y solo lo notas en ciertos High Ligths en los que el grano tiene alguna actividad.

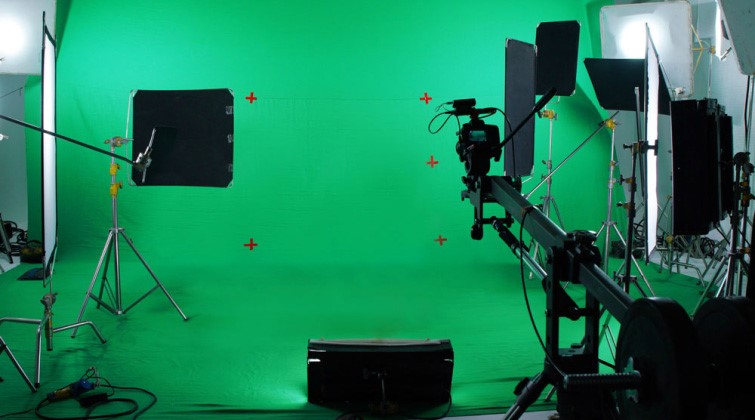

GB: ¿Cómo manejas los VFX?

FM: Hay que tener muy claro que debes mandar un archivo correcto y lo debes recibir de vuelta de la misma manera en la que lo mandaste. Si hay algún cambio, como colorista eres responsable de decir ‘Esto no sirve’, devolverlo y que se haga de manera correcta. Deberán devolverlo en el espacio de color y en el formato que tú enviaste, eso es lo primer que debe ocurrir o tendrás muchos problemas. Si se cambia el balance de color o el espacio del mismo, es muy complicado llegar a ‘matchar’ las texturas y colores contra las imágenes que no fueron a VFX. Normalmente la corrección de color va paralela a la generación de los VFX, entonces, si ya pusiste un ‘look’ y te devuelven otro espacio de color o alguna modificación de color, tendrás que rehacer las cosas e implicará tiempo extra con el que, generalmente, no se cuenta.

Lo más importante es el manejo de los espacios de color. Muchas veces, conviene estandarizar en algún archivo que sea más amable para la ida y venidas. Cuando hablamos de un DPX resulta que tiene alrededor de 6 maneras de interpretarse, entonces al final no sabes cómo lo está viendo quien lo está viendo y cómo se va a ver cuándo tú lo abras y dónde lo hagas. Definitivamente también el camino de los TIFFS está errado, pero puedes trabajar en EXR’s que es el archivo profesional para hacer estas cosas y buscar que lo que entregas sea transparente.

Cuando hay cosas que tienes que acabar de entregar en la corrección de color como contrastes o pantallas, o por ejemplo de un green screen en el que cambian un paisaje, en esos casos siempre pido el Matte. Con el Matte trabajo aparte del compuesto que hayan hecho, lo mismo de las pantallas. Me parece que esa es la manera correcta de trabajar. En Óxido trabajamos con NUKE y entonces mando logarítmico, ellos lo monitorean en REC709 y lo regresan logarítmico, de esta manera garantizas el resultado correcto.

GB: ¿Hoy en día se le da el reconocimiento adecuado al colorista?

FM: No. Aquí hay ciertas posiciones encontradas. Hay fotógrafos que están de acuerdo en que el colorista tenga un crédito más importante, sin embargo, hay quienes no; es un tema delicado. Al final es un trabajo colaborativo. Yo digo ‘El colorista es al fotógrafo, lo que el editor al director’. Aunque el director dirigió, el que termina contando la historia es el editor. Cuando hablamos del fotógrafo y el colorista, aunque el fotógrafo obtuvo las imágenes, el colorista termina logrando la intención, esa es la importancia del colorista. Entonces me parece que este oficio está menospreciado. Estamos creando ‘Coloristas Asociados de México’ y lo que buscamos es tener mayor reconocimiento. Buscaremos apoyo de La Academia, por supuesto de los cinefotógrafos vía la AMC para llegar a los productores de una manera suave y no impositiva, buscando más el reconocimiento colaborativo y laboral que meramente por ego. Con La Asociación buscamos dignificar la profesión. Históricamente para la industria, del tamaño que sea en México, el colorista ha sido un personaje importante. Es el encargado de atraer clientes a las casas de postproducción. Sin un colorista reconocido es poco probable que crezcas como casa de post.

Es un personaje tan importante como el supervisor de VFX o el postproductor. Son roles que pesan. Si revisamos una película de los cincuenta o sesenta, no existía el colorista como tal, pero existía el ‘color timer’. En muchas de

esas películas el cartón principal al inicio dice ‘Color by Technicolor’ y debajo de eso el nombre del Color Timer, ‘Color by Deluxe’ y debajo el nombre del responsable del color timer. ¡Era un personaje importante! En algún momento dejó de pesar por algo, tal vez por falta de interés del gremio, tal vez desertaron de algún sindicato que los obligaba a poner el crédito, no sé. Era un personaje reconocido y de pronto se vino a menos.

GB: ¿Consideras que en este país se proyecta con los estándares adecuados en las salas de cine?

FM: No, no se proyecta correctamente. La experiencia que hemos tenido cuando vamos a una sala a revisar porque habrá una premiere o el director o cinefotógrafo tienen la inquietud de cómo se va a ver en sala, normalmente la lámpara no está al 100%, nunca está donde debe; es decir que en lugar de tener los 14 Foot Lamberts, estás viendo 10 u 11. Definitivamente no ves lo que debieras ver hablando de luz; de color no quiero ni mencionarlo. La lámpara siempre está castigada, por decirlo de alguna manera. La luminosidad del proyector y la calibración también son cosas para tomarse en cuenta.

Muchas veces entras a una sala a ver una película normal pero la sala está preparada para 3D y la película no lo es; resulta que la pantalla es Silver y le roba dos pasos, entonces la ves opaca. No vemos lo que tenemos que ver. Sin duda la vida de las películas es el BluRay y el streaming; es un ambiente más calibrado o más controlado. Podemos hablar un poco del Dolby Visión que ahora conocemos por requisito de Netflix para el HDR. El Dolby Vision es con lo que se hace la conversión de HDR a SDR casi automáticamente; ajusta la curva al monitoreo que tienes y tienes un Layer para hacer un Trim para que las cosas se vean mejor y todo eso viaja en Metadata, no en imagen. Entregas una vez la imagen en HDR y lo demás es un XML que modifica las curvas dependiendo de la pantalla que tengas en casa. Esta información se lee y decide qué señal manda a tu tele.

El primer acercamiento de Netflix con Dolby no fue por el HDR – que todavía no existía, sino que tenían una preocupación por hacer que sus productos se vieran como se tenían que ver en cualquier lugar. Lo que buscaban con el Dolby Visión era que cuando bajaras cualquier contenido de Netflix, llegara una señal a tu tele y le ‘dijera’ como la tenía que reproducir para de esta manera cuidar la calidad de sus contenidos hasta la reproducción final.

GB: ¿Cómo puede mejorar la industria de la imagen en movimiento en México?

FM: Creo que tenemos que pensar en los contenidos, definitivamente tienen que ser mejores. En México tenemos grandes fotógrafos y grandes realizadores sin duda alguna, pero nos estamos quedando cortos en contenidos. Esta ola de remakes de comedias, más allá del beneficio económico que tengan, han dementado mucho el contenido. Creo que es importante seguir contando historias originales, no solo formulas probadas. La imagen en México es muy buena, podría decir que es excelente, pero sería bueno contar con mejores historias.