Fujinon está probando su lente de caja 8K SK35-700 con montura PL con una variedad de cámaras, incluidas Sony Venice y Arri Amira, para lograr un aspecto cinematográfico sin sacrificar la necesidad de capacidad de zoom.

AMERICAN CINEMATOGRAPHER

Setiembre del 2021

Por Carl Mrozek

Los organismos de radiodifusión adoptan las herramientas y el lenguaje visual del cine, uniendo películas y los principales deportes de forma dinámica.

Fox Sports hizo historia el 12 de agosto de 2021 al transmitir el primer juego moderno de Grandes Ligas de Iowa, específicamente, desde cierto campo de maíz famoso con un diamante incorporado. Este también fue el primer juego de temporada regular que se filmó con las nuevas plataformas de cámara estilo cine montadas en cardán de la división de programación para una transmisión en vivo. Un objetivo clave del juego era conmemorar la película clásica de 1989 Field of Dreams, y hacer de este campo de maíz un paraíso de hardball nuevamente, al menos por una noche.

Si lo construye

Tras su lanzamiento, Field of Dreams, dirigida por Phil Alden Robinson y filmada por John Lindley ASC, volvió a involucrar a millones de fanáticos estadounidenses con su pasatiempo nacional. La transmisión de Fox Sports «Field of Dreams» tenía como objetivo reforzar esa misma conexión con el béisbol durante la era UHD actual, que ahora puede estar en la cúspide de incorporar el «aspecto cinematográfico» en otros deportes televisados de las grandes ligas también, incluido el fútbol, baloncesto, golf y hockey. La transmisión de “Field of Dreams” fue la culminación de dos años de planificación y preparación, retrasados más de un año debido a la aparicion de la pandemia de Covid-19.

Fox Sports ha estado a la vanguardia del matrimonio en ciernes entre la transmisión deportiva y la realización de películas desde al menos fines de 2020. “Hemos estado hablando bastante sobre el uso de herramientas de cine para inyectar elementos cinematográficos en nuestra transmisión que conmemora una de las mejores películas de béisbol de la historia” dice Mike Davies, vicepresidente senior de operaciones técnicas y de campo en Fox Sports.

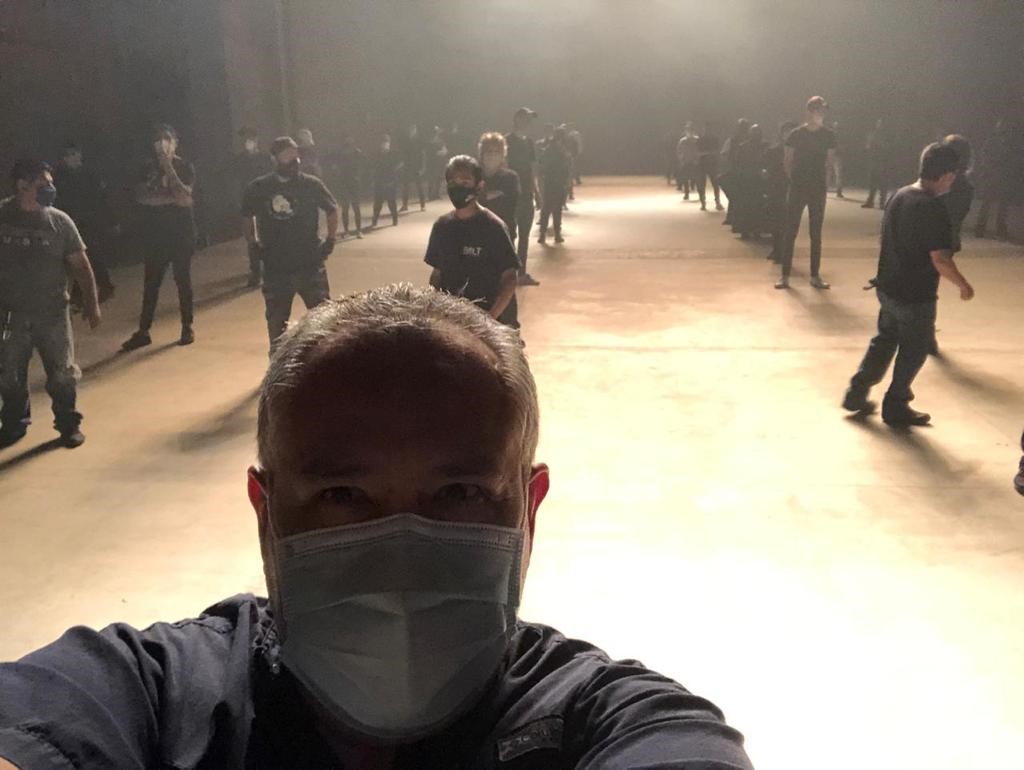

El equipo de Fox Sports se prepara para rodar el juego «Field of Dreams» en Iowa.

Para lograr este objetivo, además de desplegar su complemento normal de cámaras 4K de 3 chips Sony HDC-4300L ⅔» y otros modelos de transmisión, Fox alistó estratégicamente varias unidades especializadas, incluidos varios drones, con al menos dos en el aire en todo momento . Uno de los drones estaba equipado con un Komodo rojo, que capturaba imágenes de los campos de maíz y la comunidad local de Iowa, en particular, tomas del mítico diamante de las grandes ligas ubicado en el corazón de este paisaje bucólico.

Para lograr aún más el «aspecto cinematográfico», con su profundidad de campo claramente reducida, Fox empleó un par de paquetes de cámaras de cine diseñado para la cobertura de juegos en vivo por Jarrod Ligrani, director técnico de FOX NFL. Apodado el «Megalodon», el equipo consta de una cámara Sony a7R IV, de la línea Alpha de la compañía, montada en un cardán DJI Ronn-S, con un monitor de campo de 6″, además de una mochila para baterías externas y un transmisor inalámbrico de 1080p.

El director técnico de Fox Sports, Jarrod Ligrani, con su unidad móvil “Megalodon”.

El a7R IV cuenta con un sensor CMOS de fotograma completo de 61.0 MP, con un ISO de 100 a 32,000. Lo más importante para el uso deportivo es la matriz de enfoque automático de 567 puntos del sensor y la capacidad de grabar 1080p a hasta 240 fps.

Para el béisbol y el fútbol, Fox Sports combina principalmente el a7R IV con una lente Sony FE 24-70 mm f / 2.8 GM, lo que ofrece flexibilidad al hacer posible llenar el encuadre con un jugador desde 20 ‘de distancia y desde 6’.

«En los deportes, la acción puede escalar repentinamente, lo que dificulta la coordinación con un foquista», dice Davies. “Con un DOF de menos de 2 pies, no hay mucho margen de error, pero el enfoque automático de la Alpha ha demostrado ser confiable y se ha convertido en nuestra cámara cinematográfica preferida. Tuvimos a dos de ellos en acción en el juego ‘Field of Dreams'».

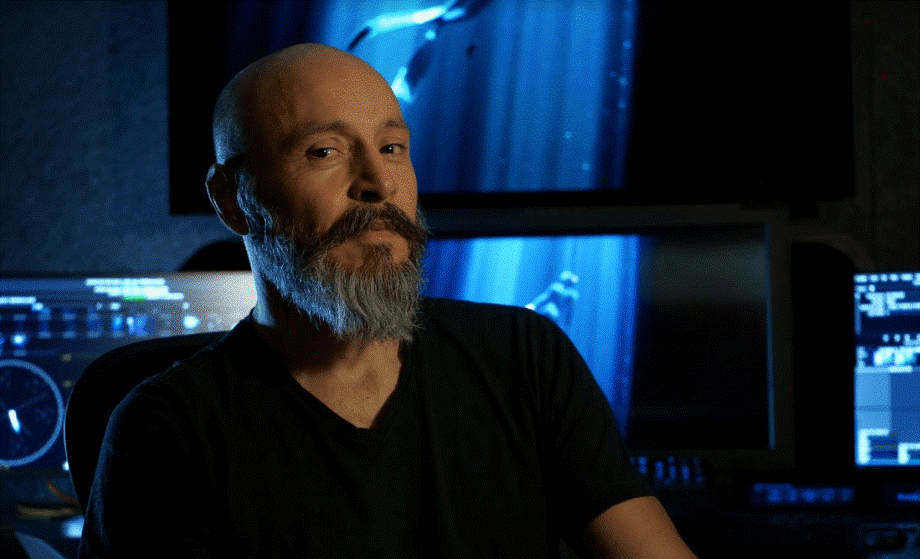

Ligrani demuestra su unidad móvil “Megalodon” para el corredor de los Dallas Cowboys, Ezekiel Elliott.

Durante el evento único, Fox Sports también utilizó una cámara compacta Sony HDC-P50 de 3 chips de ⅔»emparejada con el Movil de Freestyle .cardán como una cámara de mano. Las tres cámaras móviles estaban en acción durante los programas previos y posteriores al juego, y durante la mayor parte del juego. «Usamos Megalodons para los [tomas] de ambos equipos [caminando] desde el campo de maíz al campo de béisbol, y para las presentaciones de los jugadores», describe Davies.

“Durante el juego, los usamos dentro de los dugouts, para [tomas de jugadores que salían del campo] después de las carreras, y para correr desde la tercera hasta el home, incluido el trote de carreras cuando finaliza el juego y la celebración justo después del juego». Agrega que esta fue la primera vez que Fox Sports desplegó a los Megalodons en un juego de béisbol de temporada regular, después de los previamente en el juego All-Star de 2021, así como durante los juegos de final de temporada de la NFL, el torneo de baloncesto Big East Conference. Carreras de Nascar, los partidos de Premier Boxing Champions, e incluso el Westminster Kennel Club Dog Show.

Entendiendo

Otros locutores deportivos también han adoptado el Megalodon, en particular la Marquesina Roja de los Cachorros de Chicago. Mike Fox, el director de la cadena, dice: “Nos encantó el Megalodon tan pronto como Jarrod lo demostró. Me ofrecí a alquilarlo por la temporada. Con el DOF poco profundo de Megalodon, la imagen central es clara como el cristal y realmente te llama la atención. La televisión es principalmente un mundo en 2D, y me emociono mucho cada vez que podemos hacer que parezca más tridimensional».

Un operador de Marquee Network captura imágenes fuera de Wrigley Field.

Al igual que en el juego «Field of Dreams», donde los Megalodons jugaron un papel clave en hacer del campo de béisbol en un campo de maíz la estrella del espectáculo, Fox usa la configuración para hacer del Wrigley Field de los Cachorros un personaje principal en cada juego de pelota. «Usaré tomas amplias del estadio de béisbol, que a menudo incluyen la espesa hiedra en las paredes de los jardines y los enormes pilares detrás del plato», dice. “Me encanta incorporar el enorme marcador manual, rematado con un gran reloj antiguo, con ventiladores en primer plano. A veces están jugando a atrapar, o tomando selfies, o haciendo fila para entrar al parque, pero con el clásico marcador de Wrigley detrás de ellos».

Fox también despliega el Megalodon específicamente para entretejer a los fanáticos en la transmisión del juego. “Nos encanta registrar a los fanáticos que cantan el himno nacional, durante el tramo de la séptima entrada, comemos y bebimos en el patio de comidas y en las gradas, o hablamos con los jugadores alrededor del dugout, atrapando bolas de foul y todo tipo de B-roll», él dice. «La fuerte señal de RF nos permite flmar en cualquier lugar dentro y alrededor del estadio. Sobre todo, me encanta lo fácil que [el Megalodon] hace destacar a los jugadores aislándolos de todo lo demás, convirtiéndolos en estrellas por al menos un momento».

Ligrani estuvo a la vanguardia en reconocer el potencial del a7R IV sin espejo para transmisiones deportivas en vivo. «Habíamos estado usando Alphas en una capacidad limitada para la cobertura de juegos de la NFL, pero no en vivo», dice. “Los tiradores tenían que seguir corriendo hacia el camión para descargar tomas seleccionados durante todo el juego. Eso cambió cuando encontramos una empresa belga que fabricaba un transmisor de RF compacto y eficiente que cabía fácilmente en una mochila pequeña».

Ligrani también resolvió otros desafíos, incluido un problema de alimentación y un problema de sobrecalentamiento, al crear una fuente de alimentación externa utilizando baterías Anton / Bauer Gold Mount o V-Mount intercambiables en caliente. «El sobrecalentamiento puede ser un problema con Alpha, especialmente a velocidades de cuadro más altas», dice. «Sacar las pilas de la cámara ayudó». Agrega que «un Sunbrella también ayuda cuando se registra al sol durante horas».

Expandiendo el campo

Las cámaras de cine más grandes también se han abierto camino en el campo de juego. CBS probó varios a multas de 2020 durante la temporada de la NFL. «Nos apoyamos en [CineAlta] Venice [de Sony] [en una Steadicam] durante los juegos finales de la temporada 2020 de la NFL, y continuamos durante los playoffs», dice Josh Cohen, consultor editorial de CBS Sports, quien le da crédito a Mike Arnold, director principal de juegos de la NFL en CBS Sports, por el esfuerzo. Los comentarios de los fanáticos fueron intensos en las redes sociales, durante y después de los juegos. “Los fanáticos notaron la diferencia de inmediato, inundándonos con comentarios como, ‘Parecía una película’”, dice Arnold. «Eso nos impulsó a seguir experimentando con estas cámaras DOF poco profundas».

En los juegos de la NFL, las cámaras de cine ya han llenado nichos clave, como destacar las celebraciones de touchdown, que se han vuelto cada vez más llamativas y creativas, así como las tomas de jugadores que entran y salen del campo en el medio tiempo y después del juego. Inevitablemente, el DOF poco profundo creó desafíos en un entorno acelerado. Arnold explica: «A veces, el DOF superficial era problemático en el modo de enfoque automático al centrarse en la multitud en el fondo en el lugar del jugador en el primer plano, si no en el cuadro completo, o al enfocarse en el jugador equivocado en un scrum».

Arnold señala que CBS en realidad no probó el paquete Alpha más pequeño hasta el juego más importante de la temporada. “Para el Super Bowl, decidimos agregar un segundo paquete de cámara de cine, una Alpha IV [Sony] en una plataforma de cardán Movi, para nuestro paquete complementario Venice / Steadicam”, dice. “Rápidamente quedamos impresionados con lo bien que se desempeñó el enfoque automático del Alpha y con su excelente calidad de imagen. Tuvimos que pasarlo por un corrector de color, pero ayudó [que fuera] una cámara Sony para empezar, en términos de igualar el color con la Venecia y con nuestras cámaras de transmisión Sony”.

CBS también implementó el paquete Alpha para torneos de golf profesionales y las principales carreras de autos. “Reemplazamos una cámara ENG con el paquete Alpha en un Movi para el PGA [Tour] y durante las carreras SRX [extreme auto]. También nos complació el rendimiento de la EOS-C300 de Canon en las carreras. Cada una de las cámaras de cine digital que hemos probado ha tenido sus puntos fuertes que la opción en una mejor opción para algunas aplicaciones deportivas que otro modelo, y viceversa”, dice Jason Cohen, vicepresidente de operaciones técnicas remotas de CBS Sports.

Después de probar en la carretera diferentes modelos de cámaras de cine en varios deportes, dice Cohen, CBS aún planea mantener abiertas sus opciones, entrando en la temporada 2021-22 de la NFL. «Lo que sabemos con certeza es que vamos a mantener la relevancia del DOF superficial en nuestro mejor juego de la NFL cada semana», dice. “Sin embargo, todavía estamos en el proceso de determinar cuál será el sistema y qué modelos usaremos de una semana a otra. Sigue siendo una conversación fluida».

Jeff Silverman, fundador y presidente de la compañía de cámaras especializadas Inertia Unlimited, ha estado con locutores deportivos, incluida CBS, sobre una variedad de desafíos de cámaras durante casi una década. Últimamente, muchos de ellos están relacionados con cámaras estilo cine. “Para el Super Bowl, un desafío clave fue cómo integrar el aspecto de algunas cámaras estilo cine con otras 122 cámaras [que cubren el evento], especialmente con el caballo de batalla Sony(HDC) 4300s, que dominan las transmisiones deportivas en los EE. UU.”. Silverman agrega que siente que la colorimetría nativa de las cámaras Venice y Alpha de Sony pudo igualar el «aspecto Sony» de las HDC-4300s con relativa facilidad, y las prefirió para esta aplicación.

“Para grandes producciones como el Super Bowl, no tienes tiempo para una meticulosa combinación de colores [con] diferentes marcas [de] cámaras que no operan orgánicamente en el mismo espacio de color. Además, los Alpha tienen el mejor sistema de enfoque automático disponible, que es fundamental en deportes de acción como el fútbol. Los deportes más lentos, como el golf, tienen menos necesidad de depender del enfoque automático cuando se trata de empujar. El golf es muy predecible: los jugadores suelen caminar a un ritmo mesurado y en líneas más o menos rectas. Eso simplifica el enfoque manual con o sin CA».

Los camiones de transmisión están respondiendo a la demanda de cámaras estilo cine por parte de los presentadores deportivos. Comunicaciones CP, con sede en Nueva York y Florida, colaboró con Ligrani en el Megalodon a partir de 2018. «Nuestro objetivo es proporcionar a nuestros clientes el último equipo que puede desear», explica el director ejecutivo Kurt Heitmann. “Si no lo tenemos, lo compramos o lo construimos. Creamos varios paquetes de cámaras Megalodon para Fox Sports, según sus especificaciones. Intercambiamos cámaras o sistemas de soporte de manera rutinaria a medida que cambian las necesidades de los clientes para eventos particulares. Todavía es temprano para las cámaras de estilo cinematográfico en los deportes, pero nuestro trabajo es mantenernos a la vanguardia de la demanda con amplias opciones».

Los expertos de CP Communications se preparan para una transmisión.

Progreso hacia adelante

Según Heitmann, mientras que la resolución y la capacidad de la cámara están evolucionando rápidamente, el ancho de banda es actualmente una limitación tecnológica. “Muchas de nuestras cámaras de transmisión tienen una clasificación de 8K, 6K y 4K, pero nuestra canalización actual [4K] nos restringe una salida [dual] 1080p 60, lo que nos permite transmitir HDR a 1080p”, dice. “Pero 5G está a la vuelta de la esquina y nos permitirá trabajar en 4K. Nuestro desafío es prepararnos para 5G, mientras satisfacemos las demandas que evolucionan rápidamente en la actualidad».

Dejando a un lado los problemas de ancho de banda, ¿las cámaras cinematográficas captarán una porción cada vez mayor de la cobertura general de cámaras de las principales transmisiones deportivas en los próximos años? Quizás en los márgenes, pero es poco probable que cambien el equilibrio de poder en el corto plazo en el mundo de las transmisiones de deportes de grandes ligas. «De hecho, hemos tenido discusiones sobre hacer un juego completo principalmente con cámaras de estilo cinematográfico, solo para ver cómo se vería un juego», dice Davies. “Pero hay compensaciones.

Aunque tenemos cierto control de la salida de las cámaras de cine, no es tan fácil ni tan fácil como lo es con nuestras cámaras de retransmisión de Sony y Grass Valley, y los superteleobjetivos que necesitamos para cubrir todos los campos de fútbol y béisbol. desde una posición fija. Son nuestra carne y patatas. Las cámaras de cine están al margen, pero nos ayudan a expandir la historia al capturar más drama y espíritu en todos estos juegos con imágenes que te emocionan y que, con suerte, recordarás mucho después de que termine el juego».