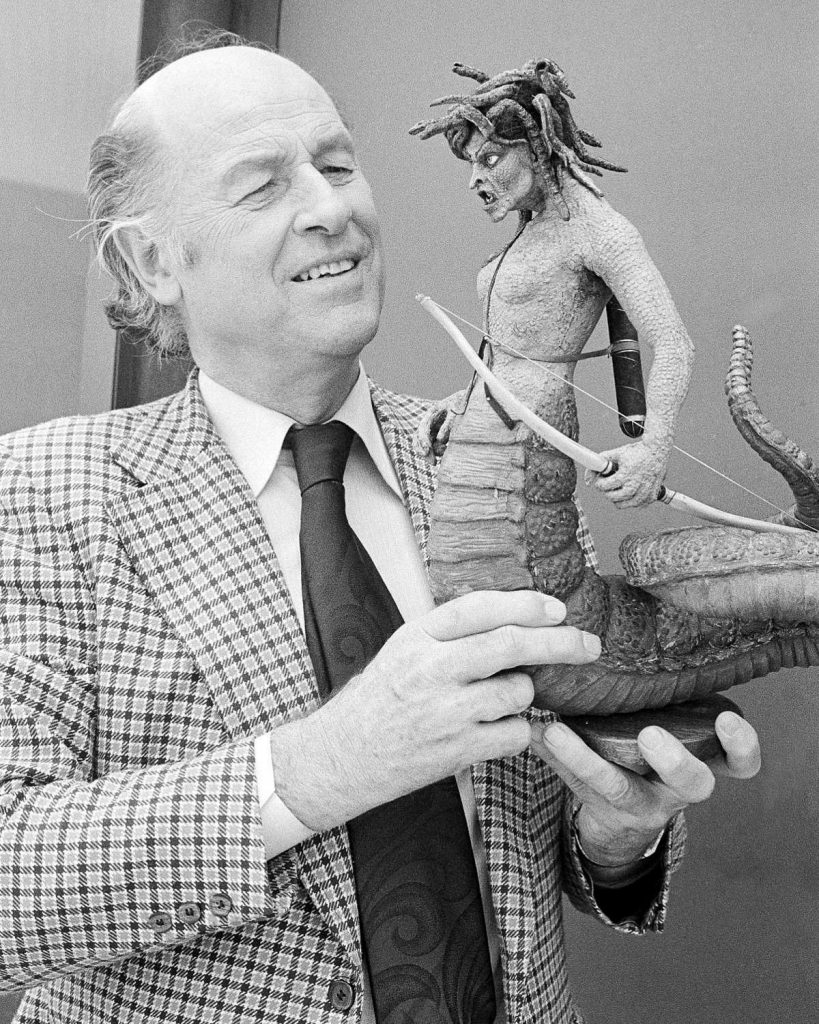

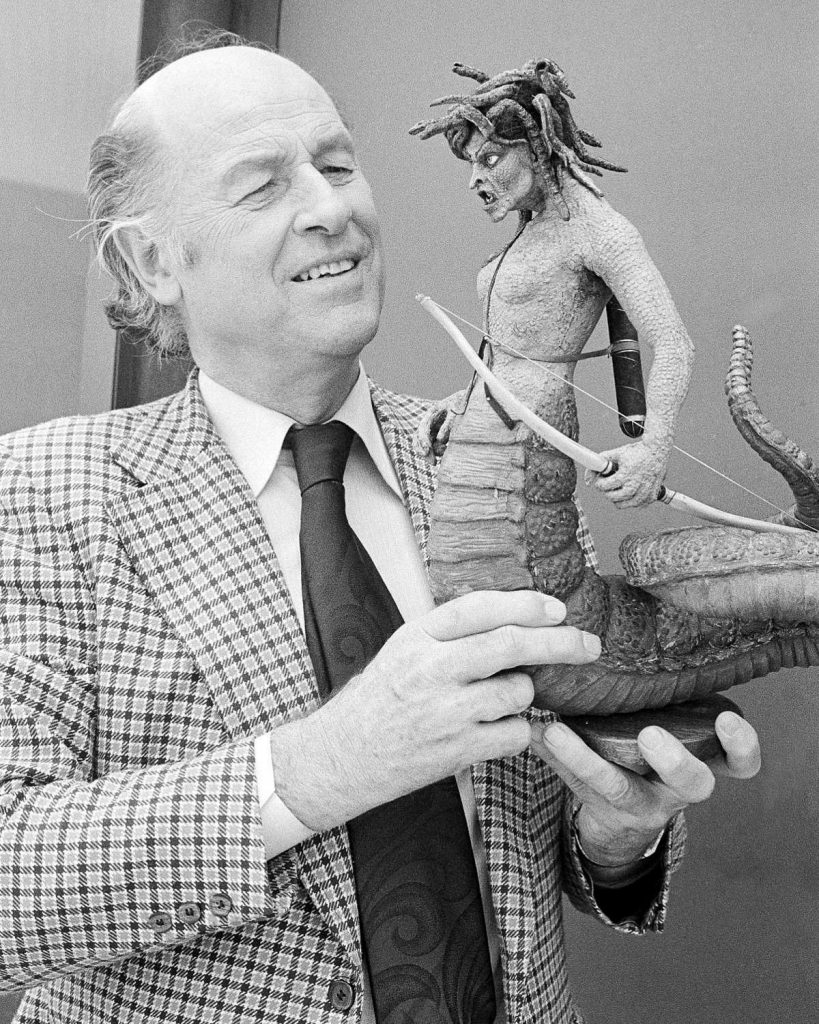

Harryhausen y una de sus mejores criaturas, Medusa, la Gorgona, de Furia de titanes (1981).

Harryhausen y una de sus mejores criaturas, Medusa, la Gorgona, de Furia de titanes (1981).

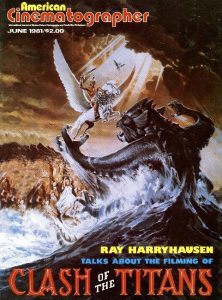

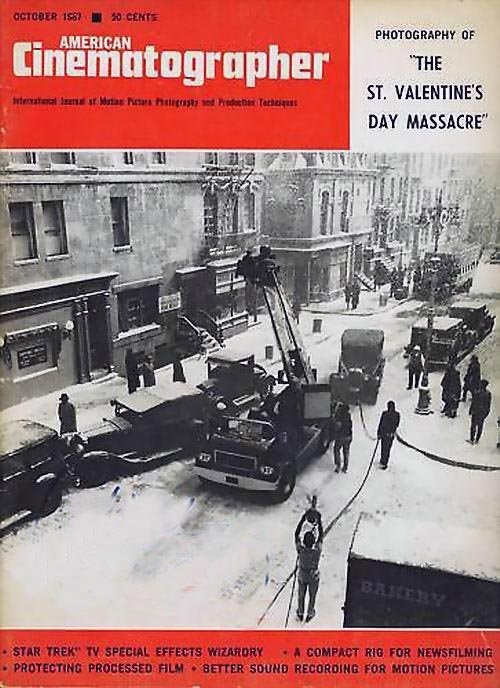

AMERICAN CINEMATOGRAPHER

23 de febrero del 2022 Personal del CSA

por Ann Tasker

Después de más de 40 años, el mago de la cinematografía stop-motion finalmente comparte algunos de los secretos técnicos de su arte único.

Nota del editor: Esta discusión fue parte de la cobertura de AC sobre Choque de titanes, con una descripción general de la producción de la película que se encuentra aqui..

El gran mago de los efectos visuales especiales, Ray Harryhausen, acaba de completar su película número 16 en una carrera que abarca 41 años. Choque de titanes es el duodécimo en el que trabaja con su viejo amigo y productor Charles H. Schneer, el octavo que se filma en Dynamation, un término acuñado por Schneer para describir la técnica de unir la acción en vivo y la animación stop-motion que Harryhausen ha sido pionera en el arte elevado.

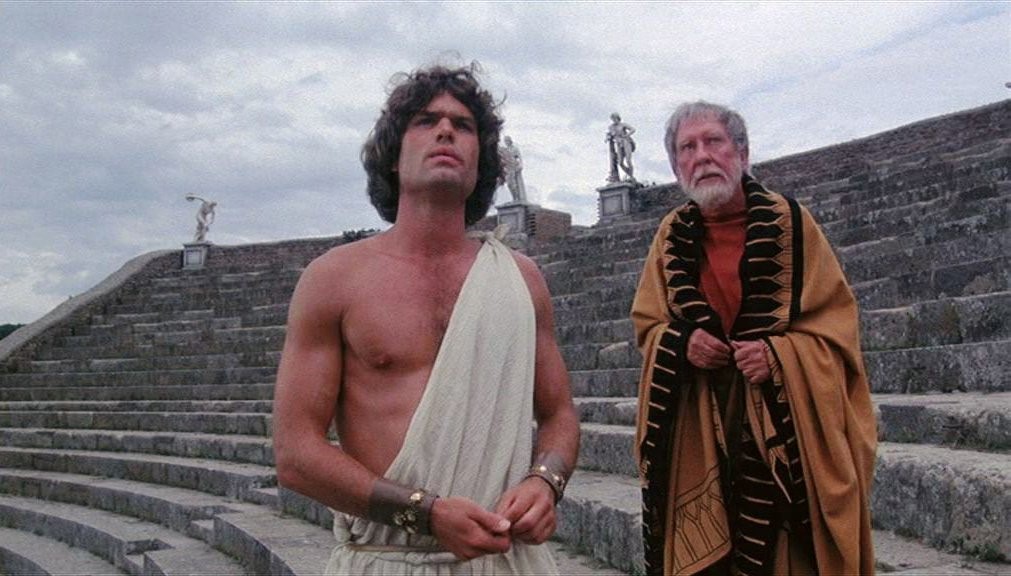

Furia de titanes representa el proyecto más ambicioso de MGM en más de 10 años y es una aventura de fantasía con raíces en la mitología. Desmond Davis es el director y «más estrellas de las que hay en el cielo» incluyen a Harry Hamlin, Judi Bowker, Burgess Meredith, Maggie Smith, Ursula Andress, Claire Bloom, Sian Phillips, Flora Robson y Laurence Olivier como Zeus, padre de los dioses.

Esta entrevista se realizó para el número de junio de 1981 de AC.

Para conocer las técnicas de filmación de esta epopeya, American Cinematographer viajó a Inglaterra, donde Harryhausen, nacido en Los Ángeles, vive y trabaja desde hace 21 años.

Se ingresa al maravilloso mundo de Ray Harryhausen a través de una puerta con cicatrices de pintura que se abre con un chirrido en uno de los rincones más remotos de Pinewood Studios, a 15 millas de Londres. Durante los últimos dos años y medio, el viejo estudio de cine ha sido su casa de trabajo y, francamente, el lugar es un desastre. La técnica de Harryhausen siempre ha parecido ser una parte de tecnología y dos de improvisación escolar, imaginación sin límites y una capacidad infinita para esforzarse. Todo se refleja aquí.

Las criaturas, siempre «criatura», nunca «monstruo», como Harryhausen aborrece la palabra, yacían destripadas en el suelo, sus esqueletos esféricos fueron removidos para hacer modelos más nuevos y mejores. Una lechuza operada electrónicamente con un mecanismo lo suficientemente sofisticado como para guiar un misil se apoya en una botella de Fairy Washing Up Liquid, «mejor que la glicerina para resaltar las características de las criaturas cuando haces un primer plano», afirma Harryhausen.

Un par de ojos de porcelana que esperan el pincel cuelgan de un trípode hecho con pinzas para la ropa y agujas de tejer. Pronto entrarán en la cabeza de goma espuma de una Gorgona cuyo cabello ha sido reemplazado por 12 serpientes, cada una con 25 articulaciones. Recortes de cómics y volúmenes de arte encuadernados en cuero, ruedas de juegos de construcción y sus propias hermosas esculturas, todo ensucia la superficie de lo que Harryhausen llama con optimismo su mesa de trabajo.

Ray Harryhausen mira el modelo de Kraken a través de la cámara. No usa animación por computadora, sintiendo que se necesita el toque personal de la animación manual.

Aunque podría escribir el libro sobre los aspectos técnicos de su oficio y, de hecho, ha contribuido a todos los tratados definitivos sobre el tema, la preocupación de Harryhausen sigue siendo la historia que está ayudando a contar; un hombre más interesado en la música hermosa que en el equipo de alta fidelidad que la reproduce.

Presionado con fuerza, revelará con cautela algunos de los secretos de Dynamation, pero su verdadera pasión está reservada para las aventuras no contadas que le gustaría filmar, las nuevas criaturas que le gustaría crear, si solo le quedara suficiente tiempo y dinero en el mundo.

Un nombre se repite a lo largo de su conversación, el nombre que comenzó todo para él: King Kong. Harryhausen tenía 13 años cuando vio la película de 1933 en el Teatro Chino de Grauman y se convirtió instantáneamente en discípulo del creador de Kong, Willis O’Brien. “Estaba intrigado por la película porque no sabía cómo estaba hecha”, recuerda. “Sabía que no era un hombre con traje. La película jugó en mi imaginación. Había estado haciendo dioramas como pasatiempo con arcilla, los pozos de alquitrán de La Brea y varios otros temas prehistóricos, y vi en King Kong una forma de hacer que estas cosas se movieran.

“Empecé a hacer mis propias películas en el jardín trasero. No teníamos luces, pero un amigo había comprado una vieja cámara Victor de 16 mm y se ofreció a filmar. Hicimos un oso con el abrigo de piel de mi madre y empezamos a animar temprano en la mañana. Terminamos a última hora de la tarde, momento en el que el sol se había desplazado de modo que, cuando el oso salió de la cueva, las sombras se movían por la pantalla. Quería hacerlo mucho mejor, así que me involucré con la fotografía y la iluminación.

King Kong (1933, imágenes de radio RKO).

“Tenía entonces unos 15 o 16 años y me propuse tratar de averiguar cómo se hizo King Kong. Ocasionalmente, había algo en las revistas que describía las articulaciones esféricas, etc. Reuní toda la información que pude sobre la animación stop-motion y todo se desarrolló a partir de ahí”.

Mientras aún estaba en la escuela, Harryhausen estudió dirección de arte y fotografía en un curso nocturno a cargo de la Universidad del Sur de California bajo la guía de varios miembros de la industria cinematográfica: editores, directores de arte y directores de fotografía como Lewis Physloc, ASC. Después de un breve coqueteo con la actuación y una temporada en el departamento de teatro de Los Ángeles City College, Harryhausen volvió a esculpir, dibujar y planificar películas de fantasía.

A principios de la década de 1940, Harryhausen se unió a George Pal y luego produjo una serie de películas animadas llamadas Puppetoons. Los títeres de Pal eran figuras muy estilizadas torneadas en un torno y cortadas en madera contrachapada. Para cada movimiento, había una figura separada y un paso podía involucrar 24 figuras. Aunque Harryhausen aprendió mucho sobre fotografía y adquirió experiencia práctica, el tipo de animación de Pal le resultó limitante.

Pasó la Segunda Guerra Mundial haciendo películas instructivas y de orientación para los servicios y sin querer volver a la animación de títeres limitada. A su regreso a la vida civil, Harryhausen se embarcó en su propia serie de cuentos de hadas animados. Conocidas como las “Historias de la Madre Oca”, las películas aún se exhiben en las escuelas. El “estudio” de Harryhausen estaba detrás del garaje de su padre y la producción era un asunto familiar. Su madre hizo el vestuario y Harryhausen Sr, un maquinista, hizo las uniones y armaduras. Harryhausen fue el «animador jefe» del corto de Puppetoon «Tulips Shall Grow» en 1942.

Antes de que Harryhausen ingresara al ejército, concibió y comenzó a trabajar en una película llamada Evolution. Fue un proyecto ambicioso que rastreaba el surgimiento del mundo desde un gas arremolinado en el espacio hasta la era de los mamíferos. Le había mostrado su metraje a Willis O’Brien y en 1946, cuando O’Brien estaba preparando Mighty Joe Young, Harryhausen fue contratado para trabajar en la película.

Animando a Mighty Joe Young (1949).

Trabajó con O’Brien y el productor Merian Cooper durante unos tres años. El primer año lo pasó cortando marcos para dibujos, mecanografiando, cualquier cosa para adquirir experiencia, y luego comenzó a ayudar con la animación de Mighty Joe. Varios proyectos previstos por O’Brien y Cooper, como Food of the Gods , Valley of the Mist y Mighty Joe Young Meets Tarzan no lograron despegar, y un amigo le presentó a Harryhausen a Jack Dietz. El productor tenía un esquema llamado Monster From Beneath the Sea, que se convirtió en The Beast from 20,000 Fathoms y el primer largometraje en solitario de Harryhausen.

La bestia de 20.000 brazas (1953, Warner Bros.)

La película se convirtió en una de las «durmientes» del año, pero entre el final de la producción y el estreno, Harryhausen volvió a sus cuentos de hadas. Cinemascope y los artilugios de pantalla ancha estaban entonces de moda y Warner Bros, los distribuidores, temían que, como La Bestia no estaba en color, no consiguiera reservas para los cines. Resolvieron esto tiñendo la película de marrón y lanzándola con la etiqueta promocional “Glorious Sepiatone”.

Los amigos han jugado un papel importante en el destino de Harryhausen y fue otro amigo quien le presentó a un joven productor llamado Charles H. Schneer. Quería hacer una película protagonizada por un pulpo gigante que derriba el puente Golden Gate. Se juntaron e hicieron It Came From Beneath The Sea.

Vino de debajo del mar (1955, Columbia Pictures)

Fue el comienzo de una asociación y una amistad que perdura desde hace más de 30 años. En 1959, la pareja se mudó a Inglaterra. Le preguntamos a Harryhausen por qué.

Ray Harryhausen: Habíamos hecho tres o cuatro películas en Hollywood y luego alguien vino a nosotros con un guión llamado Gulliver. Queríamos hacer la imagen y la mejor manera de hacerlo fue a través de travelling mate. Hollywood no contaba con amplias instalaciones en ese momento para hacer viajes correctamente, y habíamos oído hablar de la Proceso de vapor de sodio, donde se tiene un mate instantáneo, lo que simplificó el trabajo. Teníamos tantos mates de viaje en la imagen que decidimos investigar el proceso que había desarrollado Rank. Vinimos a Inglaterra e hicimos dos cuadros usando el respaldo de sodio. La Isla Misteriosa y Los Tres Mundos de Gulliver.

American Cinematographer: ¿Por qué este proceso solo estuvo disponible en el estudio de Rank, Pinewood, Londres? Hollywood en este punto seguramente estaba adelantado con la técnica.

RH: Creo que Hollywood había invertido demasiado en la retroproyección y sintieron que con los proyectores de tres cabezas y todo lo que podían lograr era lo que se necesitaba. Ocasionalmente veías un mate móvil en una película de Hollywood, pero se convirtió en un arte olvidado, aunque Hollywood tenía un mate móvil cuando hicieron películas como El Arca de Noé utilizando el antiguo proceso Dunning y el proceso Williams en blanco y negro.

AC: Cuando se trataba de color, nunca parecían desarrollar el arte en gran medida porque la mayoría de los estudios tenían grandes departamentos de retroproyección con enormes cantidades de dinero invertidas. Probablemente no querían cambiar.

RH: Muchas imágenes no requerían mate de viaje, pero cuando se trata de personas grandes y pequeñas, debe recurrir a su uso. El Laboratorio Rank TM, a cargo de Vic Margutti, tenía el sistema [de vapor de sodio] que era capaz de producir instantáneamente un mate en movimiento por bi-pack. Sentimos que sería un gran activo para Gulliver. Disney tenía una franquicia en el sistema en Estados Unidos.Hicimos las dos películas y nos gustó tanto Inglaterra que nos quedamos. También estábamos justo en el centro de Europa y podíamos llegar a cualquier lugar exótico en cuatro o cinco horas. Sentimos que Malibú, el Gran Cañón y todo el paisaje alrededor de Hollywood se estaba agotando rápidamente por la televisión. Un fondo demasiado familiar no podría usarse en una película de fantasía. Cuando hicimos El séptimo viaje de Sinbad, por ejemplo, queríamos algunos edificios árabes auténticos. El Medio Oriente estaba en crisis, así que nos instalamos en España y usamos la Alhambra, con su maravillosa arquitectura morisca.

AC: ¿Algunos de sus equipos son, creo, bastante viejos…?

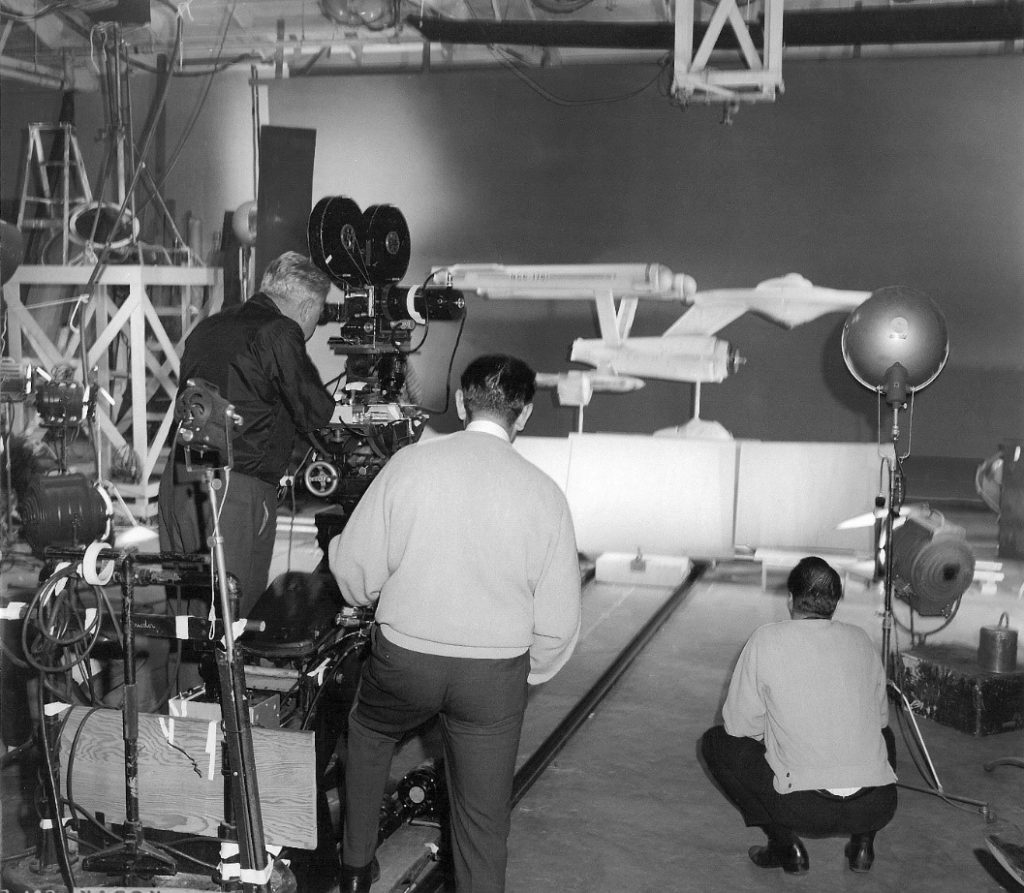

RH: Sí, tenemos una Mitchell NC, creo que fue la 15º Mitchell que se fabricó y todavía la usamos. Soportaría cualquier cámara moderna. Estaban tan bien hechas que si les das algún tipo de cuidado durarán para siempre. En Titans tuvimos que usar cámaras adicionales. Teníamos tres equipadas con motores stop-motion y dos proyectores. De hecho, tuvimos tres para mantener un flujo de imágenes que salieran para tratar de cumplir con el cronograma.

AC: ¿En qué se diferencia una cámara de stop-motion de una cámara normal?

RH: Principalmente en lo que se refiere al motor. Una cámara de stop-motion tiene un motor que hará una exposición de un cuadro muy precisa y es muy importante que este motor sea confiable. Está produciendo una exposición de un solo cuadro y si la exposición varía de alguna manera, obtiene un parpadeo y otros problemas. Usamos algunos de los motores stop-motion que se usaron en el primer King Kong en 1933, pero recientemente hemos comprado otros nuevos.

AC: ¿Han cambiado mucho las cámaras a lo largo de los años?

RH: El principio básico no ha cambiado, aunque ahora puede obtener cámaras compactas mucho más pequeñas y motores mucho más confiables que funcionan con un principio electrónico más simple. Todavía me gusta volver al tipo de motor de 1933, a pesar de algunas de sus deficiencias. Los encuentros muy confiables. La acción de la película se filma en el lugar o en el estudio con una determinada exposición de iluminación determinada por el director de fotografía.

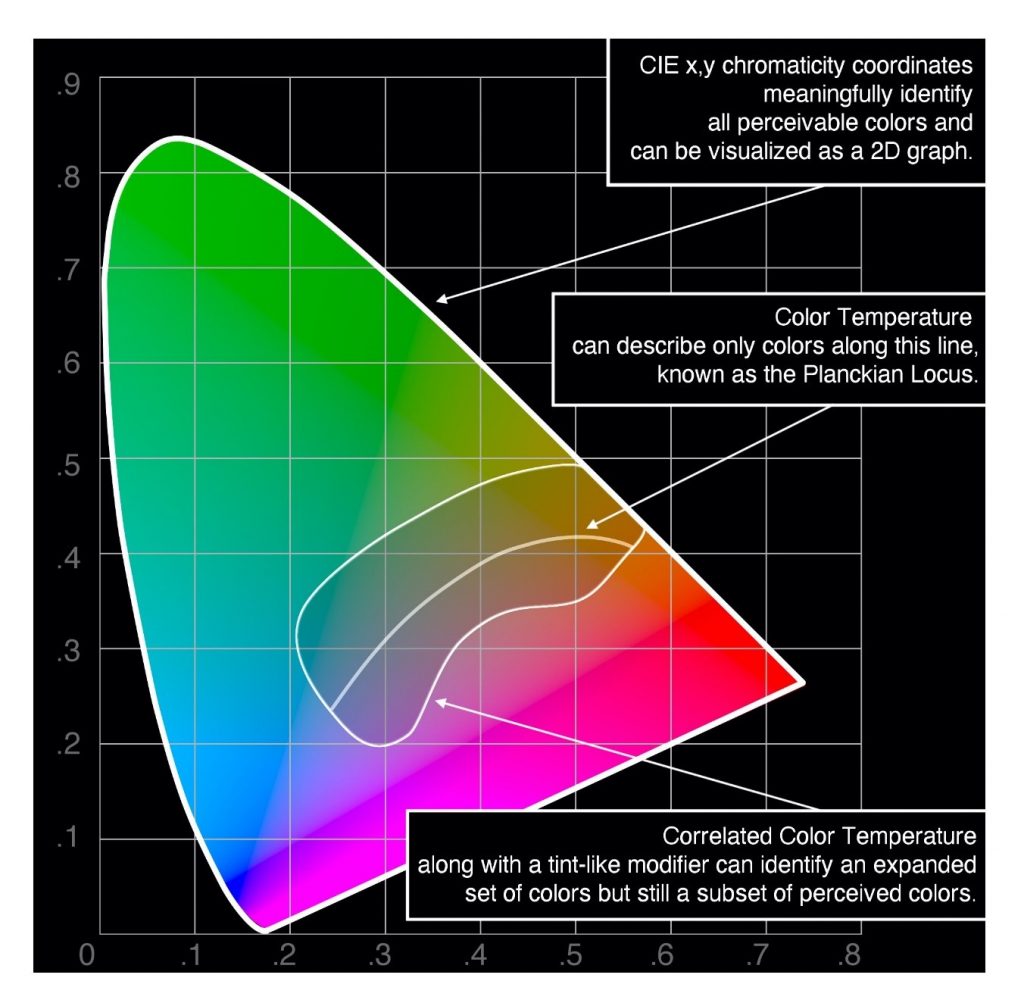

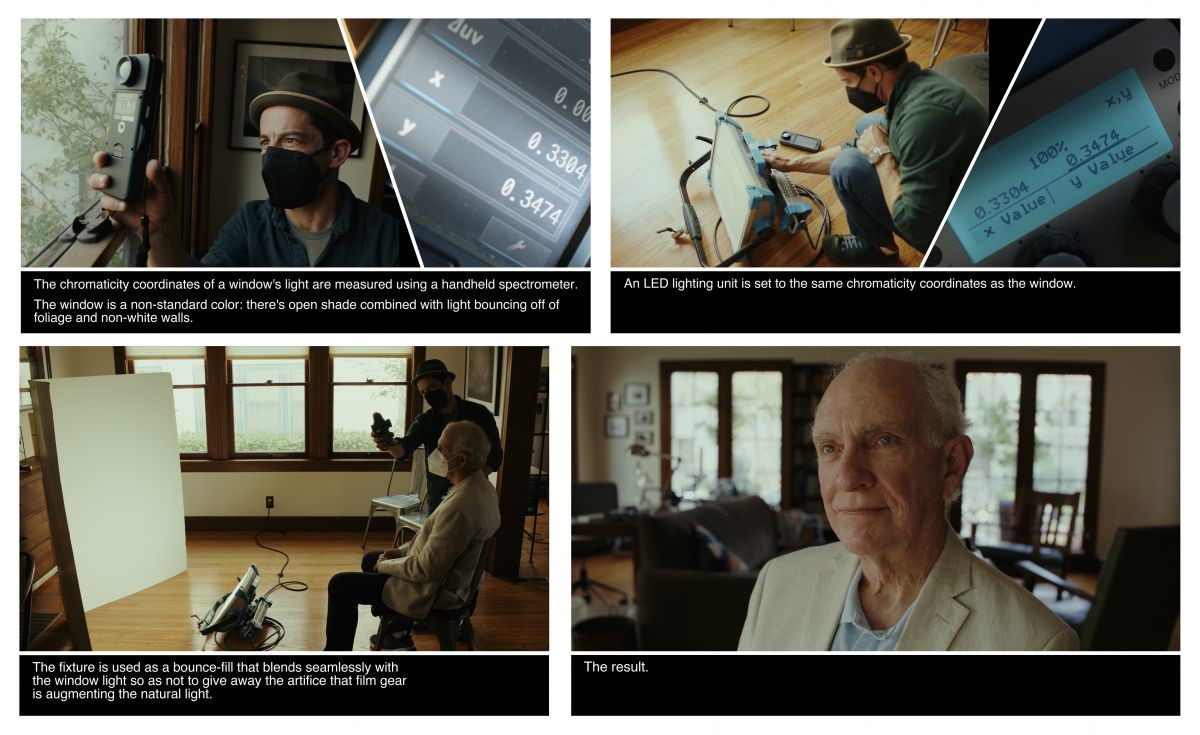

AC: ¿Qué problemas tienes para hacer coincidir la iluminación cuando colocas a tus criaturas en la película? ¿Hacéis una serie de gráficos relativos a los números de pizarra, por ejemplo?

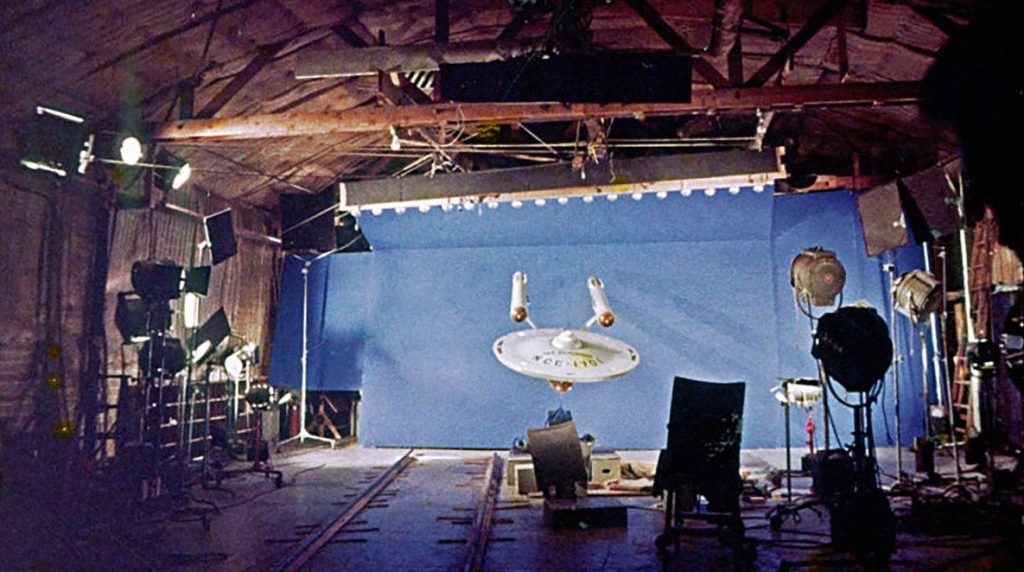

RH: Intento hacer coincidir la iluminación que hay en la placa de fondo. Es muy fácil ver de dónde viene la luz clave y durante la producción hacemos diagramas muy cuidados. Por supuesto, hay un gran problema con el balance de color cuando intentas reproducir una película. Si no se ajusta con cuidado, la fuente de luz de proyección a veces cambia todo el tono de los colores. Para intercalar con el metraje de producción, debe tener mucho cuidado para intentar obtener una reproducción del color lo más precisa posible. Esto se logra mediante filtros y otras técnicas para alinear la fuente de luz. Hacemos que el camarógrafo asistente tome medidas precisas sobre qué tan lejos se supone que la criatura está de la cámara en relación con las personas. También tenemos recortes de cartón para representar a la criatura. Si el monstruo es muy grande, hacemos que alguien sostenga un palo largo para dar un punto de enfoque a los actores y extras. Hemos tenido una maravillosa serie de camarógrafos en nuestras películas. En nuestros primeros días en Inglaterra, teníamos a Wilkie Cooper [BSC]. En Clash y nuestras dos últimas películas, hemos tenido a Ted Moore [BSC].

AC: ¿Qué material de película usas?

RH: Básicamente, 5247 [de Kodak]. El material de película actual es mucho más sensible a la reproducción de una imagen y las nuevas lentes crean un fondo mucho más nítido. Tuvimos problemas con nuestra primera imagen en color, El séptimo viaje de Simbad. Fue necesario utilizar material de impresión normal para nuestras placas de fondo. Pasamos meses de agonía probando varias representaciones de color. No había ninguna otra acción en ese momento, pero en los últimos años ha habido nuevos desarrollos. Ahora usamos un stock positivo del que hacen impresiones especiales de bajo contraste para televisión. Tiene una relación de contraste más baja y ha hecho que la reproducción del color sea mucho más fácil y mucho más precisa. Cuando hicimos Los tres mundos de Gulliver y El séptimo viaje de Simbad, tuvimos que usar flash en muchas de nuestras placas de fondo para que los negros no se volvieran demasiado negros cuando se volvieran a fotografiar.

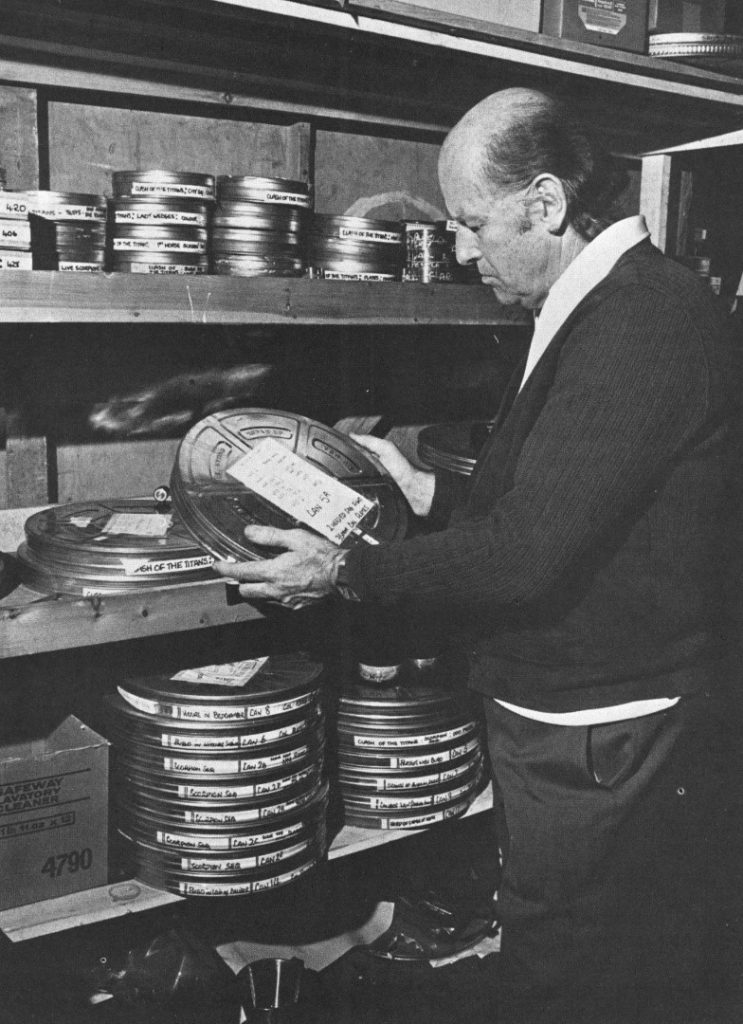

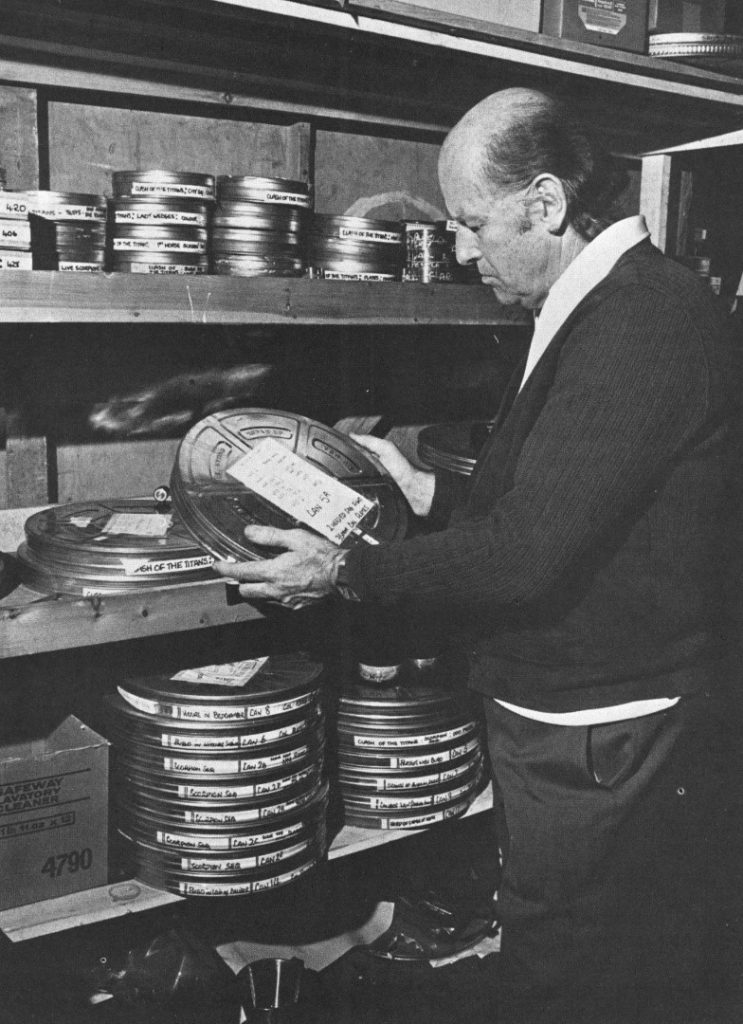

Harryhausen selecciona fragmentos de películas para Choque de titanes.

AC: ¿Qué quieres decir con «flash»?

RH: Flash significa que debe exponer la película antes de imprimirla y empañarla ligeramente, lo que hace que los negros se vuelvan ligeramente grises. Hay que controlarlo con mucho cuidado. La película tiende a captar contraste en la reproducción. Ahora tiene 5247 y si la placa se dispara correctamente, tiene una calidad de reproducción mucho mejor.

AC: ¿Tratas de usar el mismo lote de película cuando filmas a tus criaturas que el que usas para las placas?

RH: Tenemos que tener stock especialmente perforado. Hoy en día, debido a las leyes de la economía, el material se produce a tal velocidad que a veces los orificios de las ruedas dentadas presentan imprecisiones con respecto a las perforaciones de las películas. Es asombroso a lo largo de los años cómo este tipo de problema ha aumentado en lugar de disminuir. Se debe a una serie de razones diferentes. Tratamos de bajar los primeros 20 000 o 30 000 pies antes de que el punzón comience a producir orificios de rueda dentada demasiado grandes.

AC: ¿Qué otros problemas hay para ti que difieren de la realización de películas regulares?

RH: Tenemos que ser muy cuidadosos con la perspectiva porque si estás usando una proyección en miniatura, es muy difícil hacer que la inserción de la figura animada se mueva hacia y desde la cámara. Muchas veces no usarás los mismos lentes que usaste en la fotografía original. Si un actor comienza en el fondo y avanza, aumenta de tamaño muy rápidamente si se usa una lente gran angular. Cuando llegas a insertar la criatura animada moviéndose en la misma dirección, el hecho de que hayas utilizado una lente de ángulo diferente necesaria para reproducir la placa de fondo provoca cambios en todo el concepto de la perspectiva de la toma. Tiene que ser cuidadosamente controlado y diseñado en la forma en que se escenifica la acción. Es necesario hacer frente a este problema durante la producción y no después.

AC: ¿Qué es un “punto caliente”?

RH: Un ‘punto caliente’ significa que ve la fuente de luz de su proyector a través de la imagen proyectada en la pantalla.

AC: ¿Los actores tienen problemas para reaccionar a los recortes de cartón?

RH: Algunas veces. Por eso realizo una serie de dibujos de los puntos destacados del cuadro, así como bocetos de continuidad. Le muestran al actor exactamente lo que se supone que debe mirar en la escena final. Para el actor, es una forma de boxeo de sombras. Están mirando y reaccionando a algo que no está ahí. Muchas veces podemos montar la escena con dobles o dobles que tomarán el lugar de la criatura. Fotografiamos a los dobles solo como guía para analizar su acción. Al mismo tiempo, hacemos otra placa de fondo sin los especialistas, solo grabando al actor «boxeando en la sombra», por así decirlo. Esta es la pieza real de la película que luego usamos para combinar el modelo animado.

AC: ¿Qué es exactamente un “plato”?

RH: No sé cómo surgió el término, pero siempre hemos llamado a la pieza de película positiva utilizada para la reproducción, una «placa» de fondo. Consiste en una tira de película positiva impresa especialmente a partir de la fotografía original. Se coloca en un retroproyector en miniatura y se reproduce con otra cámara. Lo más importante es que tenga orificios de rueda dentada negativos, Bell & Howell, para mayor precisión y registro.

AC: La película pasa por la cámara a cierta velocidad. ¿En tu trabajo tienes problemas para adaptarte a esta velocidad?

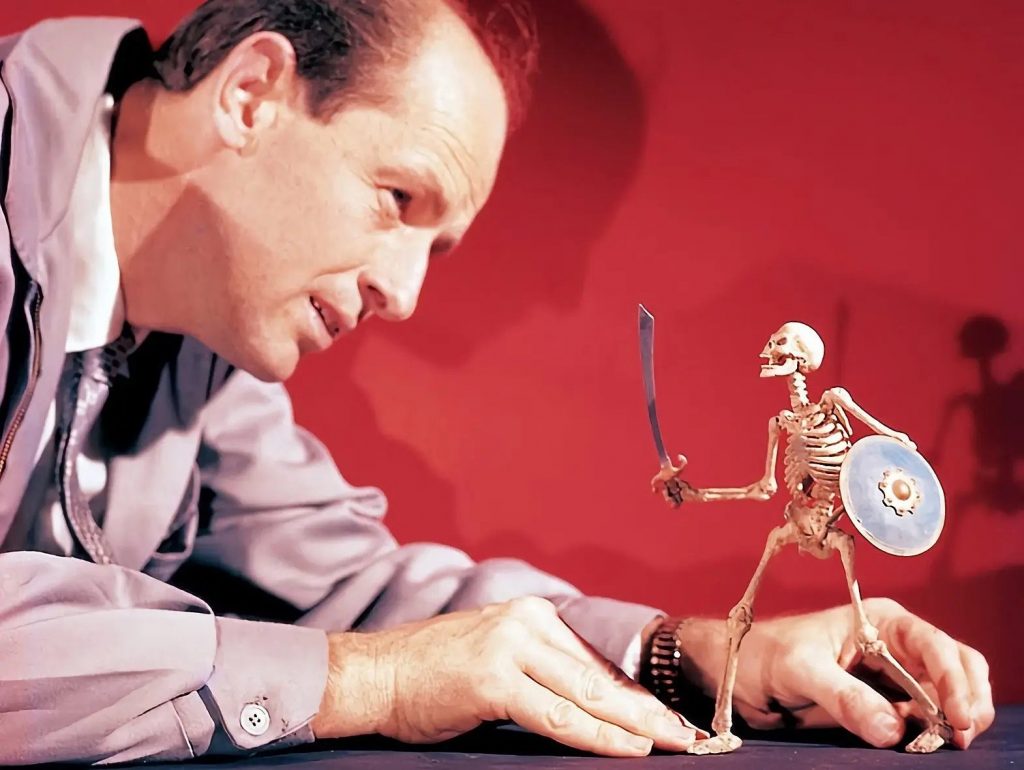

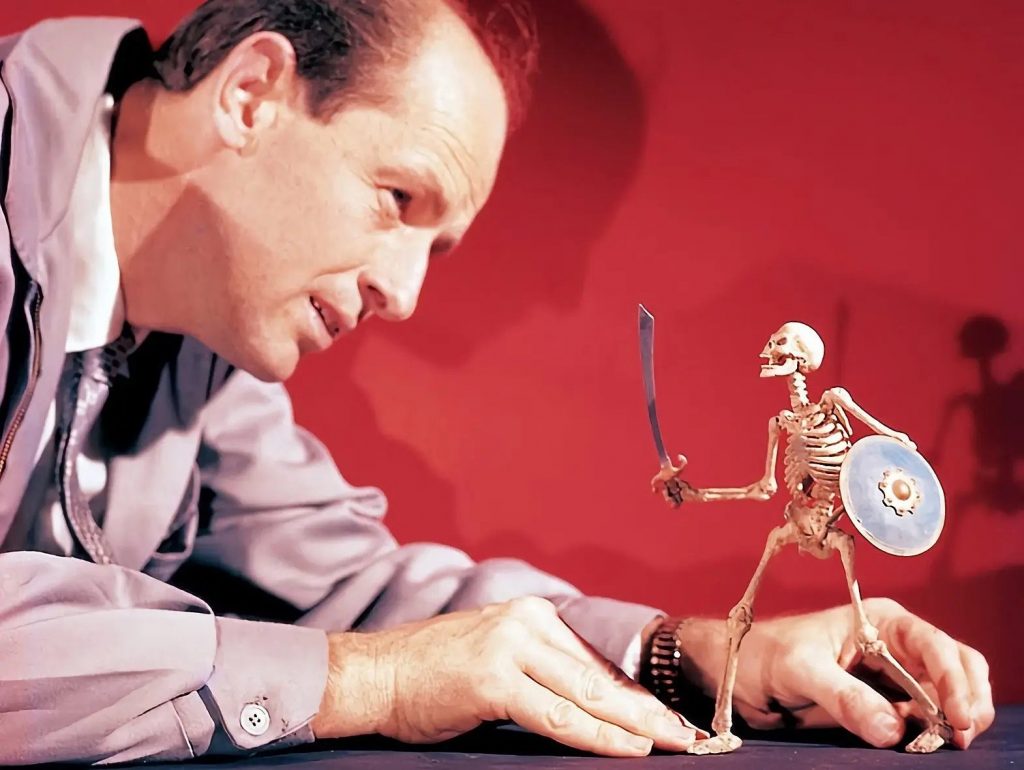

RH: La velocidad de la fotografía de acción en vivo es siempre de 24 cuadros por segundo y debe juzgar la velocidad del movimiento de su animación en consecuencia. Cuanto más amplio sea el movimiento, más rápido parecerá moverse el modelo. Presenta un problema de sincronización porque las criaturas y los actores deben aparecer para ser fotografiados al mismo tiempo. Esto hace que a veces sea necesario mover la figura alrededor de medio milímetro por cuadro para mantener la sincronización con los actores en vivo. Con velocidades de movimiento más lentas y muchos modelos, a veces solo puedo producir 13 fotogramas por día laboral. Cuando estaba haciendo la pelea de esqueletos en Jason and the Argonauts, tenía siete esqueletos peleando contra tres hombres que eran actores en vivo. Mover siete esqueletos, cada uno con cinco apéndices moviéndose a diferentes velocidades, significaba que trabajaba muy lentamente. Por supuesto, hay otros días en los que puedo promediar 25 pies de animación.

AC: ¿Tuviste resistencia a usar color?

RH: Bueno, sí. En los primeros días, cuando Charles y yo hicimos 20 Million Miles to Earth, acababan de sacar un nuevo material en blanco y negro que era maravilloso para la reproducción. Podría reproducir una placa de fondo e intercalarla con el negativo original y apenas detectar la diferencia. Acabábamos de dominar el problema inherente al blanco y negro cuando Charles quiso hacer El séptimo viaje de Simbad en color. «Simplemente no podemos hacer una película de Las mil y una noches en blanco y negro», dijo. Siguió animándome a experimentar con el color a pesar de sus muchos problemas obvios. Los primeros resultados no fueron de la calidad que esperábamos, pero fue el paso correcto en un campo relativamente nuevo.

AC: ¿El color obviamente presenta más problemas?

RH: El color presenta muchos más problemas en la reproducción porque los diversos colores cambian cuando se vuelve a fotografiar la placa. En aquella época, los verdes por ejemplo, salvo que tuvieran una intensidad particular, tendían a volverse muy grises. Tuvimos el mismo problema con otros colores. Cuando intercalas un fondo refotografiado con el material de producción original, una chaqueta o un turbante adquieren un tono completamente diferente.

AC: Con el color, ¿sus modelos tienen que construirse mucho mejor?

RH: Sí, de hecho. Esto es particularmente cierto en la fotografía de primeros planos de un modelo relativamente pequeño. El detalle es lo más importante, particularmente en la textura de la piel. El uso de lentes excesivamente nítidos para sacar lo mejor del fondo a veces hace que el modelo sea demasiado nítido en relación con el fondo. Entonces hace necesario difundir una parte de la imagen para el efecto final.

Harry y su impresionante modelo de Medusa.

AC: ¿Siempre grabas en película de 35 mm?

RH: Sí. Filmamos con la apertura completa, desde el orificio de la rueda dentada hasta el orificio de la rueda dentada, para las placas de fondo. Esto se reduce a la Academia normal o a la relación de aspecto de 1:1,85, según sea el caso. Cuanto más grande sea su negativo, más nítida será la imagen que obtendrá en el fondo. Muchas veces hemos querido experimentar con las placas de fondo de VistaVision. El negativo más grande reducido a 35 mm daría una imagen más nítida y una mejor reproducción. Pero con la gran cantidad de placas de fondo que solemos tener en nuestras imágenes, es cuestionable si los resultados finales justificarían los costos adicionales.

AC: Volviendo al color, ¿comparte la preocupación de Martin Scorcese sobre el rápido desvanecimiento de la película en color?

RH: Sí. Hicimos una película llamada Los primeros hombres en la luna y tenía algunos recortes de la versión de 70 mm. Los saqué de mi archivo hace un par de meses y estaban todos descoloridos. Habían estado a oscuras y no estaban almacenados en malas condiciones. Me sorprendió que los colores se hubieran desvanecido después de menos de 12 o 15 años. Se están haciendo muchas fotografías en blanco y negro nuevamente y, por supuesto, el proceso Technicolor de tres tiras en el que realmente graba o transfiere su imagen a blanco y negro es casi la única salvación. Tienes que ir a China ahora para hacer eso. Entiendo que Technicolor vendió la mayor parte de su equipo a China y son las únicas personas que usan impresiones de liberación de tres tiras. Recuerdo que, cuando trabajábamos con las marionetas de George Pal, usábamos película en blanco y negro con un círculo cromático. Cada fotograma sucesivo era de un color diferente: rojo, verde y azul. Cada tercer cuadro se imprimió uno sobre el otro y obtuviste el color más hermoso. Por supuesto, la película en blanco y negro no se desvanece porque tiene contenido plateado. La respuesta a la preservación de la película parece ser volver al proceso Technicolor de tres tiras. Ahora dicen que la plata es tan costosa que perderá su precio.

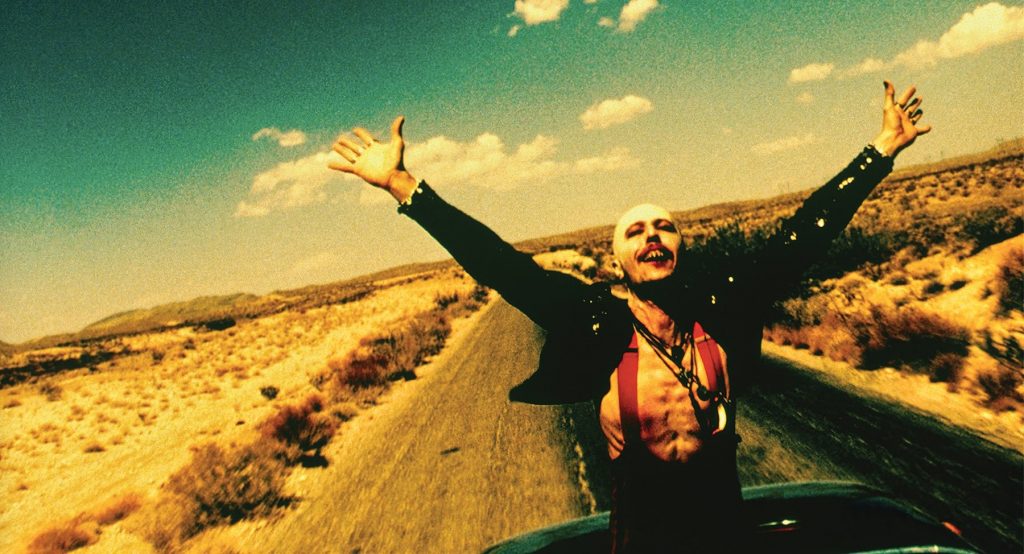

Medusa de Choque de titanes.

AC: ¿Cuál de todas las criaturas que has creado fue la más complicada o difícil? Los esqueletos de Jason deben haber presentado problemas.

RH: Sí. Son los más cercanos al ser humano y por lo tanto probablemente los más criticables en movimiento. Los dinosaurios, por ejemplo, nadie sabe realmente cómo se mueve un dinosaurio, por lo que puedes tomarte grandes libertades, pero un esqueleto tiene que moverse de la manera que esperas que se mueva un ser humano. Tienes que ocultar todas las articulaciones para que parezca que solo hay hueso. En Choque de titanes, creo que Medusa presentó el mayor problema porque tenía 12 serpientes en el cabello, y cada serpiente tenía que estar articulada para mantener su propia posición. No podíamos simplemente clavar cables en la serpiente y esperar obtener algún tipo de movimiento exitoso. También tenía que tener una escala lo suficientemente grande como para permitir un marco articulado en cada serpiente. Por cada fotograma de la película, tenía que mover una serpiente a una posición diferente. Tenía 12 serpientes en el pelo, más las colas, más el movimiento de la boca, se movían los ojos, se movían los dedos, disparó una flecha y la cola se sacudió. Probablemente tenía más de 100 articulaciones en su cuerpo, 150, quizás, incluidas las serpientes.

Sosteniendo una cabeza de Medusa de utilería a gran escala utilizada durante la filmación de acción en vivo.

AC: ¿Cómo se hacían los movimientos?

RH: Completamente a mano. No creo que se haya ideado una computadora que pudiera crear los complicados movimientos necesarios para que nuestras criaturas animadas se realicen. Los esqueletos básicos están hechos de juntas de rótula mecanizadas. Esto permite que el modelo se pose en cualquier posición y mantenga esa posición. El gran problema está en la sincronización de todos los apéndices para dar la ilusión de un ser vivo. La mayor parte de esta ilusión depende de un sentimiento interno de movimiento por parte del animador.

AC: La rótula esférica: ¿es un nuevo desarrollo?

RH: Willis O’Brien lo ideó en los primeros días de la realización de El mundo perdido (1923), e incluso antes. La articulación esférica básica es un dispositivo bastante antiguo, pero Willis O’Brien fue uno de los primeros en adaptarlo al diseño de figuras en miniatura humanoides o animaloides con fines de stop-motion.

AC: ¿Ha habido muchos desarrollos recientes en la creación de movimientos de las criaturas?

RH: En el campo del stop-motion, no tantos. Por supuesto, el diseño real de cualquier criatura trae consigo sus propias innovaciones. Hay varios dispositivos para ayudar a hacer una animación más fluida, pero el movimiento en sí todavía está bloqueado en gran medida dentro del animador hasta que se libera mediante el uso de la fotografía stop-motion.

AC: ¿En qué se diferencian tus criaturas de los Muppets, por ejemplo?

RH: Un Muppet funciona con un principio completamente diferente. El Muppet es principalmente un títere de mano, que a veces utiliza dispositivos electrónicos. Han podido conseguir algunas caracterizaciones muy curiosas e interesantes, como la de Yoda, en El imperio contrataca, donde tenemos que recurrir al largo proceso de stop-motion para la creación de la ilusión de la vida, un Muppet puede ser fotografiado como un actor normal de acción en vivo.

AC: ¿Estás tentado a usar ese proceso?

RH: Hemos recurrido a los títeres de mano en los primeros días, como algunos planos de La Bestia de 20.000 brazas. Pero, en general, tendemos a no utilizar la técnica, ya que no es tan adecuada para nuestro tipo de historias.

AC: ¿Qué pasa con la electrónica, por ejemplo?

RC: Eso, de nuevo, es una posibilidad. Nos hemos adentrado parcialmente en la electrónica con Bubo, el búho mecánico de Choque de titanes. Hay algunas escenas en las que está controlado por radio.

AC: ¿Cuánto de Bubo en la película está controlado por radio?

RH: En bastantes escenas donde los actores lo manipulan. Sus alas baten, su cabeza girará, sus ojos girarán y su boca se abrirá. Pero básicamente, a menos que muchos búhos hayan sido hechos para hacer muchas cosas diferentes, sus movimientos son limitados. Por ejemplo, sería difícil hacer que un búho electrónico caminara o despegara y volara. Para este tipo de movimiento y caracterizaciones más complejas, nos pareció necesario recurrir a un modelo stop-motion.

El Bubo the Owl mecanizado de Choque de titanes.

AC: ¿Cree que el proceso electrónico es limitado?

RH: Es limitante porque estás recurriendo a motores para crear movimiento en lugar de animación donde tienes una gran flexibilidad. Es un problema completamente diferente cuando estás filmando un cohete y usando una cámara de computadora.

AC: ¿Qué es una cámara de ordenador?

RH: Una cámara de computadora es una cámara de repetición que repetirá sus movimientos exactos en stop-motion, acción en vivo o cámara lenta.

AC: ¿Es como una cámara stop-motion?

RH: Sí, a veces implica stop-motion. Se controla electrónicamente para que pueda repetir cada movimiento. Tiene que estar en una pista, tiene que estar engranado de cierta manera y tiene que estar programado para que, sin importar a dónde te muevas, pueda repetir esa posición exacta una y otra vez.

AC: ¿No te serviría de nada?

RH: No particularmente. Sin duda, sería una ventaja en ciertos tipos de escenas, pero no las hemos encontrado en este momento.

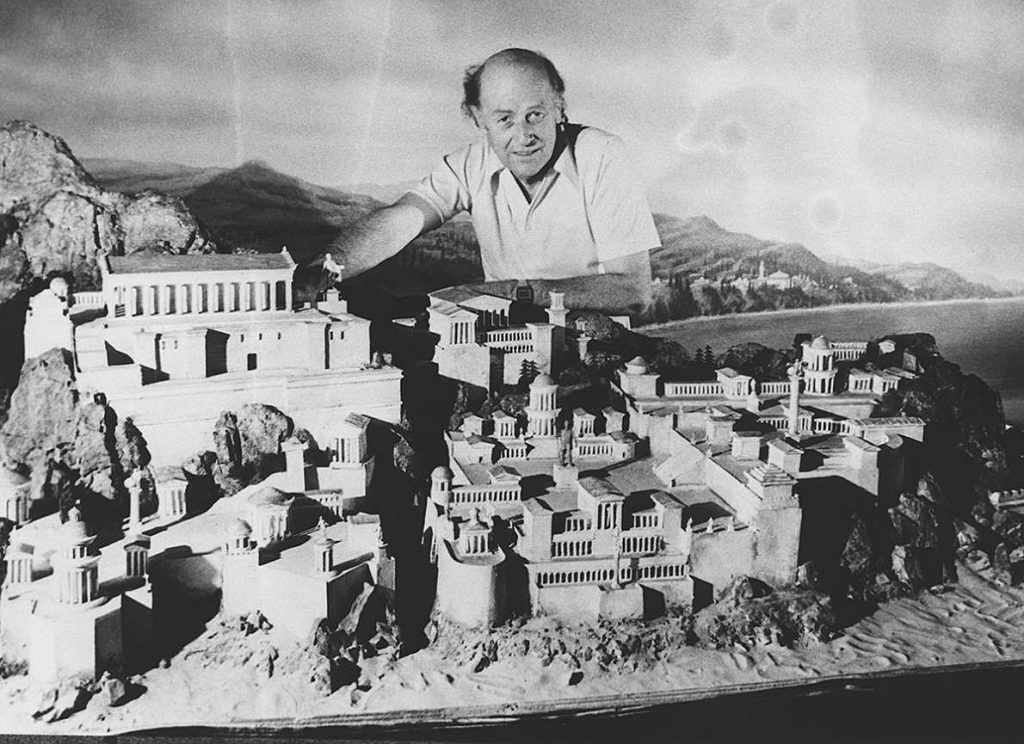

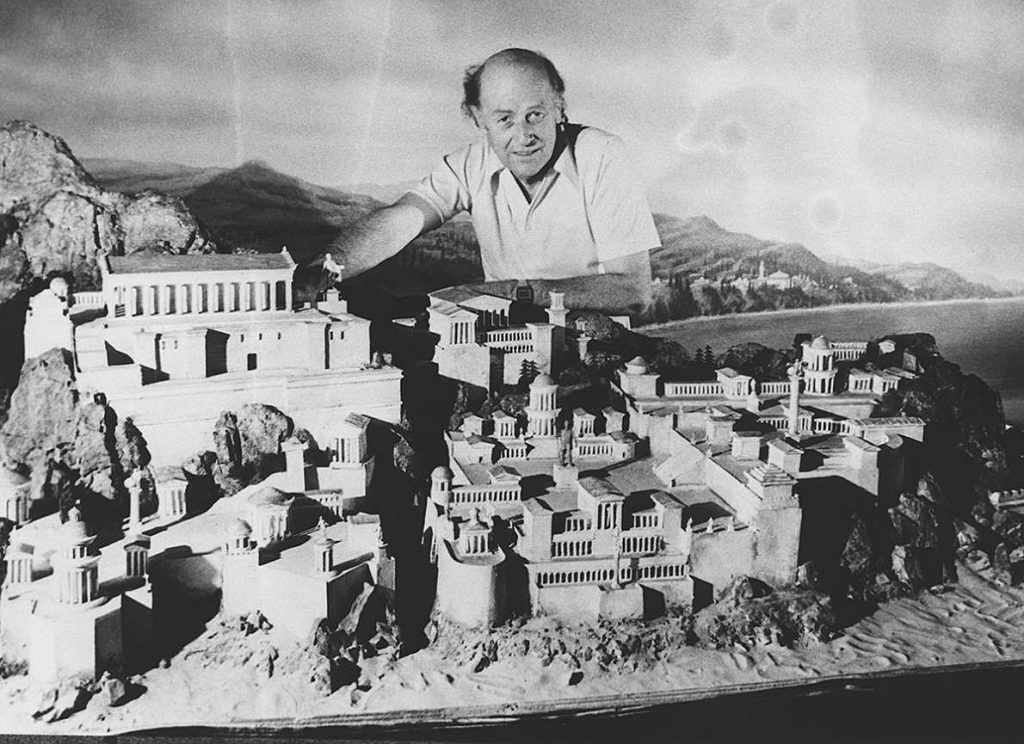

Harryhausen y su maqueta del Olimpo.

AC: Tu trabajo es muy personal, muy táctil, mientras que usar la cámara de una computadora es muy impersonal. ¿Será por eso que no le gusta el proceso electrónico?

RH: No es cuestión de si me gusta o no la cámara del ordenador. Es más, una cuestión de si se puede aplicar a nuestro tipo de película. Sí, siento que hay una conexión personal entre lo que hago y la forma en que se logra el efecto final. La animación stop-motion es una expresión personal del animador que necesita movimientos complejos junto con detalles de personajes improvisados. Hay una gran diferencia entre fotografiar una nave espacial inanimada volando por el espacio y los complejos movimientos de, por ejemplo, la pelea del esqueleto de Jason. Cada uno tiene su lugar en el tipo de historia que se cuenta.

AC: En Choque de titanes, ¿había alguna criatura que quisieras usar, pero no pudiste debido a restricciones presupuestarias?

RH: No, usamos todo lo que nos propusimos hacer.

AC: ¿Tienes un gran almacén de criaturas fantásticas acechando en tu mente esperando la oportunidad de emerger?

RH: Las criaturas se desarrollan a partir de la historia, pero probablemente tengo una serie de cosas en mi subconsciente que no saldrán a la luz hasta que se presente el guión adecuado. En choque, que trata de la mitología griega, traté de volver al pasado para ver qué habían hecho otros artistas. Descubrimos, por ejemplo, que Medusa tiene una enorme cantidad de variaciones. En algunas fotos es una mujer hermosa con serpientes en el pelo, en otras es simplemente una especie de fea ama de casa de clase media. Pero para nuestra situación, sentimos que Medusa debería tener el cuerpo de una serpiente. Queríamos que su rostro tuviera una estructura ósea hermosa, pero con un matiz feo porque no puedo imaginar a una mujer hermosa que convierta a alguien en piedra, incluso si tiene serpientes en el cabello. O tal vez se me hayan escapado las implicaciones más sutiles. Intentamos hacer que Medusa fuera más grotesca para que existiera la posibilidad de que su apariencia pudiera ser lo suficientemente aterradora como para convertir a alguien en piedra.

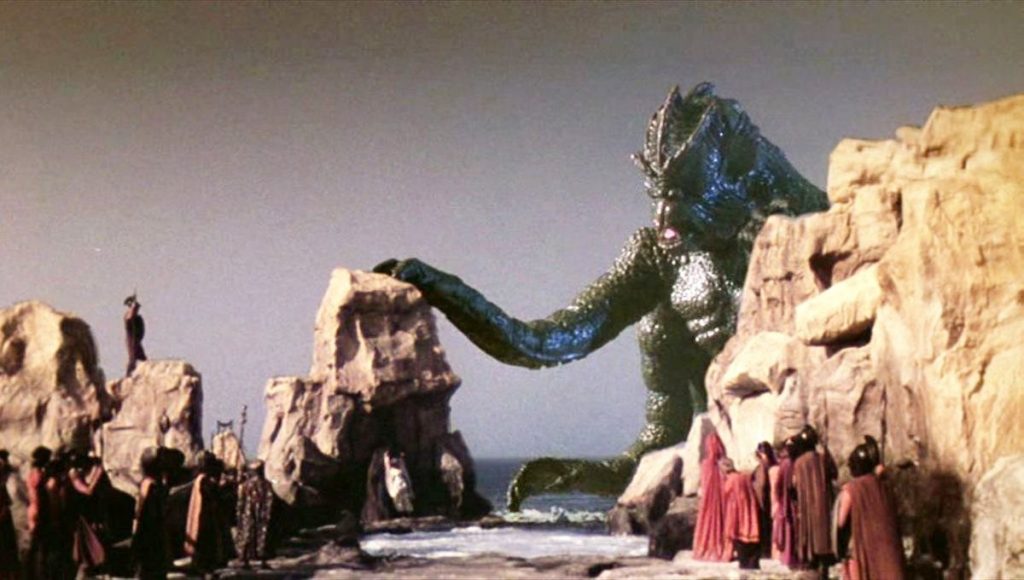

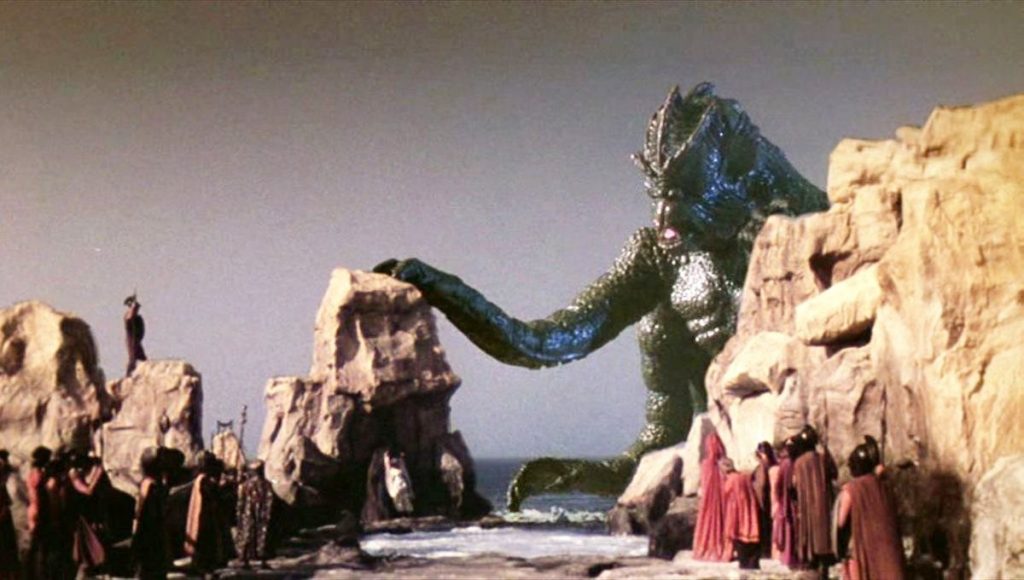

AC: ¿Qué pasa con el Kraken? Realmente no existe en la mitología. ¿Es totalmente tu criatura?

RH: Solo en el diseño. En el guión lo llamamos Kraken, aunque la palabra proviene de un período muy posterior en la historia cuando los marineros medievales regresaron con historias de calamares gigantes y ballenas, etc. Hubo un leviatán en los primeros tiempos griegos y bíblicos, por supuesto, y varios otros nombres para monstruos marinos grotescos. Andrómeda fue sacrificada a un monstruo marino de algún tipo y hay varias pinturas de su apariencia. A veces es un dragón, a veces un pez enorme pero nunca lo he visto como un pulpo. Intentamos que fuera una combinación. Queríamos que fuera un poco humanoide para dar una razón por la que la sacrificaron a esta cosa, de lo contrario, la criatura simplemente la devoraría y volvería al mar, una situación que no es muy dramática.

AC: ¿Da más miedo si la criatura tiene ciertas cualidades humanas?

RH: Sí, eso es lo que teníamos en mente. Le dimos cuatro brazos con la forma básica de una combinación de criaturas marinas. Hay una especie de concepto de tritón combinado con matices de pulpo. Le dimos cuatro brazos en lugar de ocho porque pensamos que le daría una apariencia más grotesca e inusual. Esto no fue porque tuviéramos problemas de presupuesto como los que tuvimos en la película It Came From Beneath the Sea, donde tuvimos que comprometernos con un pulpo de seis brazos para derribar el puente Golden Gate.

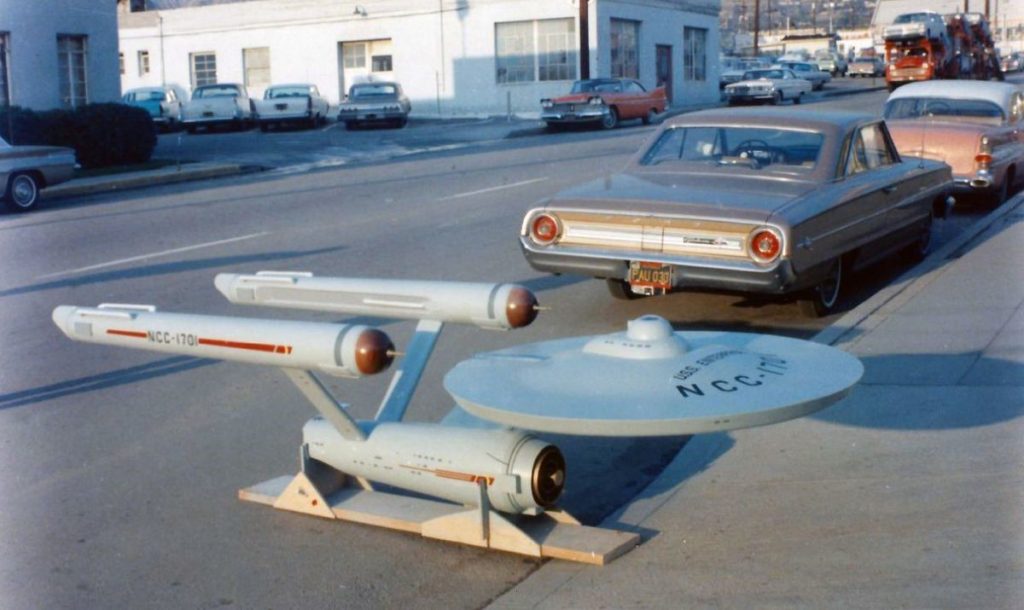

AC: Sin embargo, hubo problemas con el Kraken. ¿Nos parece recordar un gran Kraken flotando en el mar frente a Malta?

RH: Sí. Realmente me desagradan los hombres vestidos con trajes de dinosaurio casi tanto como me desagrada ver a un hombre con un traje de Kraken. A veces uno se ve obligado a usarlos por las circunstancias y el tiempo. Al final, usamos solo los tiros de Dynamation. Sin embargo, construimos un gran Kraken para las escenas submarinas. Bajo la supervisión fotográfica del camarógrafo submarino Egil Woxholt, construimos un set sumergido en Camino Bay, frente a la isla de Malta. Tuvimos que remolcar un modelo de 15 pies dentro y fuera de la jaula submarina. Como puedes imaginar, hubo muchos problemas al trabajar bajo el mar, además de trabajar con un modelo tan grande. Un gran inconveniente era que el miserable monstruo siempre quería flotar. Estaba hecho de una sustancia esponjosa. Muchos cientos de libras de plomo tuvieron que usarse como lastre.

AC: ¿Qué tal los escorpiones?

RH: Eran otro tipo de problema. Tenían ocho patas, dos garras y una cola, todo lo cual debía mantenerse en movimiento. Tuvimos que hacerlos a una escala mucho mayor que un escorpión vivo. El problema con los escorpiones vivos, incluso si encuentras uno talentoso, es que son difíciles de entrenar y hacer que hagan exactamente lo que requiere el guión.

AC: ¿Y Dioskilos, el perro lobo de dos cabezas?

RH: Uno de los grandes problemas en el diseño de Dioskilos fue que una vez que comienzas a separar dos cabezas del cuerpo de un perro normal, se vuelve grotesco. Tuvimos que manipular el diseño bastante para que pareciera creíble, pero salió bastante bien.

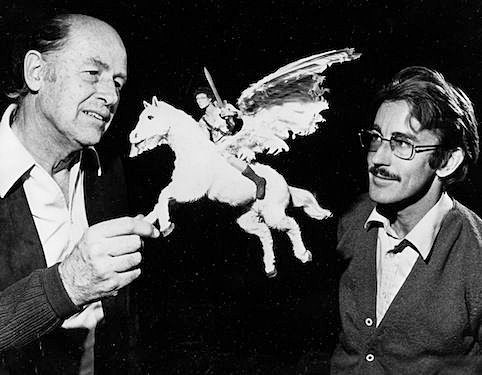

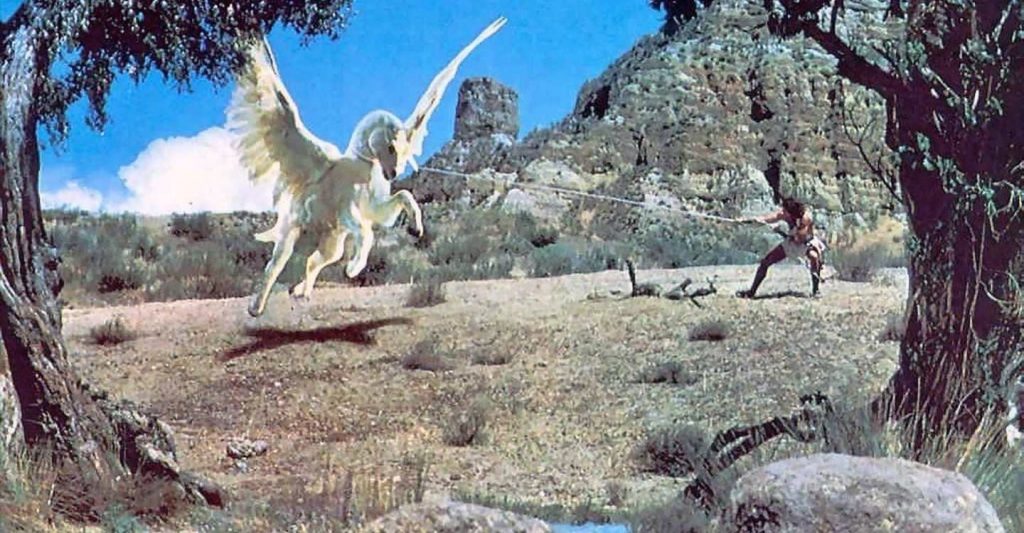

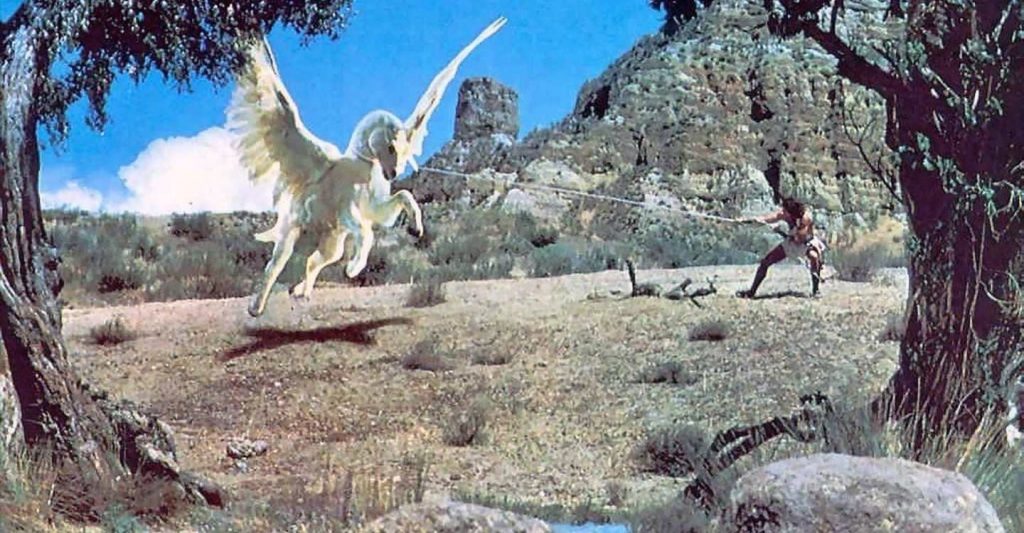

AC: ¿Pegasus, el caballo volador, es en parte real, en parte animación?

RH: Sí, debido al detalle de la cabeza de un caballo, usamos un caballo vivo en ciertas tomas, pero las tomas largas son todas animaciones.

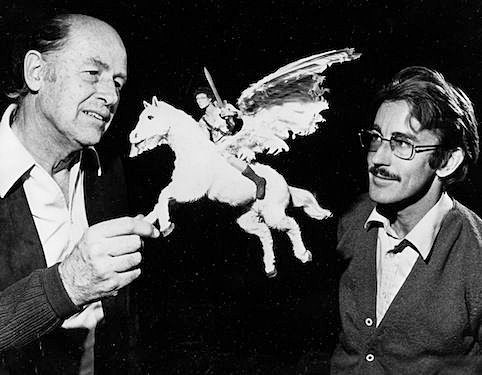

Harryhausen con el modelo y animador de Pegasus Jim Danforth, quien manejó gran parte del trabajo de stop-motion en el personaje alado.

AC: ¿Qué tamaño tienen los modelos que usas?

RH: Algunos de ellos son muy pequeños. Una vez hice un modelo de Raquel Welch de solo 3 ½ pulgadas de alto. En la película Un millón de años antes de Cristo, un pterodáctilo gigante tuvo que recogerla. No quería hacer un enorme lagarto alado de tamaño natural, así que hice una pequeña Raquel Welch y la animé fotograma a fotograma. Por supuesto, otros modelos pueden ser mucho más grandes, hasta dos pies y medio de altura.

AC: ¿Qué dicta el tamaño?

RH: Depende de lo que la criatura tenga que hacer. Muchas veces es más fácil trabajar con un modelo más pequeño. Casi me siento como el Dr. Frankenstein o el Dr. Cyclops en ese sentido porque tomo actores y los encojo para hacer que un modelo parezca grande en lugar de construir un modelo grande que es incontrolable.

Un primer plano de Raquel Welch en One Million Years BC (1966, Hammer Films)

AC: Antes de que comience la filmación, presenta toda la película en forma de guión gráfico. ¿Por qué?

RH: Porque al fotografiar cualquier cosa, hay una forma costosa de hacerlo y una forma económica. A veces, solo colocar la cámara un metro más abajo o un metro a la derecha o a la izquierda puede marcar la diferencia cuando estás animando la escena final. Es la diferencia entre pasar un día o 10 animando, debido a las complicaciones que presenta un ángulo de cámara particular. Encuentro que es muy importante diseñar todas las secuencias principales en forma de diagrama aproximado para tener un punto de vista armonioso con todos los involucrados. Ayuda a los actores a visualizar, así como al director y al fotógrafo. Repasamos la secuencia completa antes de la producción para ver si el director tiene algún cambio que cree que mejorará la escena. Por supuesto, siempre hay compromisos que uno tiene que hacer, cambios en el clima, vuelos chárter para tomar, etc.

AC: ¿Te importan los actores o son más importantes tus criaturas?

RH: Básicamente, estoy interesado en el producto en general. Como productor de esta película, me interesa más que solo mi papel. Quiero ver una imagen redondeada que produzca los mejores resultados, pero naturalmente, tengo prejuicios hacia las criaturas porque sentimos que son los valores inusuales de la producción.

AC: Con Titans tienes un grupo de actores caro. ¿Tienes un resentimiento furtivo de que una gran cantidad de dinero se les iba a ellos en lugar de a tus criaturas?

RH: No puedo negar que el pensamiento había pasado por mi mente. En el pasado, nos dimos cuenta de que la historia que estábamos contando no tenía un actor muy costoso, pero en Titans, sentimos que mejoraría el producto final al tener los mejores actores que pudiéramos conseguir.

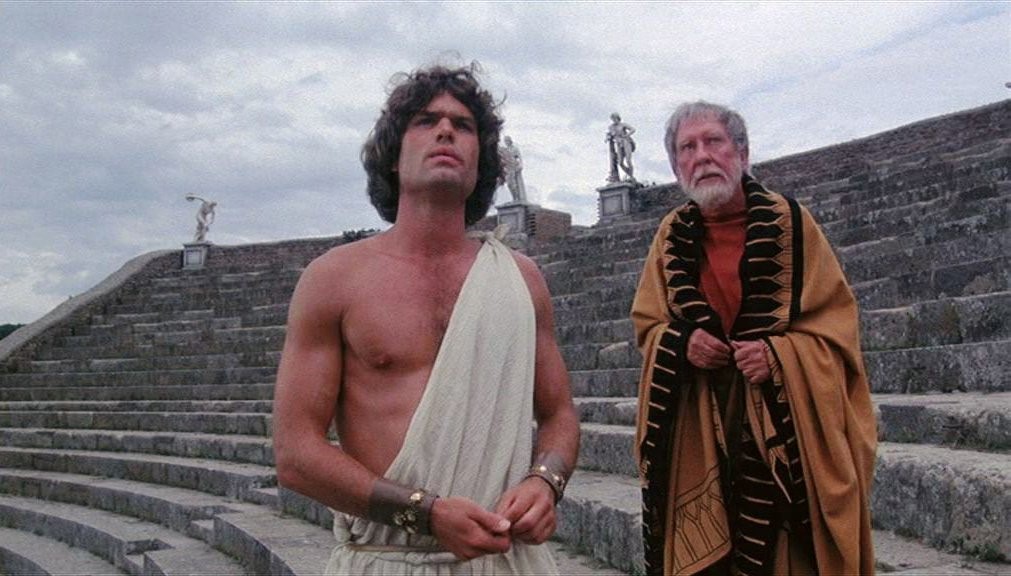

Entre las muchas estrellas (humanas) de la película, Harry Hamlin interpreta a Perseo, visto aquí con Ammon (Burgess Meredith).

AC: ¿Por qué nunca has dirigido una película completa tú mismo?

RH: El problema es que una película de esta naturaleza tiene tantas complicaciones, siento que te desgarraría intentarlo todo; algo debe sufrir. Nunca he estado tan intrigado con la dirección de acción en vivo.

AC: ¿Hay algún conflicto entre usted y el director?

RH: Siempre es posible un choque de personalidades, ya veces eso sucede. Tienes que afrontarlo lo mejor que puedas. No todo el mundo ve una determinada escena o situación de la misma manera. Puedo ver una escena desarrollada de cierta manera debido a mi experiencia previa y el director tendrá otras ideas. Es por eso que, antes de comenzar la producción, debemos acordar la forma en que se debe manejar una escena. Pero, a veces, de la batalla sale un producto mejor, otras veces simplemente estorba. Una vez se dijo: ‘Cuando dos personas piensan exactamente igual, una de ellas es innecesaria’.

AC: Las ideas de la historia, ¿son tuyas?

RH: No siempre. A Beverley Cross, por ejemplo, se le ocurrió Choque de titanes. Siempre había querido hacer esta historia, pero no podía encontrar una manera de resolver algunos de los problemas de la trama. He contribuido con historias en el pasado y luego alguien como Beverley o Jan Read o varios escritores las elaboran y las desarrollan en guiones.

AC: La mitología parece ser la principal fuente de su historia.

RH: Sí, creo que la mitología tiene una estructura integrada para las criaturas que podemos hacer mejor con Dynamation. No tienes que escribir el monstruo en la historia. Con muchas historias, encuentras que los elementos deben incorporarse solo para crear el espectáculo. Recuerdo que en mi juventud vi algunas de las primeras imágenes de Simbad en las que solo hablaban del elemento de fantasía, pero nunca lo mostraban. En consecuencia, las películas se convirtieron simplemente en policías y ladrones con trajes árabes. Nunca viste ninguna forma de magia o maravilla. Por supuesto, cuando vi El ladrón de Bagdad de Korda me estimuló aún más a creer que era una gran verdad que debes mostrar la fantasía en la pantalla de la misma manera que en los libros de cuentos y no solo hablar de ella.

AC: Las historias espaciales ocupan mucho tiempo en pantalla ahora. ¿No te interesan?

RH: Los encuentro terriblemente fríos e indiferentes. Las historias siempre tienen que ver con aparatos y máquinas y ocasionalmente hay un poco de participación personal dramática. prefiero el pasado; tiene una cualidad mucho más romántica, mucho más valor narrativo. De alguna manera, todas las imágenes espaciales terminan siendo muy similares. Sin embargo, si encontramos un buen guión, estaría encantado de probar uno. Hicimos Los primeros hombres en la luna de HG Wells, pero supongo que lo llamarías una epopeya espacial victoriana. Fue muy divertido, pero de nuevo volvimos al pasado, a 1900, durante la mayor parte de la película. En el prólogo y el epílogo sólo teníamos que lidiar con los cohetes espaciales actuales.

Los primeros hombres en la luna (1964, Columbia Pictures)

AC: ¿Cuáles han sido las principales influencias en tu trabajo?

RH: Ha habido muchas influencias cuando miro hacia atrás. Charles R. Knight, ilustrador de museos y excelente pintor. Restauró conceptos de animales prehistóricos para el Museo de Historia Natural de Nueva York. Cuando era niño, me sentaba durante horas a mirar sus libros de dinosaurios. El mundo perdido de Willis O’Brien me impresionó enormemente a la edad de cuatro años. El dinosaurio que cayó del acantilado al lodo de abajo se convirtió en un recuerdo imborrable. En Rey kongy su variado elenco de dinosaurios se convirtió en un estímulo que cambió mi vida por completo. La película de fantasía para acabar con todas las películas de fantasía. A través de O’Brien, conocí los maravillosos grabados de Gustave Dore y John Martin. Las películas de Merian C. Cooper, James Whale, Tod Browning, Rouben Mamoulian, Fritz Lang ampliaron mi imaginación. La lista podría seguir.

AC: ¿No has querido hacer una película basada íntegramente en criaturas animadas sin seres humanos?

RH: Realmente no. Me gusta pensar que mis intereses van más allá de las películas de criaturas. Dudo mucho que una audiencia pueda sentarse durante dos horas de solo personajes animados. Al principio, hacía cuentos de hadas animados de 10 minutos en película de 16 mm simplemente para ganar experiencia. Temas como Hansel y Gretel, Rey Midas, Rapunzel y otros. Todavía me encanta ver un buen musical, cualquier buen drama, algunas películas de terror. Laurel y Hardy me hacen reír sin control. Nunca habrá otro par como ellos.

AC: Ahora que te has convertido en una figura de culto, casi el padre del stop-motion, ¿Cuál ves como tu posición en el negocio en este momento?

RH: Realmente no tengo ni idea. Si me detengo a pensarlo dudo que pueda hacer algo más en el campo de la animación dimensional. Sin embargo, siento que llegará un momento en el que no podremos funcionar de la misma manera que lo hicimos en el pasado. La animación dimensional stop-motion es principalmente trabajo manual. Es personal para mí y ha sido toda mi carrera. Charles y yo estamos muy agradecidos de recibir muchas cartas de jóvenes que nos dicen que nuestras películas los han inspirado hacia una nueva carrera. Gracias a la televisión, hay muchas más oportunidades para la expansión de este campo.

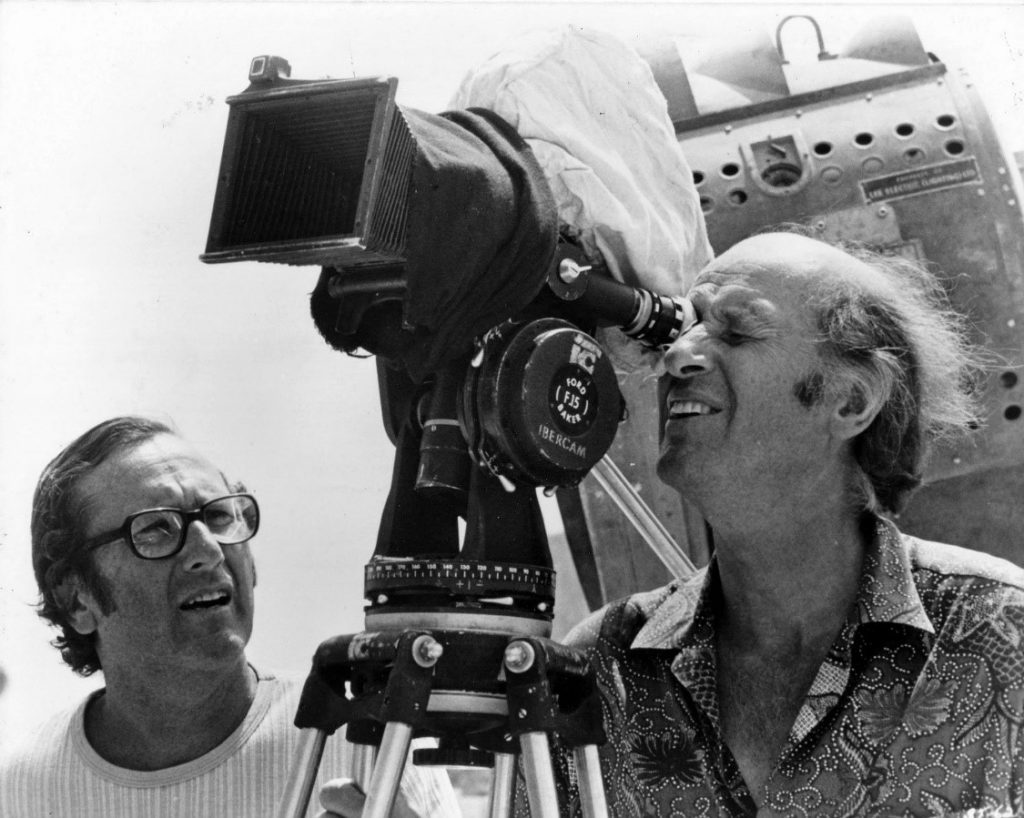

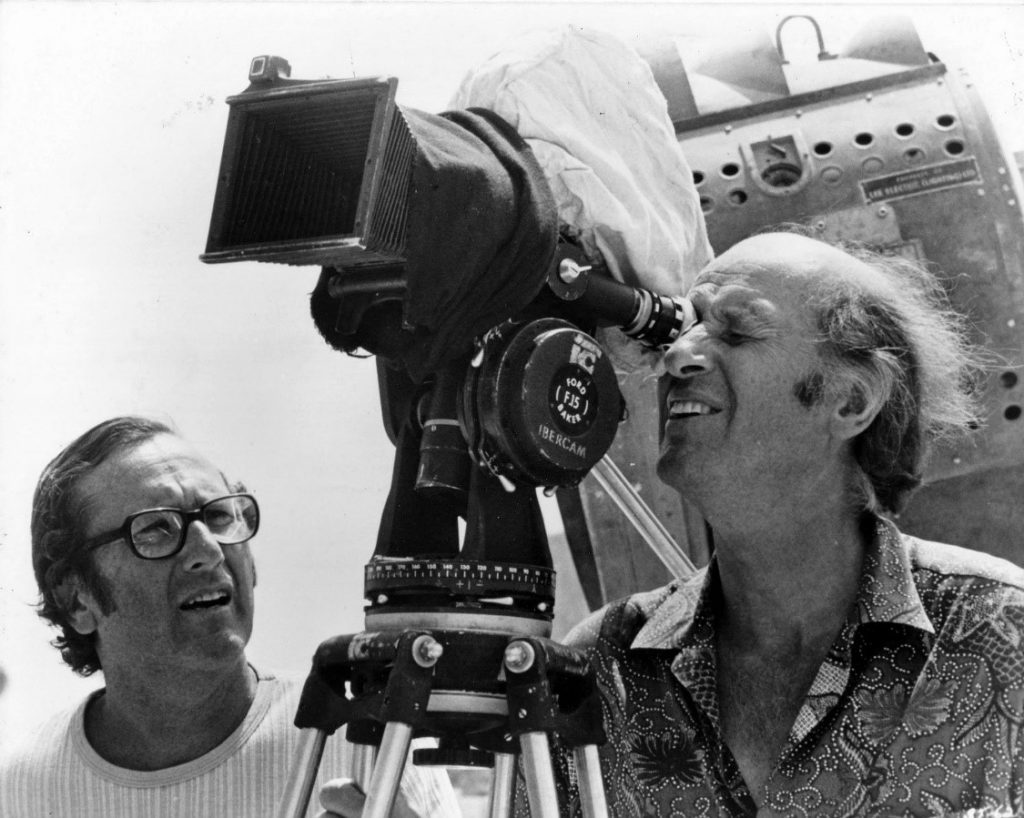

Harryhausen con el productor Charles H. Schneer. Primero trabajaron juntos en It Came from Beneath the Sea y han seguido siendo amigos y socios durante más de 30 años.

AC: Si te hubieras quedado en Hollywood en lugar de mudarte a Inglaterra, ¿crees que tu trabajo habría ido en una dirección diferente?

RH: Tendría que ser un profeta para responder eso. No tengo ni idea. Simplemente sentí que Hollywood no era el lugar para mí. Hicimos muchas películas y teníamos maravillosas condiciones de trabajo, pero para nuestro tipo de película de fantasía, sentimos que no serviría para nuestro mejor propósito.

AC: ¿Hay alguna película que realmente quieras hacer? Nos parece recordar que mencionaste el Infierno de Dante.

RH: El Infierno de Dante, como tal, sería una característica bastante tediosa, creo, pero ciertos elementos podrían incorporarse en el guión correcto. Sería un proyecto enorme y recuerdo haber dicho que me gustaría ver miles de almas atormentadas rodando por los cielos en el espíritu de Gustave Dore. Desafortunadamente, la historia completa de Dante puede no ser comercialmente viable”.

AC: Entonces, ¿qué vas a hacer a continuación?

RH: No tengo ni idea. Como decimos en Titans, ‘Está en el regazo de los Dioses’

En 1992, Harryhausen recibió un premio de la Academia por los logros de su vida en el cine. A pesar de su cuerpo de trabajo, nunca antes había sido nominado: En 2003, la Cámara de Comercio de Hollywood le otorgó a Harryhausen una estrella en el Paseo de la Fama de Hollywood, ubicado al otro lado de la calle del Teatro Chino de Grauman, donde vio por primera vez a King Kong cuando tenía 13 años. En su discurso de aceptación, Harryhausen señaló y dijo: “Todo para mí comenzó en ese teatro hace 70 años”.