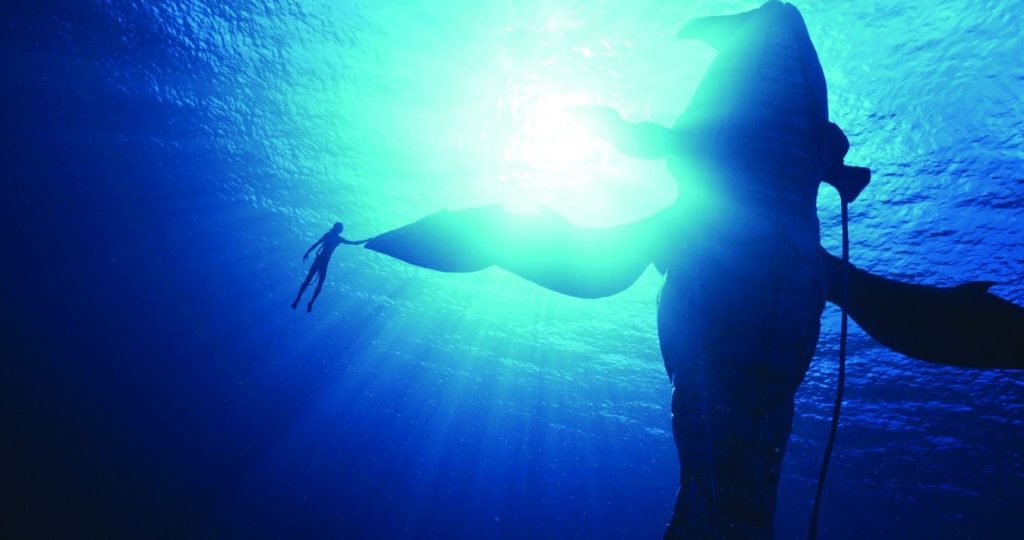

Lo’ak (Britain Dalton) se acerca para tocar un tulkun, una criatura parecida a una ballena nativa de Pandora.

American Cinematographer

Fotografía de la unidad por Mark Fellman. Todas las imágenes son cortesía de 20th Century Studios. 29 de Diciembre del 2022

Jain Marks y Noah Kadner

Russell Carpenter, ASC se unió a James Cameron para su regreso al reino Na’vi de Pandora. El éxito de Avatar: The Way of Water dependió completamente de la estrecha colaboración entre los expertos en los departamentos clave de la producción y otros profesionales destacados en sus campos. “Me considero el creador de la gran provocación y un montón de gente inteligente a mi alrededor para resolverlo”, dice el director James Cameron.

Un participante principal en este esfuerzo fue Russell Carpenter, ASC, cuyo trabajo con Cameron comenzó hace casi tres décadas en la exitosa película de acción True Lies (AC , septiembre de 1994). Su asociación creativa continuó con la atracción del parque temático 3D de Universal Studios Terminator: Battle Across Time (AC julio de 1996) y luego Titanic (AC diciembre de 1997), que les valió a ambos cineastas premios de la Academia.

En busca de una nueva prespectiva para su proximo largometraje, el Avatar original, Cameron recurrió a Mauro Fiore, ASC (AC, enero de 2010). “Sentí que Russell y yo ya nos conocíamos tan bien que no iba a aprender nada nuevo, así que elegí un director de fotografía diferente”, señala Cameron con su típica franqueza. “Mauro hizo un gran trabajo, pero no fue lo mismo que trabajar con Russell. No lo pensé dos veces antes de ofrecer a Russell la secuela, y volvimos a nuestra antigua forma de trabajar, que es muy colaborativa.

Ambientada en 2167, 13 años después de los eventos de la primera película, The Way of Water continúa la historia de Jake (Sam Worthington) y Neytiri (Zoe Saldaña), revelando el problema que sigue a su familia Na’vi cuando la despiadada Administración de Desarrollo de Recursos (RDA) empresa minera regresa a la luna de Pandora con la dominación total en su agenda.

«La historia es lo principal», dice Cameron, «y hemos construido toda nuestra estética en torno a ella». Los personajes fotografiados interactúan con los personajes y entornos generados por computadora en mucha mayor medida que en la primera película, y numerosas escenas se desarrollan bajo la superficie de los vastos océanos de Pandora.

Carpenter abordó el proyecto a principios de 2018 y pasó un año preparándose para la producción física mientras supervisaba la iluminación virtual de muchas secuencias CGI en Gazebo, la herramienta de iluminación en tiempo real de Weta FX desarrollada por el supervisor de efectos visuales de Weta, Dan Timonel. “Jim enfatizó que la luz en cada escena de Pandora debe mostrar muchos matices de color diferentes según el entorno de cada escena, y nunca ser ‘simplemente neutral’”, dice el director de fotografía. “Cuando sea posible, la luz debe ser una expresión viva y palpitante de la vida de Pandora. En mi mente, esto me llevó de vuelta a los paisajes de la escuela del río Hudson, en los que el mundo natural y sus habitantes coexisten pacíficamente. El proceso de iluminación de estas escenas virtuales fue invaluable.

“Aunque habían pasado 25 años desde que Titanic, existió la sensación de que Jim y yo retomáramos donde lo dejamos. Es igual de ambicioso en su visión, y los desafíos que me presenta me mantienen totalmente involucrada”, dice Russell Carpintero, ASC

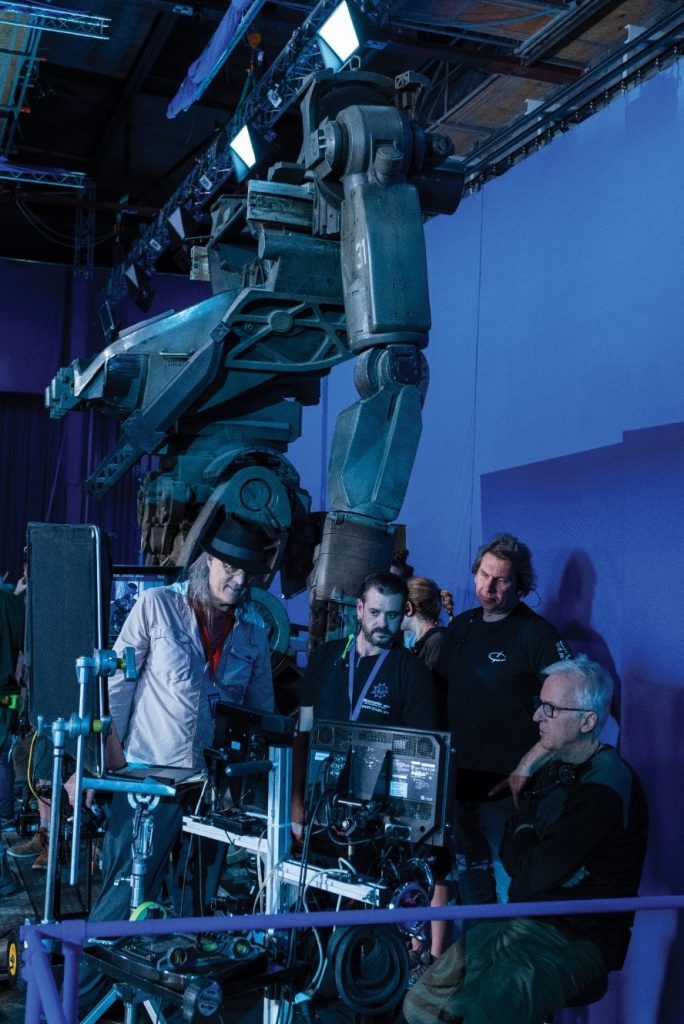

James Cameron y Russell Carpenter, ASC en el plató.

Perspectiva de Pandora

Carpenter fotografió partes de acción en vivo de The Way of Water en 3D nativo utilizando una nueva versión del equipo de doble cámara de Cameron-Pace. El sistema modular se podría construir en diferentes configuraciones para satisfacer las necesidades de producción, y cada una constaba de dos cámaras Sony Venice en su modo de generación de imágenes 4K 17:9 para entregas de 2,39:1 y 16:9. Cameron señala que, si bien el formato de pantalla panorámica es mejor para la exhibición en 2D, «el 3D prospera en 16:9, donde tienes una parte de la imagen en tu regazo, así como a ambos lados»

Carpenter usó el conjunto ISO 2500 consumiendo una potencia significativa o comprometiendo la calidad de la imagen. La exposición adicional también ayudó a compensar la pérdida de dos diafragmas al grabar a 48 fps a través del divisor de haz de la cámara 3D. En la edicion, los servicios de corrección de movimiento fueron proporcionados por Pixelworks, que usó su plataforma TrueCut Motion para emular 24 fps y reducir los artefactos de desenfoque de movimiento. “Eso fue bueno para Weta, ya que les dio imágenes más claras con las que trabajar”, dice Carpenter.

Para Cameron, las imágenes estereoscópicas son solo un componente de una producción grande y complicada, tan complicada que «literalmente no hay un solo ser humano que entienda todos los aspectos de ella», dice.

El esquema de iluminación para escenas ambientadas dentro de un laboratorio dirigido por el RDA.

El coronel Miles Quaritch (Stephen Lang) resucita en el laboratorio.

Trabajo de agua

Performance comenzó en 2017 en un volumen de captura de movimiento subacuático personalizado construido en el escenario 18 en Manhattan Beach Studios en Los Ángeles; el espacio medio aproximadamente 42’x85’x32′ y presentó un pozo profundo de 15’x15’x15′. El desafío principal fue capturar una acción submarina convincente. El supervisor de producción virtual de Lightstorm Entertainment, Ryan Champney, quien dirigió el esfuerzo de investigación y desarrollo en coordinación con Cox, dice: «Comenzamos con un montón de pruebas de seco por húmedo con plataformas de alambre tradicionales, pero Jim insistió en que construyéramos un tanque para un movimiento realista».

Carpenter señala que el diseño del tanque “era bastante flexible: podía representar aguas profundas, aguas poco profundas, aguas tranquilas, agua en movimiento, etc. Tenía una enorme turbina que movía el agua a modo de pista de carreras. Incluso construyeron rápidos para que nuestros actores y el grupo de captura de movimiento descendieran a una velocidad bastante decente”.

Los actores Kate Winslet y Sigourney Weaver muestran sus trajes mocap.

“Tuvimos que averiguar qué se rompería”, dice Champney. “Por ejemplo, una cámara mocap tradicional usa [emisores] infrarrojos, y esa energía se absorbe en el agua muy rápidamente. Entonces, encontramos una longitud de onda cercana al ultravioleta que viajaría de manera eficiente a través del agua y aún sería sensible al sensor de la cámara. También hicimos que un maquinista construyera carcasas impermeables para las cámaras mocap”.

Aunque la acción capturada en el volumen submarino era virtual, los actores necesitaron decorados con los que interactuaron. “Un set de captura consiste solo en lo que los actores tocan y atraviesan físicamente, se arrastran, se aferran, todo ese tipo de cosas”, explica Cameron. “La pregunta era: ‘¿Cómo mantenemos el cronograma si tenemos que construir escenario para un cambio de escenario de la noche a la mañana o incluso el mismo día?’ Construimos una plataforma que cubre todo el fondo del tanque y la colocamos sobre cables. Podríamos sacarlo a la superficie y colocar piezas prefabricadas. Podríamos cambiar un set completo de una escena a otra en un par de horas, o durante el almuerzo”.

Captura de la acción submarina.

La iluminación en el volumen submarino debe ser pareja y plana para soportar las cámaras mocap. El equipo colocó 60 Arri Skypanel S60-C sobre el agua para crear un alto nivel de luz ambiental, pero primero tuvo que superar los reflejos en la superficie del agua. “[Los reflejos] provocaban registros de datos falsos y ruido en el sistema de captura de movimiento”, señala Champney. “Entonces, tomamos prestada una idea que tenía Jim [para bloquear la luz del sol para que no ilumine un tanque de agua profunda] y cubrimos la superficie del agua con pequeñas cuentas de plástico. Eran huecos, con un caparazón de 2 mm de espesor y casi opacos. Se podía ver la luz a través de ellas desde arriba, pero solo si [las cuentas estaban] fuertemente iluminadas. En cuanto a la seguridad, todos los que trabajaron en el tanque pudieron romper fácilmente la superficie del agua, y las perlas proporcionaron una iluminación agradable y uniforme en el fondo y eliminaron los reflejos».

El equipo también capturó un extenso trabajo de rendimiento seco por seco en un volumen construido tradicionalmente en Manhattan Beach Studios. “Desvinculamos el proceso de cámara virtual de la captura de rendimiento”, dice Cameron. “Uso mi cámara virtual de la misma manera que un director usaría un visor: camino con ella para trabajar en la puesta en escena general y ensayamos. Me da una idea de dónde estarán todos los personajes en el entorno, pero una vez que tenemos marcas aproximadas, dejo [la cámara virtual] a un lado; Se lo doy a otra persona para crear una especie de registro de campo amplio de lo que sucedió porque ahora estoy más interesado en las actuaciones [de los actores]”.

Como referencia, Cameron también implementó una matriz de 12 a 16 cámaras Sony PXWX320 XDCAM 3-CMOS de ½» con lentes de kit Sony de 5.8-93 mm y cámaras PXW-Z450 4K HDR 2/3″ Exmor R CMOS con Fujinon 8- Lentes de 176 mm (UA22x8BERD). “Uno de los mayores obstáculos con los que nos encontramos en la primera película fue crear un proceso de edición desde cero”, recuerda el director. “Tener una referencia de video es absolutamente crítica porque eso es con lo que editas. Las cámaras suelen ser portátiles porque los operadores deben ser rápidos y flexibles. Tenía una matriz de pantalla de 16 vistas en el set para revisar todos los ángulos y asegurarme de que las actuaciones de los actores resultaron fotografiadas correctamente”.

Cameron supervisa a los actores en un volumen personalizado de captura de movimiento bajo el agua construida en Manhattan Beach Studios en Los Ángeles.

Integración virtual

En enero de 2019, Carpenter y su equipo partieron hacia Nueva Zelanda, donde su tarea era combinar el mundo virtual con la fotografía de acción en vivo. El movimiento de la cámara y el tamaño de la lente tendrán que coincidir exactamente. “Todas las mañanas en el set, hubo que alinear la cámara [3D] de acción en vivo con la posición de la cámara virtual”, dice el director de fotografía. “Fue un proceso laborioso. Nuestra iluminación no solo tenía que coincidir con las características de las tomas virtuales, sino que también tenía que llegar al actor exactamente en el lugar correcto y en el momento adecuado”.

Una de las primeras tareas del negocio de Weta FX fue desarrollar una nueva Simulcam, el sistema de cámara virtual diseñado para el Avatar original. La Simulcam puede hacer una composición en tiempo real de elementos virtuales y prácticos e introducirla en el visor de la cámara de producción para que el operador vea el mundo entero compuesto casi en tiempo real. Todos los componentes están registrados y alineados en el espacio 3D para que el operador de cámara (y aquellos que miran el monitor de producción) mantengan la escala adecuada de lo práctico y lo virtual, lo que permite el encuadre en tiempo real de lo práctico y lo virtual simultáneamente.

“Jim dirigió y operó a través de la lente en la plataforma portátil 3D”, explica Carpenter. “Cameron McLean operaba nuestras tomas de Steadicam y tomas de grúa, y Richard Bluck [NZCS], cuando no atendía a sus responsabilidades de DF de la segunda unidad, a veces también operaba. El equipo de cámara de Nueva Zelanda, encabezado por el 1.er AC Brenden Holster, fue excepcional; a pesar de que enfrentaron una miríada de desafíos diarios, siempre mantuvieron las cosas fluyendo sin problemas. El equipo de Nueva Zelanda fue excelente, y eso incluye a todos los departamentos”.

Gaffer Dan Riffel señala que «en cualquier lugar donde un pie humano toca el suelo», como esta escena con el actor Jack Champion, requería una construcción de escenario práctica.

El supervisor de captura de movimiento de Weta FX, Dejan Momcilovic, dirigió un equipo encargado de actualizar la tecnología Simulcam para The Way of Water. “El mayor desafío fue integrarse con la producción y no ralentizar todo”, dice Momcilovic. “Teníamos escenarios donde el primer plano es CG, con acción en vivo detrás, luego más CG y luego más escenario. Fue bastante complejo. La solución fue una combinación de aprendizaje automático y cámaras de visión por computadora.

“Comenzamos a escanear con LIDAR los conjuntos cuando estaban a punto de completarse y generamos una gran cantidad de datos de entrenamiento para nuestra red neuronal”, continúa Momcilovic. El sistema de red neuronal aprende la geometría básica del conjunto a partir de estos datos LIDAR y luego puede predecir esa geometría para la composición. “Inferimos una disparidad de objetos en una cámara, la convertimos en profundidad y luego la proyectamos de vuelta al espacio y la observamos con la cámara principal”, continúa. “La cámara de visión artificial es muy rápida a la hora de adquirir la imagen, por lo que estamos un cuadro por delante y listos para la composición. Gazebo manejó la representación en tiempo real por separado, por lo que la imagen compuesta final en el visor tiene un retraso de cuatro a seis fotogramas, según la complejidad de cada escena”.

“El sistema podía decir dónde estaban nuestros personajes de acción real y luego diferenciar lo que había detrás y delante de ellos”, dice Carpenter. “Proporcionó una vista previa tremendamente útil de cómo los personajes virtuales interactuaban con la acción en vivo”.

Lo físico se encuentra con lo virtual

La Simulcam también ayudó a Carpenter a combinar su iluminación con su contraparte CG. “Si Weta tiene un personaje generado por computadora junto a nuestro personaje de acción en vivo, obviamente tienen que tener la misma luz”, dice Cameron. “Estás clavando una estaca en el suelo, por lo que debes hacerlo bien, y es por eso que fue tan importante planificar previamente y llevar a cabo el proceso de iluminación a la p

Mientras observaba las sesiones de captura de movimiento de Cameron en Los Ángeles, Carpenter y el gaffer Len Levine notaron que el director podía realizar cambios importantes en el escenario virtual rápidamente. “Si Jim quisiera mover una cascada o el sol, alguien en un banco de computadora podría hacerlo, por lo que queríamos crear un entorno de acción en vivo que le permitiera trabajar de manera fluida y al mismo tiempo lo suficientemente flexible como para manejar decenas de diferentes escenarios de iluminación”, dice Carpenter. Un uso extensivo de la iluminación práctica y de la construcción en piezas que pudieron ensamblarse rápidamente fueron claves para lograr esto. Para los conjuntos RDA, este enfoque incluye el uso extensivo de las prácticas LED de cinta RGBTD, así como los tubos Astera Helios y Titan y los accesorios móviles Vari-Lite VL2600 automatizados.

Las pantallas LED proporcionan imágenes de fuego para el fondo de una escena de batalla.

Jake (Sam Worthington) y Neytiri (Zoe Saldaña) luchan por su patria sitiada y en llamas.

El sistema Simulcam es para diferentes propósitos durante las fases virtual y física de la producción. “Las responsabilidades del equipo de acción en vivo estaban más centradas en su operación general, mientras que la ‘barra mental’ de producción virtual estaba más orientada hacia la captura de rendimiento y la cámara virtual, aunque los sistemas y el personal en ambos casos tenían funciones superpuestas”, dce Champney. “Casi todo nuestro software está hecho a la medida. Atlas y Gazebo son los motores de renderizado/evaluación y diseño de escenas de Weta, respectivamente, que se conectan a las aplicaciones host de Autodesk Maya y MotionBuilder. Manuka proporciona una representación de datos de cómo la luz interactúa con las superficies”.

Utilizado como una herramienta de preiluminación, Gazebo es capaz de iluminar escenas y proporcionar una vista previa cercana a la calidad final renderizada. También permite bloquear las fuentes de luz como si estuviera trabajando en un plato de cine real. Como resultado, Weta puede iluminar escenas con previsibilidad y, especialmente para el ejército de animadores del proyecto, es importante ver cómo se ve su trabajo con la iluminación, y Gazebo cierra esa brecha.

Cameron (operando la cámara en la parte inferior) y el equipo filman una escena del océano, mientras las placas de efectos reproducidas en las pantallas superiores crean reflejos en el agua en la cámara.

Champney señala que el renderizador Manuka fue desarrollado por Weta para trabajar en conjunto con Gazebo: “Puede procesar grandes cantidades de datos en mucho menos tiempo. La iluminación realizada en Gazebo se puede transferir a Manuka y parece casi exactamente similar. Esto se debe a que ambos programas tienen los mismos modelos de reflectancia que se basan en la iluminación del mundo real.

“El software que alimentaba datos a Manuka consistía en el sistema de captura de rendimiento en tiempo real Giant [de Lightstorm Entertainment] y nuestro sistema de transmisión de hardware, que se comunica con los diversos dispositivos: grúas, cámaras virtuales, plataformas 3D, unidades de medición inercial, etc.”

Durante la preparación, para comprender y procesar el alcance y la sensación de cada escenario, Levine combinó los modelos del departamento de arte, del departamento de los modelos de construcción de los escenarios, material preliminar, notas de Cameron de techvis y notas de escena de Carpenter para crear planes de iluminación 3D en Vectorworks durante más de 50 decorados físicos programados para la construcción en Stone Street Studios y Turner Warehouse en Wellington, así como en Kumue Studios en Auckland.

Primero se fotografiaron las escenas de acción en vivo de RDA Aesthetic que involucran sets de RDA. “Una de las cosas que trasladamos de la película original fue la estética en conflicto entre el mundo natural de Pandora y el mundo humano artificial de RDA”, explica Carpenter. “Dentro del complejo RDA, la luz es a veces mundana y utilitaria, pero otras veces dura, bastante poderosa e invasiva. Cuando vemos luz natural entrando por las ventanas, es en un ángulo geométrico agudo”.

Cameron captura una toma POV desde dentro de una nave RDA.

El más grande de estos conjuntos fue la cubierta del pozo de popa de dos pisos del buque gigante Sea Dragon de RDA. Ubicado en el K Stage en Stone Street, presentó dos prácticas cañoneras de tamaño completo y dos piscinas lunares con sumergibles. En un extremo de la cubierta había una puerta de bahía a través de la cual Carpenter podía empujar la luz del sol. “Colocamos ArriMaxes en un cóndor para abordar los trazos amplios, uno con un reflector puntual y otro con un reflector plano”, explica Levine. “Usamos las luces potentes Vari-Lite VL6000 Beam para rayos de luz solar específicos, las luces Robe BMFL Blades y VL2600 para haces de luz y acentos más refinados, y una serie de Arri SkyPanel S360-Cs para el ambiente”.

Carpenter (extremo izquierdo), Cameron (extremo derecho) y el equipo se reúnen junto a un imponente suit AMP.

Dentro de la nave, las cajas de luz con SkyPanel S60-C en configuraciones de cuatro y ocho luces se pueden subir y bajar en cualquier ángulo desde una estructura. La iluminación de efectos se reforzó con Chroma-Q Studio Force D XT 12s para flashes y Maxi Brutes de 12 luces para explosiones. Los programadores de iluminación Scott Barnes y Elton Hartney James dirigieron el espectáculo desde una consola ETC Hog 4-18, que normalmente se usa para eventos en estadios y atracciones de parques temáticos.

El paso crítico de igualar el color y la calidad de la iluminación real y virtual se realizó en gran parte a ojo. Carpenter educó ediciones preliminares de escenas que usaban su iluminación virtual, y la composición estéreo en tiempo real de Simulcam de la cámara y las imágenes generadas por computadora le presentaron una aproximación básica del resultado final.

Océano pandora

En Kumeu Film Studios, se construyó un tanque de superficie de 75’x100′ en el escenario B para escenas oceánicas de acción en vivo. Presentamos a Carpenter placas de efectos para reproducir en pantallas de video LED de 20’x10′ alrededor del tanque con el objetivo de crear reflejos «en la cámara» en lugar de crear reflejos de agua en movimiento en CGI. Los reflejos de la superficie del agua se consiguieron colocando las pantallas sobre cabezas móviles y grúas. Para los reflejos en el agua, una plataforma rodante en cada lado largo del tanque sostenía dos pantallas de 10’x20′ reflejadas en un espejo de 40′ parcialmente sumergido en un ángulo de 45 grados para hacer que los reflejos deseados se encontraran con la línea de agua en lugar de tener una brecha. Carpenter descubrió que las pantallas funcionaban mejor para crear reflejos que iluminaban a los actores, por lo que se aumentaron con unidades Chroma-Q Studio Force II 72 mapeadas en píxeles y «redes» de Astera Titan Tubes conectados en cadena atados con un cordón. Vinculados a las secuencias de reproducción de la pantalla de video, proporcionan una iluminación interactiva sincronizada.

Cuando terminó el rodaje de Auckland, Levine le pasó la batuta a Dan Riffel, quien acompañó a la producción de regreso a Stone Street para el último segmento del rodaje.

“No conozco a ningún otro cineasta en el mundo que use la tecnología de esta manera. Hemos mejorado el juego no solo en el espectáculo, sino también en el lado emocional de las cosas”.

Ronal (Winslet), Tonowari (Cliff Curtis) y el clan Metkayina del pueblo Na’vi están iluminados por flora bioluminiscente debajo de la superficie del agua.

Altura desafiada

La altura promedio de los Na’vi de 9′ planteó un desafío único para las líneas de visión y las composiciones necesarias para ubicarlos de manera convincente en el mismo marco que los personajes humanos. Para el Avatar original, el equipo se basó en objetos proxy como pelotas de tenis para guiar la mirada de los actores, pero Cameron quería un método mejor. Idear la solución recayó en el veterano de Avatar y especialista en tecnología Casey Schatz, jefe de producción virtual en The Third Floor.

“Las líneas de los ojos siempre han sido un problema para los efectos visuales”, observa Schatz. “No importa cuán increíblemente represente Weta una criatura, si el actor mira hacia un lado y el monstruo está en otro lado, la ilusión muere. Diseñamos un equipo de cámara con cable de cuatro ejes increíblemente silencioso que lleva un monitor SmallHD y un altavoz Bluetooth. Se movía en perfecta perfección con la captura de movimiento original para que los actores humanos pudieran reaccionar con precisión en el lugar espacial en el que estarían los personajes generados por computadora”.

Cameron agrega: “Una vez que empezamos a andar por el camino de la cámara por cable, sabíamos que tendríamos platos abiertos y los llenaríamos con extensiones CG, lo cual es fácil en estos días. El monitor podía girar si giraba la cabeza del personaje virtual. Ejecutamos el video de la plataforma de la cara del actor de la sesión de captura de movimiento original. El audio de su diálogo también era direccional, por lo que fue muy inspirador para los actores [que lo interpretaron]. Literalmente, cada escena de acción en vivo involucraba personajes generados por computadora y/o extensiones del set”.

El sistema de cámara por cable resultó ser un desafío para los técnicos porque tenía que interactuar con los actores mientras evitaba de manera segura los escenarios, la iluminación, los aparejos y otros posibles obstáculos. Para abordar el problema, Schatz visualizó cada conjunto en Maya utilizando datos de un escáner láser Leica BLK360 y luego trazó cuidadosamente la ubicación y el movimiento de los suplentes de la cámara de cable. «Colocamos las cuatro torres [de la cámara de cable] en relación con la acción en vivo junto con los cables», dice Schatz. “Podría intercambiar los técnicos con los departamentos de arte, cámara y rigging, que trabajaron en Vectorworks. Si necesitaran agregar una luz o traer la grúa Escorpio, por ejemplo, sabríamos si necesitamos reajustar para evitar golpear algo. Se convirtió en Tetris en la parte superior de un cubo de Rubik para acomodar la cámara y la iluminación y evitar que los cables se enreden con cualquier cosa en el set durante los movimientos.

“La gran provocación”

Después de que el Covid-19 interrumpiera el rodaje en 2020, un equipo reducido volvió para la fase final de la filmación de acción en vivo en Nueva Zelanda. Luego, Cameron comenzó la posproducción intensiva, en coordinación con Weta FX para refinar el material virtual hasta el píxel final. The Way of Water se terminará después de cinco años de producción, pero Cameron continúa trabajando en las próximas secuelas, la próxima de las cuales está prevista para 2024.

“No conozco a ningún otro cineasta en el mundo que use la tecnología de esta manera”, se maravilla Carpenter. “Hemos mejorado el juego no solo en el espectáculo, sino también en el lado emocional de las cosas. El corazón de Avatar: The Way of Water es sobre la familia y lo que constituye la familia. También se trata de pertenecer y el dolor que uno puede sentir si no pertenece. En el tiempo transcurrido entre el primer Avatar y este, se invirtió una cantidad increíble de investigación y tecnología para poder recrear y transmitir las pistas emocionales diminutas que nos damos unos a otros. Creo que hay más matices para que la audiencia los detecte en la actuación de cada actor, y eso hace que nuestra conexión emocional con la historia sea más poderosa”.

Cameron concluye: “A pesar de lo difícil que es el momento, termina con una gran sensación de satisfacción. Sé que Russell está orgulloso de su trabajo en esta película, y debería estarlo.

La hija de Jake y Neytiri, Tuk (Trinity Jo-Li Bliss), nada con un banco de peces.

Avances dimensionales

Siempre hay algo interesante en la forma en que James Cameron hace una película. Al principio de su carrera, aprendió a maximizar sus recursos mientras trabajaba en los departamentos de diseño de producción y efectos visuales en películas producidas por Roger Corman. Las siete películas que ha dirigido, desde The Terminator (AC April ’85) hasta Avatar, se destacan por su uso innovador de efectos especiales y visuales, que a menudo involucran combinaciones perfectas de métodos tradicionales y nuevas en producción y postproducción. Cameron, que ya no está limitado por los recursos, continúa ampliando los límites de la tecnología cinematográfica.

Carpenter y Cameron filman imágenes de acción en vivo con el equipo de cámara 3D Cameron-Pace Fusion.

Cámara 3D Cameron-Pace Fusion

Dos innovaciones en Avatar fueron la cinematografía virtual y la producción virtual, términos acuñados durante la producción de la película en 2007-2008 para describir la integración en tiempo real de personajes virtuales y de acción en vivo, la captura de la actuación dentro de un volumen y el uso de una cámara. El proceso fue ideado por Rob Legato, ASC, quien también se desempeñó como ingeniero de canalización de efectos visuales de la película.

Un tercer avance fue el desarrollo del equipo de cámara 3D Cameron-Pace Fusion de doble lente, que se obtuvo para filmar el material de acción en vivo. Era el sistema más sofisticado de su tipo en ese momento y una evolución del diseño del divisor de has empleado en los documentales 3D de Cameron Ghosts of the Abyss (AC julio ’03) y Aliens of the Deep (AC marzo ’05). El diseño de Fusion presentó dos bloques de sensores Sony HDW-F950 CineAlta HD de ⅔» y lentes de zoom Fujinon, el HA16x6.3BE o el HA5x7B-W50 especialmente diseñado, con convergencia y distancia interocular controlada a distancia, basada en sistemas 3D), la configuración permitió un enfoque más sutil y versátil para la captura estereoscópica.

Desde 2009, los avances en óptica e imágenes digitales han producido cámaras compactas con sensor de 35 mm que se adaptan mejor a la producción 3D nativa. Para The Way of Water, Cameron trabajó con Sony para integrar el sistema de extensión Rialto de la cámara Venice en un Fusion rediseñado. Patrick Campbell, director de tecnología de cámaras 3D de Lightstorm Entertainment, supervisó el reacondicionamiento, reemplazó el acero con titanio y fabricó nuevas piezas de metal y nailon impresas en 3D con refuerzos de fibra de carbono. “Quitamos peso suficiente para agregar una placa de ajuste de altura, cabeceo y balanceo de 1,5 libras, accionada por servomotor, para la cámara vertical, lo que mostró la alineación remota de la cámara, y todavía pudimos reducir el Fusion a 29, 8 libras [en su más ligero]”, dice Campbell.

Las configuraciones de Steadicam y de mano de Carpenter del Fusión usaban dos Rialtos en correas de 20′. El trípode, la grúa, el brazo y la operación subacuática utilizaron dos cuerpos Venice en línea de adelante hacia atrás, con una lente en el cuerpo frontal y un Rialto en la posición vertical superior. La fotografía submarina de gran angular se modificó con una carcasa de espejo abierto y lentes impermeables con montura Nikonos que sobresalían de la carcasa.

“El peso del equipo depende en gran medida de cómo debe usarse para una toma determinada”, señala el productor de sistemas 3D John Brooks, colaborador de Cameron desde hace mucho tiempo. “Cuanto más complejo es un efecto visual, más metadatos se necesitan, por lo que se agregan más equipos al paquete de la cámara. Los lentes Fujinon [MK18-55 mm, MK50-135 mm y Premier ZK Cabrio 19-90 mm] realmente marcaron la diferencia: zooms ligeros con el rango focal adecuado y características de imagen que satisficieron tanto a Jim como a Russell”.

A pesar del éxito mundial de Avatar, la producción nativa en 3D ha tenido problemas para ganar terreno desde su lanzamiento. Cameron atribuye esto a los estándares subjetivos de la industria. “Decidimos optar por un sensor de ⅔ de pulgada porque las lentes que lo cubrirían podrían ser bastante pequeñas [en comparación con los zooms de cine estándar]”, comenta. “Pero muchos cineastas querían filmar con sensores de 35 mm, así que pasas de un zoom Fujinon de 3 libras a un zoom Panavision de 17 libras, multiplicado por dos, y ahora tienes 34 libras solo en el vidrio antes de tener en cuenta el peso de la cámara. No se dio cuenta de que había esta compensación. Si usa una lente de 3 libras, puede tener un sistema de cámara 3D de 30 libras”.

Para Cameron, lo que constituye un «buen 3D» permanece considerablemente sin cambios. “Quieres ser consciente de ese espacio volumétrico entre la lente y la acción. Ahí es donde está la diversión, ¿verdad? Creo que funciona mejor en un nivel subliminal. No quieres demorarte en eso, y no quieres algo constantemente en la cara del espectador”.

Iluminación evocadora

La calidad de la luz en la luna de Pandora fue diseñada para cambiar según la hora del día, con luminancia y color actuaron en direcciones opuestas entre el anochecer y el amanecer. “En términos de color, su paleta de longitudes de onda de luz es muy estrecha al mediodía y se amplía a medida que avanza la tarde”, dice el director James Cameron. “En términos de luminancia, la relación clave-relleno es bastante alta al mediodía y disminuye a medida que se hace más tarde”.

Mientras Pandora orbita alrededor de su planeta principal, hay dos estaciones a cada lado de sus equinoccios durante primavera y otoño cuando el planeta eclipsa al sol una hora al día. “Podemos pasar de una escena diurna a una escena nocturna en dos minutos de narración, que a menudo usamos para lograr un efecto místico o de suspenso”, comenta Cameron.

Otras transiciones de iluminación rápidas se programaron en el escritorio ETC Hog 4-18 durante el rodaje de una escena determinada, o la solución simplemente se convirtió en una cuestión de usar un sólido para bloquear una fuente. «Investigamos mucho sobre el uso de proyectores de luz digital para simular las sombras de los Ikran voladores, las criaturas aladas con forma de dragón sobre las que vuelan los Na’vi», explica Carpenter, citando un ejemplo de esto. “Pudimos obtener estructuras de sombra bastante precisas, pero encontramos que era un proceso algo largo reprogramar la velocidad y el tamaño de estas sombras en el fragor del momento. Sorprendentemente, descubrimos que una solución terriblemente ‘baja-fi’ funcionaba mejor: básicamente, alguien en un ascensor moviendo un recorte de cartón rápidamente frente a una luz podría crear una sombra de Ikran muy satisfactoria y también ser mucho más flexible».

Aunque la mayor parte de Pandora se creó virtualmente, muchos escenarios físicos se construyeron para que los personajes de acción en vivo interactuaran. “Cualquier lugar donde un pie humano toca el suelo era una construcción práctica”, informa el gaffer Dan Riffel.

Rodar esta escena con el actor Jack Champion requirió una construcción de escenario “práctica”.

Bajo el dosel de la jungla de Pandora, la luz del día tiende a ser suave y hacia el lado azul. “Dependiendo de qué tan horrible sea el dosel, obtendrás duros estos parches de luz solar cálida que se abren paso”, dice Carpenter. “Para las sombras del bosque, usamos una variedad de materiales: esquejes de plantas vivas, por supuesto, pero los electricistas muy ingeniosos en realidad creanon ‘sombras del dosel del bosque’ muy realistas, con marcos vacíos de 4’x8′ llenos de una mezcla de materiales encontrados, incluidos palos, diseños de macramé, hojas de plantas y todo lo que parecía encajar. Ningún marco era igual, y funcionaron asombrosamente bien cuando se colocan frente a nuestras fuentes de luz”.

Cameron descubrió que la piel azul se adapta bien a los rellenos verdes, por lo que dondequiera que el sol golpee parches de flora en el suelo de la jungla, una suave luz verde rebota. “Al mantener la mayoría de nuestras luces sobre el escenario y reflejarlas en los elementos del suelo, pudimos hacer modificaciones muy rápidamente usando Vari-Lites”, dice Carpenter. También hizo uso frecuente de grandes sólidos de muselina que se podían subir y bajar desde una armadura para suavizar las fuentes superiores.

Por la noche, la jungla cobra vida con bioluminiscencia, creada en el set con palos de LiteRibbon escondidos en el follaje. Vari-Lite VL2600s y SkyPanel S60-Cs se marcaron con dos tipos de azul: ½ a ¾ CTB para ambiente general y una luz de luna personalizada basada en Lee 181 Congo Blue. Carpenter señala que Lee 181, preferido por una generación anterior de directores de fotografía, “quita de 2½ a 3 paradas de luz, pero obtienes este hermoso azul saturado”.

ESPECIFICACIONES TÉCNICAS

Cámaras 2,39:1, 1,78:1 (3D) |

Lentes Sony Venecia | Fujinon MK, Premier ZK Cabrio