EL MANDALORIAN: ESTE ES EL CAMINO – AMERICAN CINEMATOGRAPHER – Febrero/2020 Jay Holben

Los directores de fotografía Greig Fraser, ASC, ACS y Barry “Baz” Idoine y el showrunner Jon Favreau emplean nuevas tecnologías para enmarcar la serie Disney Plus Star Wars. – Fotografía de la unidad de François Duhamel, SMPSP y Melinda Sue Gordon, SMPSP, cortesía de Lucasfilm, Ltd.

Para que The Mandalorian funcionara, la tecnología tenía que avanzar lo suficiente como para que los mundos épicos de Star Wars pudieran ser representados a una escala asequible por un equipo cuya huella de producción real comprendería algunos escenarios de sonido y un pequeño backlot. Una consideración adicional fue que el flujo de trabajo típico de efectos visuales se ejecuta simultáneamente con la producción y luego se extiende por un período de publicación prolongado. Incluso con todo el poder de las técnicas de efectos visuales digitales contemporáneos y miles de millones de cálculos por segundo, el proceso puede tardar hasta 12 horas o más por cuadro. Con miles de tomas y múltiples iteraciones, esto se convierte en un esfuerzo que requiere mucho tiempo. El Santo Grial de los efectos visuales, y una necesidad para The Mandalorian, según el co-director de fotografía y coproductor Greig Fraser, ASC, ACS, fue la capacidad de hacer composición en la cámara en tiempo real en el set.

“Ese era nuestro objetivo”, dice Fraser, quien previamente había explorado la galaxia de Star Wars mientras filmaba Rogue One: A Star Wars Story ( AC Feb. ’17). “Queríamos crear un entorno propicio no solo para dar una alineación de composición a los efectos, sino para capturarlos en tiempo real, foto-real y en la cámara, de modo que los actores estuvieran en ese entorno en la iluminación adecuada, todo en el momento de la fotografía».

Durante décadas, la composición de pantalla verde y azul fue la solución ideal para reunir en la pantalla entornos y actores fantásticos. (Luz industrial y magiahizo un trabajo pionero con la tecnología para la película original de Star Wars). Sin embargo, cuando los personajes visten trajes muy reflectantes, como es el caso de Mando (Pedro Pascal), el personaje principal de El Mandaloriano, el reflejo de la pantalla verde y azul en el vestuario provoca costosos problemas en la postproducción. Además, es un desafío para los actores actuar en un “mar de azul” y para los creativos claves participar en los diseños y la composición de las tomas.

La solución fue lo que podría describirse como el heredero de la retroproyección: un fondo foto-real dinámico, en tiempo real, reproducido en un techo y una pared de video LED masivos, que no solo proporciona la representación precisa de píxeles de contenido de fondo exótico, pero también se renderizó con los datos de posición de la cámara correctos.

Mando con el Niño en su barco

Si el contenido se creó antes de la filmación, fotografiar a los actores, la utilería y los decorados frente a esta pared podría crear efectos visuales finales en la cámara, o «casi» finales, con solo correcciones técnicas necesarias y con total confianza creativa. en la composición y apariencia de las tomas. En The Mandalorian, este espacio se denominó «el volumen». (Técnicamente, un «volumen» es cualquier espacio definido por la tecnología de captura de movimiento).

Este concepto fue propuesto inicialmente por Kim Libreri de Epic Games mientras estaba en Lucasfilm y se ha convertido en la base de la tecnología de ese “Santo Grial” que hace posible una serie de televisión de Star Wars de acción en vivo.

En 2014, mientras Rogue One avanzaba, se discutió una vez más el concepto de composición en tiempo real. La tecnología había madurado a un nuevo nivel. El supervisor de efectos visuales John Knoll tuvo una discusión inicial con Fraser sobre este concepto y el director de fotografía mencionó la idea de utilizar una gran pantalla LED como instrumento de iluminación para incorporar iluminación animada interactiva en los actores y escenarios durante la fotografía compuesta utilizando la reproducción de efectos preliminares aproximados. en las pantallas LED. El VFX animado final se agregaría más tarde; las pantallas eran simplemente para proporcionar iluminación interactiva a juego con las animaciones.

«Uno de los grandes problemas de la fotografía compuesta con pantalla azul y verde es la iluminación interactiva», comenta Fraser. “A menudo, estás filmando elementos de fotografía reales antes de que se creen los fondos y estás imaginando lo que hará la iluminación interactiva, y luego tienes que esperar que lo que has hecho en el set coincida con lo que sucede en la publicación mucho más tarde. Si el director cambia los fondos en la publicación, entonces la iluminación no coincidirá y la toma final se sentirá falsa».

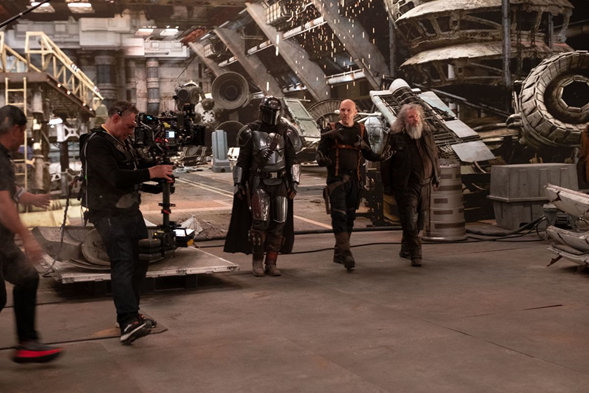

El director y productor ejecutivo Dave Filoni y los directores de fotografía Greig Fraser, ASC, ACS (centro) y Barry “Baz” Idoine (cámara operativa) en el set.

Para Rogue One, construyeron una gran pantalla LED cilíndrica y crearon todos los fondos de antemano para los aterrizajes de batalla espacial en Scarif, Jedha y Eadu y todas las secuencias de cabina en las naves espaciales X-Wing y U-Wing se hicieron frente a eso. Pared LED como fuente principal de iluminación de los personajes y escenarios. Esos paneles LED tenían un paso de píxeles de 9 mm (la distancia entre los centros de los grupos de píxeles RGB en la pantalla). Desafortunadamente, con el tamaño del paso de píxeles, rara vez podían alejarlo lo suficiente de la cámara para evitar el efecto muaré y hacer que la imagen pareciera fotorrealista, por lo que se utilizó únicamente con fines de iluminación. Sin embargo, debido a que los fondos de reemplazo ya se construyeron y utilizaron en el set, las composiciones fueron extremadamente exitosas y coincidieron perfectamente con la iluminación dinámica.

En 2016, la presidenta de Lucasfilm, Kathleen Kennedy, se acercó al guionista y director Jon Favreau sobre un proyecto potencial.

Una vista de ojo de pez que mira a través del espacio entre las dos paredes traseras del sistema de pared LED del espectáculo, conocido como «el volumen». El punto oscuro en el techo del volumen se debe a un modelo diferente de pantallas LED que se utilizan allí. El techo se usa principalmente para fines de iluminación y, si se ve en la cámara, se reemplaza en la copa final.

“Fui a ver a Jon y le pregunté si nos gustaría hacer algo para el nuevo servicio de transmisión de Disney”, dice Kennedy. “Sabía que Jon había querido hacer un proyecto de Star Wars durante mucho tiempo, así que comenzamos a hablar de inmediato sobre lo que podría hacer para impulsar la tecnología y eso llevó a una conversación completa sobre lo que podría cambiar la ruta de producción; ¿Qué podría realmente crear una forma en la que pudiéramos hacer las cosas de manera diferente?».

Favreau acababa de completar El libro de la selva y se estaba embarcando en El rey león para Disney, ambas películas con efectos visuales pesados.

El supervisor de efectos visuales Richard Bluff y el director creativo ejecutivo y director de ILM Rob Bredow le mostraron a Favreau una serie de pruebas que ILM había realizado, incluida la tecnología de la pared LED de Rogue One. Fraser sugirió con los avances en la tecnología LED desde Rogue One que este proyecto podría aprovechar nuevos paneles y ampliar los efectos visuales en la cámara en tiempo real. A Favreau le encantó el concepto y decidió que ese era el camino de producción a seguir.

En el fondo, que parecen flotar en el espacio, están las cámaras de seguimiento de movimiento que se asoman entre la pared y el techo del Volume

La producción buscaba minimizar la cantidad de fotografías en pantalla verde y azul y los requisitos de composición posterior para mejorar la calidad del entorno para los actores. La pantalla LED proporciona un facsímil convincente de un escenario/ubicación real y evita el vacío verde que puede ser un desafío para los artistas.

“Me animaron mucho mis experiencias con el uso de tecnología similar en El libro de la selva (AC , mayo del ’16) y el uso de cámaras virtuales en El Rey León (C , agosto del ’19)”, explica Favreau, creador de la serie y productor ejecutivo. “También había experimentado con un video wall parcial para el episodio piloto de The Orville . Con el equipo que habíamos formado entre nuestro equipo, ILM, Magnopus , Epic Games, Profile Studios y Lux Machina , sentí que teníamos muy buenas posibilidades de obtener un resultado positivo».

“El Volumen es una tecnología difícil de entender hasta que uno se para frente a la ‘proyección’ en la pantalla LED, coloca a un actor frente a ella y mueve la cámara”, dice Fraser. “Es difícil de entender. No es realmente una retroproyección; no es una TransLite porque (es una imagen interactiva en tiempo real con objetos 3D) y tiene el paralaje adecuado; y es fotorrealista, no animado, pero se genera a través de un motor de juegos».

Idoine (izquierda) filmando en la pantalla del Volume del planeta helado Maldo Kreis, una de las muchas «cargas» del entorno de producción, con el director Filoni mirando y Karina Silva operando la cámara B.

Los dispositivos con pelotas blancas, de media cúpula, estilo ping-pong en cada cámara son los «Sputniks»: configuraciones de marcadores infrarrojos que son vistas por las cámaras de seguimiento de movimiento para registrar la posición de la cámara de producción en el espacio 3D y para render paralaje 3D adecuado en la pared de volumen.

“La tecnología que pudimos innovar en The Mandalorian no habría sido posible si no hubiéramos desarrollado tecnologías en torno a los desafíos de Jungle Book y Lion King”, ofrece Favreau. «Habíamos utilizado el motor de juego y la tecnología de captura de movimiento y la extensión del set en tiempo real que tenía que renderizarse después del hecho, por lo que el renderizado en tiempo real era una extensión natural de este enfoque».

Barry «Baz» Idoine, quien trabajó con Fraser durante varios años como operador de cámara y director de fotografía de la segunda unidad en películas como Rogue One y Vice (AC Jan. ’19), asumió las funciones de cinematografía en The Mandalorian cuando Fraser se alejó para filmar Duna de Denis Villeneuve.

Idoine observa: “El fuerte valor inicial es que no estás filmando en un mundo de pantalla verde y tratando de emular la luz que se utilizará más adelante; en realidad estás filmando tomas de producto terminado. Devuelve el control de la cinematografía al director de fotografía».

El volumen era una pared de video LED curvada de 20 ‘de alto por 180’ de circunferencia, que comprendía 1.326 pantallas LED individuales de un paso de píxeles de 2,84 mm que creaban un fondo semicircular de 270 grados con un espacio de actuación de 75 ‘de diámetro rematado con un techo de video LED, que se colocó directamente en la curva principal de la pared LED.

En la parte trasera del Volumen, en los 90 grados restantes del área abierta, esencialmente «detrás de la cámara», había dos paneles planos de 18 ‘de alto por 20’ de ancho de 132 pantallas LED más. Estos dos paneles se instalaron en la vía del viajero y en los motores de cadena en los pernos del escenario, por lo que las paredes podrían moverse a su lugar o sacarse del camino para permitir un mejor acceso al área de Volumen.

“El Volumen nos permite traer muchos entornos diferentes bajo un mismo techo”, dice el supervisor de efectos visuales Richard Bluff de ILM. “Podríamos estar filmando en las llanuras de lava de Nevarro por la mañana y en los desiertos de Tatooine por la tarde. Por supuesto, hay consideraciones prácticas para cambiar de entorno, pero [normalmente, hicimos] dos entornos en un día».

La tripulación rodea la nave espacial Razor Crest del Mandalorian. Solo el fuselaje y la cabina son piezas prácticas. Desde esta posición de cámara fija, la composición parece «rota», pero desde la perspectiva de la cámara de producción, los motores aparecen en perfecta relación con el fuselaje y siguen en paralaje con el movimiento de la cámara.

“La mayoría de las tomas se hicieron completamente a puerta cerrada”, agrega Favreau. “Y en los casos en los que no llegamos al píxel final, el proceso de posproducción se acortó significativamente porque ya habíamos tomado decisiones creativas basadas en lo que habíamos visto frente a nosotros. La postproducción consistió principalmente en refinar las opciones creativas que no pudimos finalizar en el set de una manera que consideráramos fotorrealista».

Con la retroproyección tradicional (y la proyección frontal), para que el resultado parezca creíble, la cámara debe permanecer estacionaria o moverse a lo largo de una ruta preprogramada para que coincida con la perspectiva de la imagen proyectada. En cualquier caso, el centro de perspectiva de la cámara (la pupila de entrada de la lente, a veces denominada, aunque incorrectamente, como el punto nodal) debe alinearse con precisión con el sistema de proyección para lograr la perspectiva adecuada y los efectos de paralaje. The Mandalorian no es la primera producción que incorpora un sistema de proyección de imágenes para la composición en la cámara, pero lo que distingue su técnica es su capacidad para facilitar una cámara en movimiento.

En el episodio piloto, el Mandaloriano (Pedro Pascal) pone a su presa (Horatio Sanz) bajo custodia.

De hecho, usar una cámara fija o una bloqueada en un movimiento preestablecido para todo el trabajo en el Volumen simplemente no era aceptable para las necesidades de esta producción en particular. Por lo tanto, el equipo tuvo que encontrar una manera de rastrear la posición y el movimiento de la cámara en el espacio del mundo real, y extrapolar la perspectiva y el paralaje adecuados en la pantalla a medida que la cámara se movía. Esto requirió incorporar tecnología de captura de movimiento y un motor de videojuego, Unreal Engine de Epic Games, que generaría una perspectiva de paralaje 3D adecuada en tiempo real.

Las ubicaciones representadas en la pared de LED fueron inicialmente modeladas de forma aproximada por artistas de efectos visuales que crearon modelos 3D en Maya, según las especificaciones determinadas por el diseñador de producción Andrew Jones y el consultor visual Doug Chiang. Luego, siempre que sea posible, un equipo de fotogrametría se dirigirá a una ubicación real y creará un escaneo fotográfico en 3D.

“Nos dimos cuenta desde el principio de que la mejor manera de obtener contenido fotográfico real en la pantalla era fotografiar algo”, afirma el supervisor de efectos visuales Richard Bluff.

A pesar de lo asombrosas y avanzadas que eran las capacidades de Unreal Engine, renderizar polígonos completamente virtuales sobre la marcha no produjo el resultado fotográfico real que exigían los realizadores. En resumen, los escenarios y entornos renderizados por computadora en 3-D no eran lo suficientemente fotorrealistas como para ser utilizados como imágenes finales en la cámara. La mejor técnica fue crear los decorados virtualmente, pero luego incorporar fotografías de objetos, texturas y ubicaciones del mundo real y mapear esas imágenes en los objetos virtuales 3-D. Esta técnica se conoce comúnmente como mosaico o fotogrametría. Esta no es necesariamente una técnica nueva o única, pero la incorporación de elementos de fotogrametría logró el objetivo de crear finales en la cámara.

The Mandolorian hace reparaciones con un rico paisaje que se muestra detrás de él

Además, el “escaneo” fotográfico de una ubicación, que incorpora la toma de miles de fotografías desde muchos puntos de vista diferentes para generar un modelo fotográfico en 3-D, es un componente clave en la creación de entornos virtuales.

Enrico Damm se convirtió en el supervisor de medio ambiente de la producción y dirigió el equipo de escaneo y fotogrametría que viajaría a lugares como Islandia y Utah para filmar elementos para los planetas de Star Wars.

La condición climática perfecta para estas capturas fotográficas es un día muy nublado, ya que hay poca o ninguna sombra en el paisaje. Una situación con luz solar intensa y sombras duras significa que no se puede volver a iluminar fácilmente en el mundo virtual. En esos casos, se utilizó software como Agisoft De-Lighter para analizar las fotografías en busca de iluminación y eliminar sombras para dar como resultado un lienzo más neutral para la iluminación virtual.

El escaneo es un proceso más rápido y flexible que la fotogrametría y se realiza desde múltiples posiciones y puntos de vista. Para el escaneo, cuanta más paralaje se introduzca, mejor podrá resolver el software la geometría 3D. Damm creó una plataforma personalizada en la que el escáner sujeta seis cámaras a su cuerpo y todas disparan simultáneamente mientras el escáner se mueve por la ubicación. Esto les permite recopilar seis veces las imágenes en la misma cantidad de tiempo, alrededor de 1.800 en promedio.

La fotogrametría se utiliza para crear fondos virtuales y las imágenes deben tomarse en una plataforma nodal para eliminar el paralaje entre las fotos. Para Mandalorian, alrededor del 30-40% de los fondos del volumen se crearon a través de fondos virtuales: imágenes de fotogrametría.

Cada fase de la fotografía (fotogrametría y escaneo) debe realizarse en varios momentos durante el día para capturar diferentes miradas del paisaje.

A veces también se emplean sistemas de escaneo Lidar.

Las cámaras utilizadas para escanear fueron Canon EOS 5D MKIV y EOS 5DS con lentes de focal fija. A veces se incorporan zooms a medida que el software de costura moderno ha mejorado para resolver múltiples imágenes desde diferentes distancias focales.

El Mandaloriano (también conocido como «Mando», interpretado por Pedro Pascal) camina solo por el desierto

Esta información se mapeó en escenarios virtuales 3D y luego se modificó o embelleció según fuera necesario para adherirse a la estética del diseño de Star Wars. Si no había una ubicación del mundo real para fotografiar, los entornos fueron creados completamente por el equipo de efectos visuales de “entornos” de ILM. Los elementos de las ubicaciones se cargaron en la plataforma de videojuegos Unreal Engine, que proporcionó un entorno 3D en vivo y en tiempo real que podía reaccionar a la posición de la cámara.

La tercera toma del primer episodio de la temporada 1 demuestra esta tecnología con una efectividad extrema. El disparo comienza con un ángulo bajo de Mando leyendo un sensor en el planeta helado de Maldo Kreis; se encuentra en un largo camino que se extiende hasta una serie de estructuras en el horizonte. Los cielos están llenos de nubes oscuras y una nieve ligera se arremolina alrededor. Mando camina por el sendero hacia las estructuras y la cámara se dispara.

Todo esto fue capturado en el Volumen, en la cámara y en tiempo real. Parte de la pasarela era un escenario real y práctico, pero el resto del mundo era la imagen virtual en la pantalla LED, y el paralaje cuando la cámara se disparaba encajaba perfectamente con el escenario real. El efecto de este sistema es perfecto.

Debido a la enorme cantidad de potencia de procesamiento necesaria para crear este tipo de imágenes, la pantalla completa de 180 ‘y el techo no se pudieron renderizar en alta resolución, como fotos reales en tiempo real. El compromiso fue ingresar la lente específica utilizada en la cámara en el sistema, de modo que mostrara una imagen real de alta resolución basada en el campo de visión específico de la cámara en ese momento dado, mientras que el resto de la pantalla mostraba una imagen de menor resolución que todavía era eficaz para la iluminación interactiva y los reflejos sobre el talento, la utilería y los decorados físicos. (El recuento de polígonos más simple facilitó tiempos de renderización más rápidos).

Idoine (extremo izquierdo) analiza una toma de «The Child» (también conocido como «Baby Yoda») con el director Rick Famuyiwa (tercero desde la izquierda) y el creador / productor ejecutivo de la serie Jon Favreau (tercero desde la derecha), mientras que el director asistente Kim Richards (segundo desde la derecha, de pie) y los miembros del equipo escuchan.

El diseño práctico del escenario se usó a menudo frente a la pantalla LED y fue diseñado para cerrar visualmente la brecha entre el espacio real y virtual. Los prácticos decorados se colocaban con frecuencia en contrahuellas para levantar el suelo y ocultar mejor la unión de la pared LED y el suelo del escenario.

Cada carga de volumen se colocó en la plataforma de videojuegos Unreal Engine, que proporcionó el entorno 3D en vivo y en tiempo real que reaccionó a la posición de la cámara de producción, que fue rastreada por el sistema de captura de movimiento de Profile Studios a través de cámaras infrarrojas (IR) circundantes. la parte superior de las paredes LED que monitoreaban los marcadores IR montados en la cámara de producción. Cuando el sistema reconoció la posición X, Y, Z de la cámara, procesó el paralaje 3D adecuado para la posición de la cámara en tiempo real. Eso se introdujo desde Profile en el software StageCraft patentado de ILM, que gestionó y registró la información y el flujo de trabajo de producción completo a medida que, a su vez, introducía las imágenes en Unreal Engine. Luego, las imágenes se enviaron a las pantallas con la ayuda del equipo de Lux Machina.

Se necesitan 11 computadoras interconectadas para enviar las imágenes a la pared. Tres procesadores están dedicados a la renderización en tiempo real y cuatro servidores proporcionan tres imágenes 4K una al lado de la otra en la pared y una imagen 4K en el techo. Eso ofrece un tamaño de imagen de 12.288 píxeles de ancho por 2.160 de alto en la pared y 4.096 x 2.160 en el techo. Sin embargo, con ese tipo de imágenes, los 270 grados completos (más las paredes LED traseras móviles) y el techo no se pueden convertir en fotos reales de alta resolución en tiempo real. El compromiso es ingresar la lente específica utilizada en la cámara en el sistema para que muestre una imagen de alta resolución fotorrealista solo para el campo de visión específico de la cámara en ese momento dado, mientras que el resto de la pantalla muestra una imagen más baja. imagen de resolución que es perfectamente efectiva para la iluminación interactiva y los reflejos sobre el talento, la utilería y los decorados físicos, pero de un conteo de polígonos más simple para tiempos de renderizado más rápidos.

Mando se encuentra en un cañón del planeta Arvala. Las rocas detrás de él están en la pared LED, mientras que algunas rocas prácticas se colocan en el medio y el primer plano para mezclar la transición. El piso del escenario está cubierto de barro y rocas para esta ubicación. En el brazo hay un Arri Alexa LF con una lente anamórfica Panavision Ultra Vista

Debido a los 10-12 fotogramas (aproximadamente medio segundo) de latencia desde el momento en que el sistema de Profile recibió la información de la posición de la cámara hasta la representación de Unreal de la nueva posición en la pared LED, si la cámara se movía por delante del tronco renderizado (un término que define el campo de visión virtual de la cámara) en la pantalla, la línea de transición entre la ventana de renderizado en perspectiva de alta calidad y el render principal de baja calidad sería visible. Para evitar esto, el tronco se proyectó un promedio de un 40 por ciento más grande que el campo de visión real de la combinación de cámara / lente, para permitir cierto margen de seguridad para los movimientos de la cámara. En algunos casos, si el campo de visión de la lente – y por lo tanto el tronco – era demasiado amplio, el sistema no podía generar una imagen con suficiente alta resolución en tiempo real; la producción usaría la imagen en la pantalla LED simplemente como iluminación, y componga la imagen en la publicación [con una pantalla verde agregada detrás de los actores]. En esos casos, los fondos ya estaban creados y la combinación fue perfecta porque esos fondos reales se habían utilizado en el momento de la fotografía [para iluminar la escena].

Afortunadamente, dice Fraser, Favreau quería que The Mandalorian tuviera una estética visual que coincidiera con la de Star Wars original. Esto significó una cámara más «conectada a tierra», con panorámicas e inclinaciones lentas, y movimientos de cámara no agresivos, una estética que ayudó a ocultar la latencia del sistema. “Además de usar parte del lenguaje original de la cámara en Star Wars, Jon está profundamente inspirado por los viejos westerns y las películas de samuráis, por lo que también quiso tomar prestado un poco de ellos, especialmente los westerns”, señala Fraser. “El mandaloriano es, en esencia, un pistolero, y es muy metódico. Esto nos dio un conjunto de parámetros que ayudaron a definir el aspecto del programa. En ningún momento verá una lente ojo de pez de 8 mm en la cara de alguien. Eso simplemente no funciona en este idioma.

“También fue de suma importancia para mí que el resultado de esta tecnología no solo sea ‘adecuado para televisión’, sino que coincida con el de las principales películas de alta gama”, continúa Fraser. “Tuvimos que empujar la stuacion hasta el punto en que nadie supiera realmente que estábamos usando nueva tecnología; simplemente lo aceptarían como está. Sorprendentemente, pudimos hacer precisamente eso».

El operador de Steadicam Simon Jayes rastrea a Mando, Mayfeld (Bill Burr) y Ran Malk (Mark Boone Jr.) frente a la pared LED. Si bien la camara de 10 a 12 cuadros de renderizar el «frustum» de alta resolución en la pared puede ser problemática. Steadicam se empleó generosamente en el Episodio 6 con gran éxito.

Filmado con Alexa LF de Arri , The Mandalorian fue el viaje inaugural de los lentes anamórficos de fotograma completo Ultra Vista 1.65x de Panavision. La compresión anamórfica de 1,65x permitió la utilización completa de la relación de aspecto de 1,44: 1 del LF para crear una relación de aspecto nativa de 2,37: 1, que solo se recortó ligeramente a 2,39: 1 para la exhibición.

“Elegimos el LF por un par de razones”, explica Fraser. “Star Wars tiene una larga historia de fotografía anamórfica, y esa relación de aspecto es realmente clave. Probamos lentes esféricas y recortamos a 2,40, pero no nos pareció bien. Se sintió muy contemporáneo, no como Star Wars crecimos con. Además, el sensor más grande del LF cambia la distancia focal de la lente que usamos para cualquier toma a una lente más larga y reduce la profundidad de campo general. El T2.3 de Ultra Vistas se parece más a un T0.8 en Super 35, por lo que, con menos profundidad de campo, fue más fácil desenfocar la pantalla LED más rápido, lo que evitó muchos problemas con el moiré. Permite que los problemas inherentes a una pantalla 2D que muestra imágenes 3D se enfoquen mucho más rápido, por lo que el ojo no puede decir que esos edificios que parecen estar a 1,000 pies de distancia en realidad se están proyectando en una pantalla 2D a solo 20 pies de distancia. el actor.

Fraser opera un Alexa LF, filmando un primer plano del Ugnaught Kuiil (Misty Rosas en el traje, con la voz de Nick Nolte). La transición entre la parte inferior de la pared LED y el suelo del escenario se ve claramente aquí. Esa área a menudo se ocultaba por el diseño de la producción física o se reemplazaba en la edición.

“Las Ultra Vistas fueron una gran elección para nosotros porque tienen una buena cantidad de carácter y suavidad”, continúa Fraser. “Fotografiar el casco cromado en Mando es un desafío: sus bordes súper nítidos pueden verse rápidamente como un video si la lente es demasiado nítida. Tener una agudeza más suave en la lente, que [el vicepresidente senior de ingeniería óptica de Panavision y asociado de ASC] Dan Sasaki [modificó] para nosotros, realmente ayudó. La lente que usamos para Mando tendía a ser un poco demasiado blanda para rostros humanos, por lo que usualmente disparamos a Mando completamente abierta, compensando eso con filtros ND, y fotografiamos a personas 2⁄3 de paso o 1 paso cerrado».

Según Idoine, la producción utilizó Ultra Vistas de 50 mm, 65 mm, 75 mm, 100 mm, 135 mm, 150 mm y 180 mm que van desde T2 a T2.8, y él y Fraser tendían a exponer en T2.5-T3.5. “Dan Sasaki nos dio dos prototipos de Ultra Vistas para probar en junio de 2018”, dice, “y a partir de eso calculamos qué rango de distancia focal construir.

El director Bryce Dallas Howard conversa con la actriz Gina Carano, como la mercenaria Cara Dune, mientras filma el episodio «Capítulo 4: Santuario.

«Nuestro deseo de imágenes cinematográficas impulsó todas las opciones», agrega Idoine. Y eso incluyó la incorporación de una LUT que emula el negativo en color 500T 5230 de corta duración de Kodak, uno de los favoritos de Fraser. «Usé esa acción en Killing Them Softly [AC Oct. ’12] y Foxcatcher [AC Dec. ’14], y me encantaron sus sombras cremosas y el ligero matiz magenta en las luces», dice Fraser. «Para Rogue One, ILM pudo desarrollar una LUT que la emulaba, y he estado usando esa LUT desde entonces».

“Foxcatcher fue la última película que filmé en stock y luego Kodak la descontinuó”, continúa Fraser. “En ese momento, nos sobraron algunas existencias y le pregunté a la producción si podíamos donarlas a un estudiante de cine australiano y dijeron ‘sí’, así que enviamos varias cajas a Australia. Cuando estaba preparando Rogue One, decidí que ese era el aspecto que quería, esta acción 5230, pero ya no estaba. En una perspectiva remota, le escribí un correo electrónico al estudiante de cine para ver si le quedaba algo de stock y, increíblemente, tenía 50 pies en el fondo de su refrigerador. Le pedí que enviara eso directamente a ILM y ellos crearon una LUT que usé en Rogue y ahora en Mandaloria«.

El actor Giancarlo Esposito como Moff Gideon, un imperial en busca del Niño.

Una clave importante para el éxito del Volume en la creación de efectos visuales finales en la cámara es la combinación de colores de la salida LED de la pared con la matriz de colores de la cámara Arri Alexa LF. Matthias Scharfenberg, J. Schulte y su equipo de ILM realizaron pruebas exhaustivas de las capacidades del LED Black Roe y lo combinaron con la sensibilidad del color y la reproducción del LF para convertirlos en socios perfectos. Los LED son emisores de espectro de color de banda muy estrecha, sus diodos rojo, verde y azul emiten espectros de color muy estrechos para cada diodo, lo que hace que alcanzar algunos colores sea muy difícil y, además, hacerlos compatibles con la matriz de filtros de color del ALEV-III fue un poco de un desafío. Utilizando una serie de parches de color cuidadosamente diseñados, se ejecutó una secuencia de calibración en la pared de LED para sincronizar con la sensibilidad de la cámara. Esto significa que cualquier otro modelo de cámara que filme en el Volumen no recibirá el color adecuado, pero Alexa LF sí. Si bien es posible que la reproducción del color de los LED no se haya visto directamente a la vista, a través de la cámara parecía perfecta. Esto significa que los paneles LED listos para usar no funcionarán con la precisión necesaria para una producción de alta gama, pero, con ajustes personalizados, tuvieron éxito. Sin embargo, hubo limitaciones. Con fondos con poca luz, las pantallas se bloquean y se alias en las sombras, lo que las hace inadecuadas para las finales en cámara, aunque con un mayor desarrollo de la ciencia del color, esto se ha resuelto para la segunda temporada. Esto significa que los paneles LED listos para usar no funcionarán con la precisión necesaria para una producción de alta gama, pero, con ajustes personalizados, tuvieron éxito. Sin embargo, hubo limitaciones. Con fondos con poca luz, las pantallas se bloquean y se alias en las sombras, lo que las hace inadecuadas para las finales en cámara, aunque con un mayor desarrollo de la ciencia del color, esto se ha resuelto para la segunda temporada. Esto significa que los paneles LED listos para usar no funcionarán con la precisión necesaria para una producción de alta gama, pero, con ajustes personalizados, tuvieron éxito. Sin embargo, hubo limitaciones. Con fondos con poca luz, las pantallas se bloquean y se alias en las sombras, lo que las hace inadecuadas para las finales en cámara, aunque con un mayor desarrollo de la ciencia del color, esto se ha resuelto para la segunda temporada.

Un activo importante para la pared LED Volume y las imágenes proyectadas desde ella es la iluminación interactiva que se proporciona a los actores, decorados y accesorios dentro del Volume. La luz que se proyecta de las imágenes en la pared LED proporciona una sensación realista de que el actor (o el escenario / accesorios) se encuentra dentro de ese entorno de una manera que rara vez se puede lograr con la fotografía compuesta con pantalla verde o azul. Si el sol está bajo en el horizonte en la pared LED, la posición del sol en la pared será significativamente más brillante que el cielo circundante. Este punto más brillante creará una iluminación brillante en los actores y objetos en el Volumen tal como lo haría un sol real desde esa posición. Los reflejos de elementos del entorno de las paredes y el techo aparecen en el disfraz de Mando como si realmente estuviera en esa ubicación del mundo real.

“Cuando se trata de un sujeto reflectante como Mando, el mundo fuera del marco de la cámara suele ser más importante que el mundo que se ve en el campo de visión de la cámara”, dice Fraser. “Lo que hay detrás de la cámara se refleja en el casco y el vestuario del actor, y eso es crucial para vender la ilusión de que está en ese entorno. Incluso si solo estuviéramos filmando en una dirección en un lugar en particular, el departamento de arte virtual tendría que construir un escenario de 360 grados para que pudiéramos obtener la iluminación interactiva y los reflejos correctos”.

Esto también fue cierto para los decorados prácticos que se construyeron en el escenario y en el backlot: tuvimos que construir las áreas que nunca veríamos en la cámara porque se reflejarían en el traje. En el volumen, es este mundo fuera de la cámara el que define la iluminación.

“Cuando lo piensas, a menos que sea una luz práctica en la toma, toda nuestra iluminación está fuera del encuadre, así es como hacemos películas”, continúa Fraser. “Pero cuando la mayor parte de su iluminación proviene del entorno, debe moldear ese entorno con cuidado. A veces tenemos que agregar un elemento práctico o una ventana al diseño, que proporciona nuestra luz clave, aunque nunca veamos ese [elemento] en la cámara».

La pelea con el mudhorn probablemente anuló cualquier preocupación por los reflejos del casco para esta escena.

La iluminación interactiva del Volume también reduce significativamente la necesidad de equipos y personal de iluminación de producción de películas tradicionales. La luz emitida por las pantallas LED se convierte en la iluminación principal de los actores, decorados y accesorios dentro del Volumen. Dado que esta luz proviene de una imagen virtual del escenario o ubicación, la naturaleza orgánica de la calidad de la luz en los elementos dentro del Volumen cimenta firmemente esos elementos en la realidad presentada.

Por supuesto, había limitaciones. Aunque los LED son brillantes y capaces de emitir una gran cantidad de luz, no pueden recrear la intensidad y la calidad de la luz natural directa. “El sol en la pantalla LED se ve perfecto porque ha sido fotografiado, pero no se ve bien en los sujetos, parece que están en un estudio”, atestigua Fraser. “Es viable para primeros planos, pero no realmente para tomas amplias. Para los momentos con luz solar directa y real, nos dirigimos a la parte trasera tanto como fue posible «. Ese «backlot» era un campo abierto cerca de los escenarios de Manhattan Beach Studios , donde el departamento de arte construyó varios decorados. (También se utilizaron varias etapas para crear decorados tradicionales).

Los cielos nublados, sin embargo, resultaron ser una gran fuente en el Volumen. Los cielos para cada «carga», el término dado para cada nuevo entorno cargado en las paredes LED, se basaron en cielos reales fotografiados. Mientras filmaba una ubicación, el equipo de fotogrametría tomó varias imágenes fijas en diferentes momentos del día para crear «domos del cielo». Esto permitió al director y al director de fotografía elegir la posición del sol y la calidad del cielo para cada set. “Podemos crear un ambiente perfecto donde tienes dos minutos para la puesta de sol congelada en el tiempo durante un día completo de 10 horas”, señala Idoine. «Si tenemos que dar un giro, simplemente rotamos el cielo y el fondo, ¡y estamos listos para disparar!».

Idoine (sentada a la cámara) conversando con Favreau y Filoni en un set práctico.

Durante la preparación, Fraser e Idoine pasaron mucho tiempo en el departamento de arte virtual, cuyo equipo creó los fondos virtuales para las cargas de LED. Pasaron muchas horas revisando cada carga para establecer opciones de domo y elegir la hora perfecta del día y la posición del sol para cada momento. Podían seleccionar la condición del cielo que deseaban, ajustar la escala y la orientación, y perfeccionar todos estos atributos para encontrar la mejor iluminación para la escena. El trazado de rayos básico en tiempo real les ayudó a ver los efectos de sus elecciones en los actores virtuales en la escena de previsualización. Estas opciones luego se guardarían y enviarían a ILM, cuyos artistas usarían estos activos más toscos como referencia y construirían los activos digitales de alta resolución.

El Departamento de Arte Virtual comienza su trabajo creando decorados virtuales en 3-D de cada ubicación según las especificaciones del diseñador de producción Andrew Jones y luego el director y el director de fotografía pueden ir a la ubicación virtual con cascos de realidad virtual y hacer una exploración virtual. Se agregan actores digitales, utilería y decorados que se pueden mover y se elige la cobertura durante la exploración virtual. Luego, el director de fotografía seguirá el proceso a medida que el escenario virtual se texturiza aún más con elementos de fotogrametría y se agregan las cúpulas del cielo.

El mundo virtual en la pantalla LED es fantástico para muchos usos, pero obviamente un actor no puede caminar a través de la pantalla, por lo que una puerta abierta no funciona cuando es virtual. Las puertas son un aspecto del diseño de producción que debe ser físico. Si un personaje entra por una puerta, no puede ser virtual, debe ser real ya que el actor no puede atravesar la pantalla LED.

Favreau obtiene su entrada de salón de estilo occidental desde el primer episodio de The Mandalorian.

Si un actor está cerca de una pieza determinada, es más a menudo preferible que la pieza sea física en lugar de virtual. Si están cerca de una pared, debe ser una pared física para que estén realmente cerca de algo real.

Muchos objetos físicos también son virtuales. Incluso si una pieza de utilería o escenografía se construye físicamente, se escanea e incorpora al mundo virtual para que se convierta no solo en un activo práctico, sino también en uno digital. Una vez que está en el mundo virtual, se puede activar o desactivar en un conjunto en particular o duplicarlo.

“Tomamos objetos que el departamento de arte ha creado y empleamos fotogrametría en cada artículo para incluirlos en el motor del juego”, explica Clint Spillers, supervisor de producción virtual. «También conservamos lo que escaneamos y lo colocamos frente a la pantalla y hemos tenido un éxito notable al lograr que el activo en primer plano y el objeto digital convivan de manera muy cómoda».

Otro desafío en el diseño de producción es el concepto de que cada conjunto debe ejecutarse en 360 grados completos. Mientras que en el cine tradicional, un diseñador de producción puede tener la tentación de atajar un diseño sabiendo que la cámara solo verá una pequeña parte de un set en particular, en este mundo el set que está fuera de cámara es tan importante como el set que se ve en la cámara.

“Esta fue una gran revelación para nosotros desde el principio”, atestigua el diseñador de producción Andrew Jones. “Inicialmente, estábamos pensando en esta tecnología como un telón de fondo, como un trasluz avanzado o un telón de fondo pintado, contra el que dispararíamos y esperaríamos obtener efectos finales en la cámara. Imaginamos que diseñaríamos nuestros decorados como lo harías en una película normal: es decir, la cámara ve aquí, así que esto es lo que tenemos que construir. En las primeras conversaciones con el director de fotografía Greig Fraser, explicó que la parte del set fuera de cámara, que tal vez nunca se vea en la cámara, era tan vital para el efecto. Todo el volumen es una caja de luz y lo que hay detrás de la cámara se refleja en las caras, el vestuario y la utilería del actor. Lo que hay detrás de la cámara es en realidad la iluminación clave del talento.

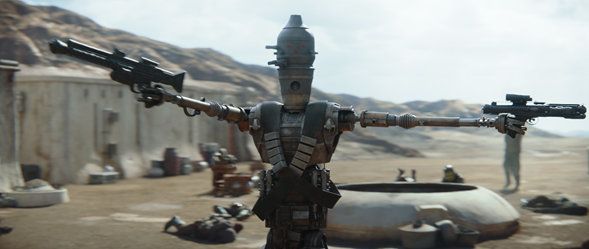

IG-11 y Mando encuentran a su objetivo.

“Este concepto cambió radicalmente la forma en que nos acercamos a los decorados”, continúa Jones. “Todo lo que pones en The Volume está iluminado por el entorno, así que tenemos que asegurarnos de conceptualizar y construir el escenario virtual en su totalidad de cada ubicación en 360o completo. Dado que el actor es, en esencia, una bola de cromo, reflejando lo que está a su alrededor, por lo que cada detalle debe ser realizado «.

A veces utilizaron la fotogrametría como base, pero siempre confiaron en los mismos artistas de efectos visuales que crean entornos para las películas de Star Wars para realizar estos mundos en tiempo real: opciones de iluminación «integradas» establecidas anteriormente en la tubería con alta gama, renderizado con trazado de rayos.

«Elegí los domos del cielo que funcionaron mejor para todas las tomas que necesitábamos para cada secuencia en el Volumen», señala Fraser. «Una vez que fueron elegidos y que ILM hizo su trabajo, no pude subir ni bajar el sol porque la iluminación y las sombras se fundirían, pero podría cambiar el mundo entero para ajustar dónde estaba el punto caliente».

Fraser notó una limitación de los ajustes que se pueden realizar en los domos del cielo una vez que estén activos en el Volumen después de la finalización de ILM. El mundo se puede girar y la posición central se puede cambiar; la intensidad y el color se pueden ajustar, pero la posición real del sol en el domo del cielo no se puede alterar porque ILM ha realizado el trazado de rayos con anticipación y se ha “horneado” en las sombras del terreno por la posición del sol. Esto se hace para minimizar los cálculos necesarios para realizar un trazado de rayos avanzado en tiempo real. Si la posición elegida cambia, esas sombras integradas no cambiarán, solo se verán afectados los elementos que están reservados para el renderizado en tiempo real y el trazado de rayos simple. Esto haría que los fondos parezcan falsos y falsos, ya que la dirección de la iluminación no coincidiría con las sombras incorporadas.

De vez en cuando, se agregaron accesorios de iluminación tradicionales para aumentar la salida del Volumen

En el cuarto episodio, el Mandaloriano busca permanecer oculto y viaja al remoto planeta agrícola de Sorgan y visita la casa común, que es una estructura de tejido de canasta con techo de paja. La casa común real era una miniatura construida por el departamento de arte y luego fotografiada para ser incluida en el mundo virtual. La miniatura estaba iluminada con una única fuente de luz dura que emulaba la luz natural que atravesaba las paredes con techo de paja. “Se podía ver claramente que un lado de la casa común tenía mucha luz y el otro lado estaba en sombras”, recuerda Idoine. “Había puntos calientes en el modelo que realmente se veían muy bien, así que incorporamos“motores ”LED con gobos de barra y barras Charlie [banderas largas] para romper la luz en un patrón similar de tejido de canasta. Debido a esta construcción de tejido de canasta muy abierta y al hecho de que la carga tenía muchos rayos de luz, agregué en forma aleatoria de luz dura al conjunto práctico y se mezcló muy bien «.

El volumen también podría incorporar iluminación virtual a través de la «barra de cerebro», una sección del escenario de sonido similar a Mission Control donde hasta una docena de artistas de ILM, Unreal y Profile se sentaron en las estaciones de trabajo e hicieron la tecnología de la función de volumen. Su trabajo fue capaz de incorporar ajustes de corrección de color sobre la marcha y herramientas de iluminación virtual, entre otros ajustes.

Matt Madden, presidente de Profile y miembro del equipo de Brain Bar, trabajó en estrecha colaboración con Fraser, Idoine y el experto Jeff Webster para incorporar herramientas de iluminación virtual a través de un iPad que se comunicaba con el bar. Podía crear formas de luz en la pared de cualquier tamaño, color e intensidad. Si el director de fotografía quería una fuente grande y suave fuera de cámara, Madden pudo crear una «tarjeta de luz» de blanco justo fuera del frustum. Toda la pared fuera del ángulo de visión de la cámara podría ser una gran fuente de luz de cualquier intensidad o color que los LED pudieran reproducir.

En este caso, una pared LED estaba compuesta por pantallas Roe Black Pearl BP2 con un brillo máximo de 1800 nits. 10,674 liendres equivalen a 1 pie de vela de luz. En el brillo máximo, la pared podría crear una intensidad de aproximadamente 168 pies de velas. Eso es el equivalente a un f / 8 3/4 a 800 ISO (obturador de 180 grados a 24 fps). Si bien el volumen nunca se filmo al máximo en blanco completo, las «tarjetas» de iluminación que se agregaron fueron capaces de emitir este brillo.

Idoine descubrió que una gran fuente adicional para Mando era una banda larga y estrecha de blanco cerca de la parte superior de la pared LED. «Esta fuente envolvente creó una gran apariencia de luz de fondo en el casco de Mando», dice Idoine. Alternativamente, él y Fraser podrían solicitar una banda de luz alta y estrecha en la pared que se refleje en el traje completo de Mando, similar a la forma en que un fotógrafo comercial podría encender una botella de vino o un automóvil, utilizando reflejos especulares para definir la forma.

Además, se podrían agregar banderas negras virtuales, es decir, áreas donde la pared LED se estableció en negro, donde sea necesario y en cualquier tamaño. La transparencia del negro también se podría ajustar a cualquier porcentaje para crear redes virtuales.

Kuiil en su Blerg.

Los entornos LED virtuales tuvieron un gran éxito, pero la pantalla verde tradicional aún jugó un papel importante en la producción de The Mandalorian, y siempre estuvo disponible, especialmente para situaciones en las que el tronco era demasiado ancho para que el sistema respondiera adecuadamente. El volumen también era capaz de producir una pantalla verde virtual en la pared LED, que podía ser de cualquier tamaño y cualquier tono o saturación de verde. Entre los beneficios de la pantalla verde virtual se encontraban que no requería tiempo para configurarlo o instalarlo, y su tamaño podía configurarse para delinear con precisión el sujeto a reemplazar, lo que minimizaba en gran medida y, a veces, incluso eliminaba el derrame verde.

La pantalla verde virtual tiene muchos beneficios. Es casi inmediato y no requiere aparejos, soportes, tiempo para instalar o iluminación adicional. Puede ser de cualquier tamaño, lo que significa que el verde es en realidad solo el tamaño perfecto para delinear el tema a reemplazar. Cuando esto sucede, no hay (o es extremadamente limitado) un derrame verde sobre los actores o reflejado en otros objetos alrededor del set. Esto prácticamente elimina el requisito de eliminar el verde en el correo; un proceso oportuno y tedioso.

Las pantallas verdes virtuales, por supuesto, solo pueden estar en la pared LED. Si es necesario componer las partes inferiores del cuerpo de un actor o una pieza de escenario, entonces se requiere una pantalla verde física ya que el piso no es una pantalla LED y un verde virtual no puede extenderse más allá de la pared LED.

Cuando se emplea el verde, la composición en vivo es posible para el monitor de a bordo del operador de la cámara y el monitor del director para que puedan ver los elementos que se compondrán en la toma y componer el encuadre en consecuencia.

En El mandaloriano el flujo de trabajo se invirtió un poco porque, a diferencia de las producciones típicas, los fondos virtuales y los elementos generados por computadora tenían que terminarse antes de comenzar la fotografía principal. Una vez que el director de fotografía aprobó las ubicaciones y la iluminación en el departamento de arte virtual, las imágenes se entregaron a ILM para su trabajo, que tardó aproximadamente seis semanas en completarse para cada carga. En el momento de la fotografía, se podía producir cierta manipulación y alteración de los elementos virtuales, pero muchas decisiones sobre cobertura, bloqueo e iluminación ya estaban encerradas. Naturalmente, esto requería un grado de colaboración entre el director, el director de fotografía, el diseñador de producción y el visual. -efectos supervisor que estaba más cerca que en una producción típica. Pero, como señala Fraser, también significó que el director de fotografía participó en la creación de todas las imágenes.

“En el flujo de trabajo de producción actual, el director de fotografía viene para preparar la película y luego dispara y luego se le envía hasta el proceso de clasificación; hay tanto trabajo con la imagen en la publicación del que no formamos parte”, afirma Fraser. “Este flujo de trabajo de producción invertido de The Mandalorian mantiene al director de fotografía informado desde el desarrollo de la imagen hasta la imagen final, que a menudo se captura en la cámara. Baz y yo estamos allí para guiar la imagen a lo largo de todo el proceso y esto es de suma importancia. Los directores de fotografía trabajan para diseñar imágenes todos los días, 12 horas al día, y sabemos cómo mirar una imagen y saber de inmediato si es correcta o incorrecta. Los artistas de efectos visuales tienen habilidades asombrosas, pero no siempre tienen la experiencia fotográfica para saber qué está bien o qué está mal y muchas veces lo que planeamos y fotografiamos no se traduce por correo. Con este tipo de flujo de trabajo, supervisamos cada elemento de la toma y tenemos una asociación mucho más estrecha con los efectos visuales para asegurarnos de que funcione con lo que nosotros y el director planeamos y ejecutamos en el set. Conseguimos esa toma final en la cámara y el resultado es bastante sorprendente».

“Personalmente disfruto de esa tubería”, atestigua Favreau. “He tratado de aprender todo lo que pude de la forma en que la animación se acerca al programa de preproducción y producción. Creo que cuanto antes en el proceso puedas resolver los problemas de la historia, más eficiente se vuelve el proceso de producción. La animación tradicionalmente ha liderado el proceso de la historia, mientras que la acción en vivo te permite patear la lata en el camino».

El Bounty Hunter IG-11 está detrás del activo

La capacidad de seleccionar las condiciones de iluminación perfectas parecería permitir al director de fotografía la capacidad de crear el aspecto perfecto para cada toma. Qué maravilloso sería tener la hora mágica todo el día; ¿O incluso toda la semana para el caso? Sin embargo, Fraser es muy consciente de hacer las cosas demasiado perfectas e introducir un artificio innecesario en el estilo visual general del espectáculo. “No siempre querré que sea una luz de fondo perfecta, porque termina pareciendo falsa”, atestigua Fraser. «No es real. En el mundo real, tenemos que filmar en diferentes momentos y tenemos que comprometernos un poco, así que si incorporo un poco de «aspereza», se sentirá más real y menos falso. La idea es introducir un poco de ‘analógico’ para mejorar el aspecto digital, para que se sienta más real y hacer que el efecto sea aún más fluido, como si fueran ubicaciones reales.

“Ahí es donde el sistema es muy bueno”, continúa Fraser. “Te permite ver lo que estás fotografiando en tiempo real. Hay momentos en el mundo real en los que no tienes opción y tienes que disparar algo con luz frontal, pero aún así trabajas para que se vea agradable. Disparas un exterior durante cuatro horas y el sol se mueve constantemente y te quedas atrapado en ese par de tomas que no están a contraluz, pero esa es la realidad. Cuando tienes la capacidad de hacerlo perfecto para cada toma, eso no se siente bien, así que tuvimos que pensar realmente en construir algo analógico. Jon también estaba muy consciente de esto. Acababa de terminar de hacer El rey león. con Caleb [Deschanel, ASC] y tenían escenas que escenificaban bajo la intensa luz solar directa del mediodía para darle a la película una sensación más realista en lugar de hacer todo perfectamente en la hora dorada, eso se siente falso».

«Todos nos sentimos un poco como estudiantes de cine al comienzo de esto», dice Fraser. “Todo es nuevo y fuimos descubriendo las limitaciones y capacidades del sistema a medida que avanzábamos. Continuamente presionamos el sistema para romperlo y ver dónde estaban los bordes del sobre, pero la tecnología continuó evolucionando y nos permitió empujar ese sobre más allá. Decíamos, ‘Oh, hombre, me gustaría que pudiéramos …’ y alguien en el Brain Bar decía: ‘¡Sí, creo que podemos!’ Y al día siguiente tendríamos esa habilidad. Fue bastante sorprendente».

Idoine prepara la cámara para una escena.

Frasier e Idoine obtuvieron nominaciones al Emmy 2020 por su trabajo en esta serie, y hablaron con el entrevistador Larry Sher, ASC sobre su proceso en este video de Club house Conversations:

ESPECIFICACIONES TÉCNICAS

2.39: 1

Captura digital anamórfica

Arri Alexa LF

LF Puerta abierta, ArriRaw, 4.5K

Panavision Ultra Vista, compresión 1.65xStar Wars , The Mandalorian: Greig Fraser , Barry Idoine , Jon Favreau , Pedro Pascal , John Knoll , Richard Bluff , Kathleen Kennedy , Rob Bredow , fotogrametría , Dan Sasaki , Andrew Jones , Matt Madden , Caleb Deschanel. Arri LF , Panavision , Panavision Ultra Vista , anamórfico , pantallas LED